一、爬虫概述

1、爬虫简介

要对数据进行处理和分析,首先就要拥有数据。在当今这个互联网时代,大量信息以网页作为载体,网页也就成了一个很重要的数据来源。但是,网页的数量非常之多,如果以人工的方式从网页上采集数据,工作量相当巨大。从本章开始就要为大家介绍一个自动采集网页数据的利器——爬虫。

爬虫是指按照一定的规则自动地从网页上抓取数据的代码或脚本,它能模拟浏览器对存储指定网页的服务器发起请求,从而获得网页的源代码,再从源代码中提取出需要的数据。使用爬虫获取数据,具有全天候、无人值守、效率高等优点。

爬虫有什么用:

- 市场分析:电商分析、商圈分析、一二级市场分析等

- 市场监控:电商、新闻、房源监控等

- 商机发现:招投标情报发现、客户资料发掘、企业客户发现等

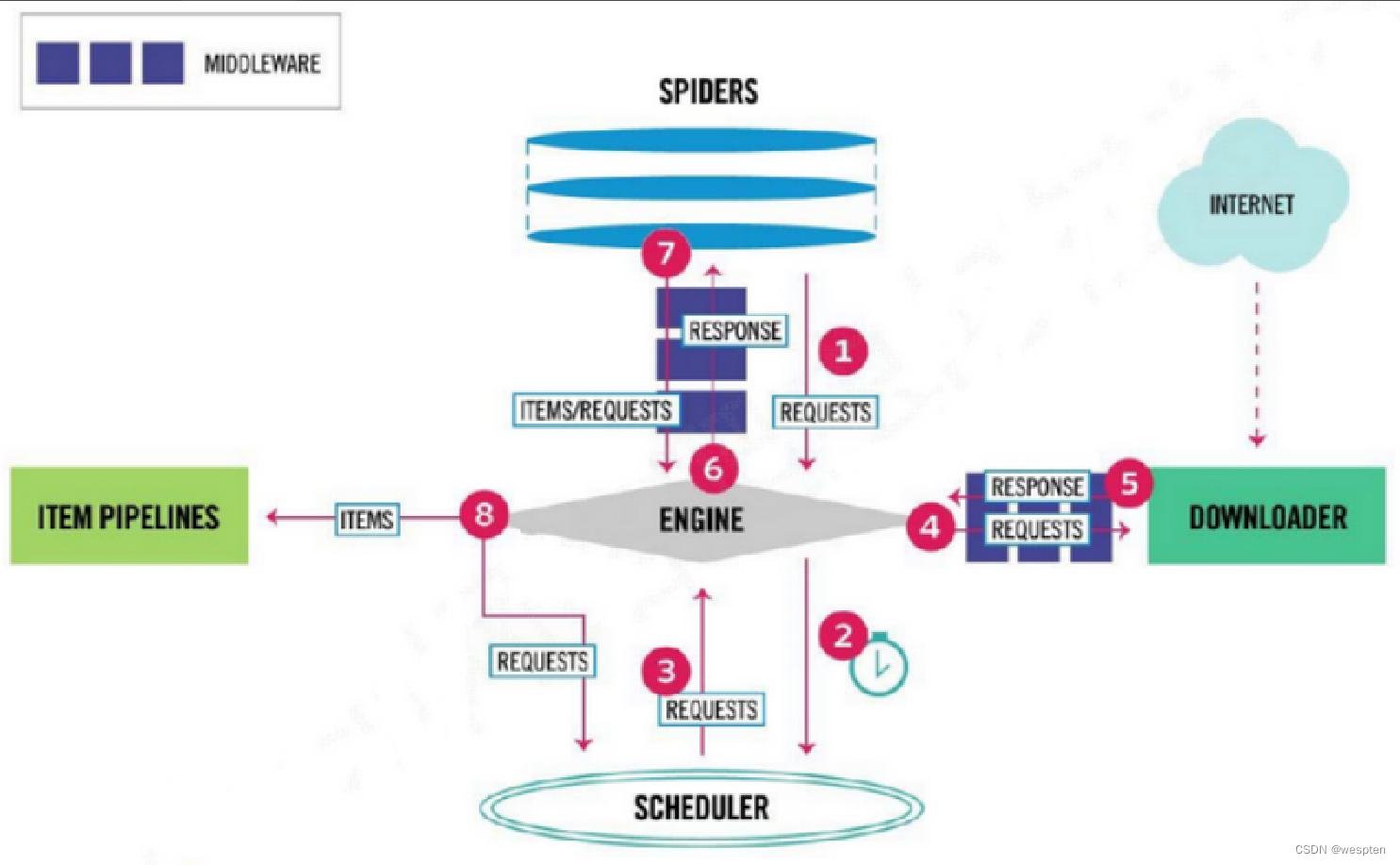

通用的网络爬虫框架:

-

挑选种子 URL;

-

将这些 URL 放入待抓取的 URL 队列;

-

取出待抓取的 URL,下载并存储进已下载网页库中。此外,将这些 URL 放入已抓取 URL 队列;

-

分析已抓取队列中的 URL,并且将 URL 放入待抓取 URL 队列,从而进入下一循环。

2、网页结构

我们平时在浏览器中看到的网页其实是浏览器根据网页的源代码进行渲染后呈现在浏览器窗口中的效果。网页的源代码规定了网页中要显示的文字、图片等信息的内容和格式,我们想要提取的数据就隐藏在源代码中。为了准确地提取数据,需要分析网页的源代码,摸清网页的结构,找到数据的存储位置,从而制定出提取数据的规则,编写出爬虫的代码。因此,下面先来学习网页源代码和网页结构的基础知识。

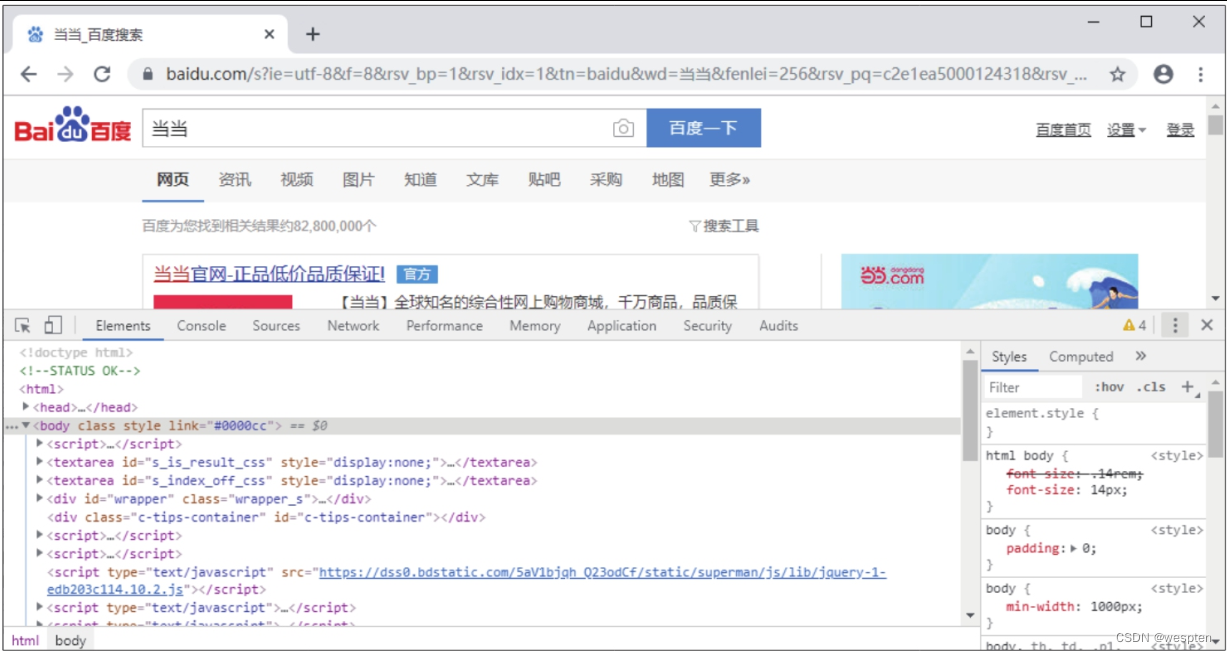

1. 查看网页的源代码

许多读者可能知道,右击网页的任意空白处,在弹出的快捷菜单中执行“查看页面源代码”命令,就能看到网页的源代码。但是这种查看网页源代码的方式不便于我们分析数据在源代码中所处的位置。这里要介绍的是谷歌浏览器自带的一个数据挖掘利器——开发者工具,它能直观地指示网页内容和源代码的对应关系,帮助我们更快捷地定位数据。

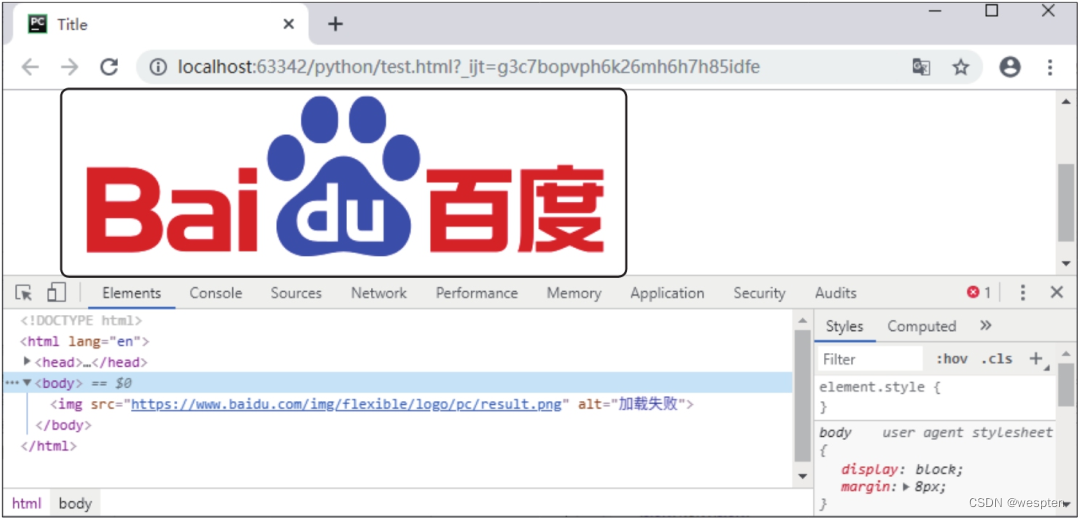

例如,在谷歌浏览器中使用百度搜索引擎搜索“当当”,然后按【F12】键或按快捷键【Shift+Ctrl+I】,即可打开开发者工具,界面如下图所示。

此时窗口的上半部分显示的是网页,下半部分默认显示的是“Elements”选项卡,该选项卡中的内容就是网页源代码。源代码中被“<>”括起来的文本称为Elements对象或网页元素,我们需要提取的数据就存放在这些Elements对象中。

单击开发者工具左上角的元素选择工具,按钮图标颜色变成蓝色,再将鼠标指针移动到窗口上半部分的任意网页元素上,该元素会被突出显示,单击元素,则窗口下半部分中该元素对应的网页源代码会被选中,同时元素选择工具的按钮图标颜色恢复灰色。

如下图所示为利用元素选择工具选中网页左上角的百度徽标的效果。

2. 网页结构的组成

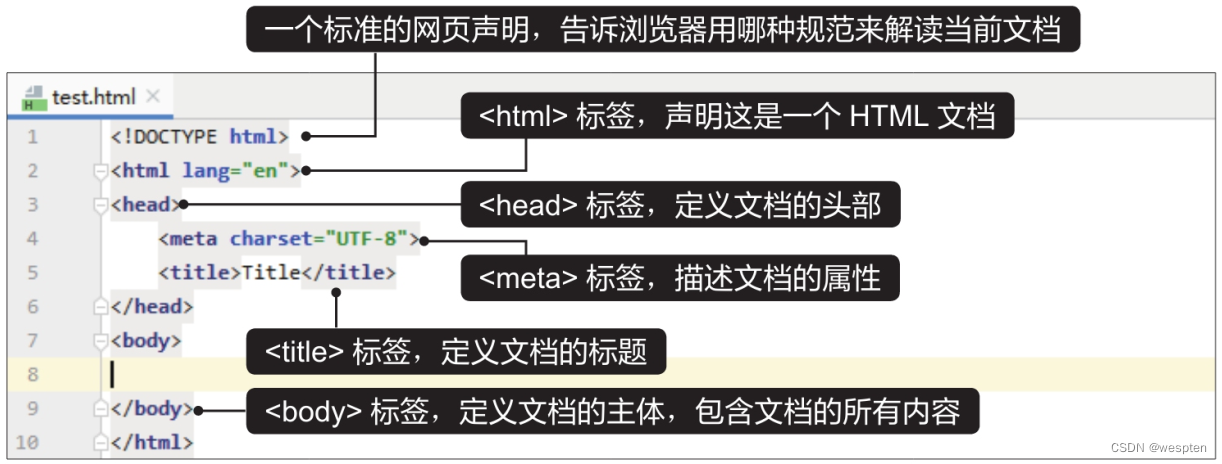

前面利用开发者工具查看了网页的源代码和存放数据的网页元素,大家对网页源代码应该有了初步的认识。将通过搭建一个简单的网页来帮助大家进一步认识网页结构的基本组成。

先使用PyCharm编辑器创建一个HTML文档。启动PyCharm,执行“File>New”菜单命令,在弹出的界面中单击“HTML File”,再在弹出的界面中输入文件名“test”,按【Enter】键,PyCharm会自动补全文件的扩展名,得到一个名为“test.html”的HTML文档。

该HTML文档的内容并不是空白的,PyCharm会自动生成一些网页源代码,搭建出一个HTML文档的基本框架,如下图所示。

单击代码编辑区右上方的浏览器图标,如下图所示,就能用对应的浏览器打开该HTML文档。

从网页源代码可以看出,大部分网页元素是由格式类似“<×××>文本内容</×××>”的源代码来定义的,这些“<×××></×××>”称为HTML标签。在PyCharm自动生成的网页源代码的基础上,我们可以继续添加HTML标签来充实HTML文档的内容。下面就来介绍一些常用的HTML标签。

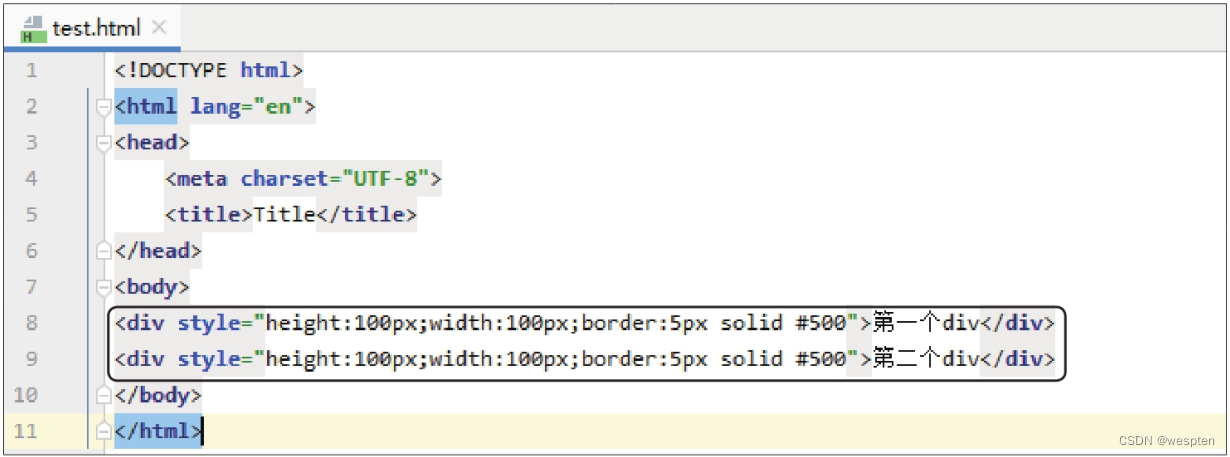

1)<div>标签

<div>标签定义了一个区块,表示在网页中划定一个区域来显示内容,区块的宽度和高度分别用参数width和height来定义,区块边框的格式(如粗细、线型、颜色等)用参数border来定义,这些参数都存放在style属性下。这里在“test.html”文件的<body>标签下方输入如下图所示的两行代码,添加两个<div>标签,即添加两个区块。

添加的<div>标签的代码定义了两个区块的宽度和高度均为100 px,边框的格式也相同,只是区块中显示的文本内容不同。在谷歌浏览器中打开修改后的“test.html”文件,并按【F12】键打开开发者工具查看网页源代码,效果如下图所示。可以看到,网页源代码经过浏览器的渲染后得到的网页中显示了两个正方形,正方形里的文本就是源代码中被<div>标签括起来的文本。

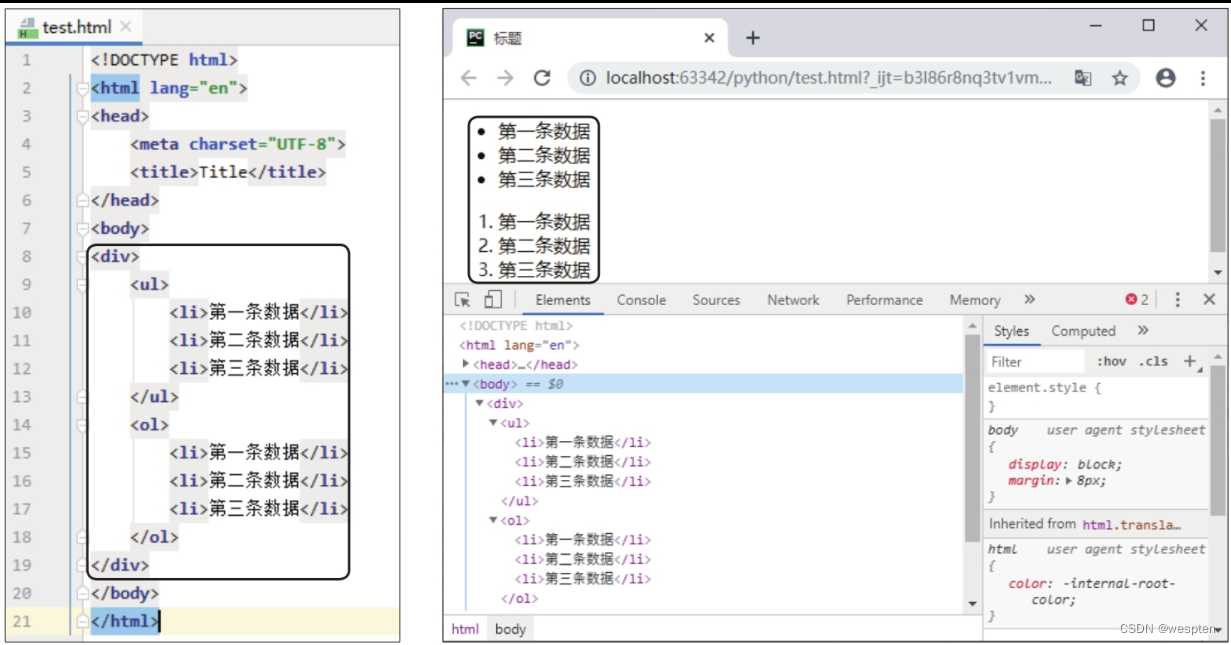

2)<ul>标签、<ol>标签和<li>标签

<ul>标签和<ol>标签分别用于定义无序列表和有序列表。<li>标签位于<ul>标签或<ol>标签之下,一个<li>标签表示列表中的一项。无序列表中的<li>标签在网页中默认显示为小圆点格式的项目符号;有序列表中的<li>标签在网页中默认显示为数字序号。

在<body>标签下添加一个<div>标签,再在<div>标签下添加<ul>、<ol>和<li>标签,如下左图所示。使用谷歌浏览器打开修改后的网页,效果如下右图所示。

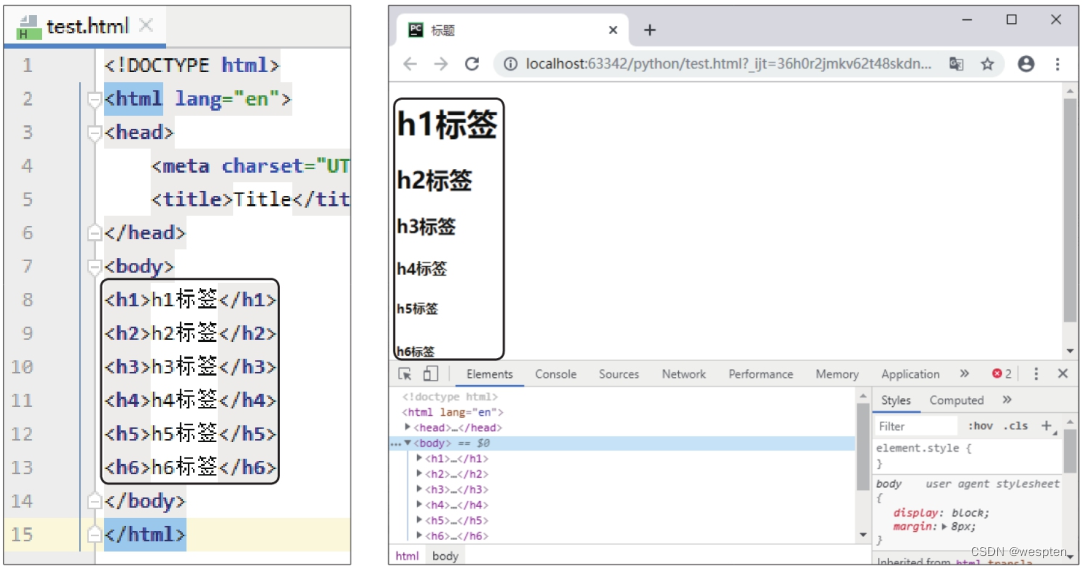

3)<h>标签

<h>标签用于定义标题,它细分为<h1>到<h6>共6个标签,<h1>标签定义的标题的字号最大,<h6>标签定义的标题的字号最小。

在<body>标签下添加<h>标签的代码,如下左图所示。使用谷歌浏览器打开修改后的网页,效果如下右图所示。

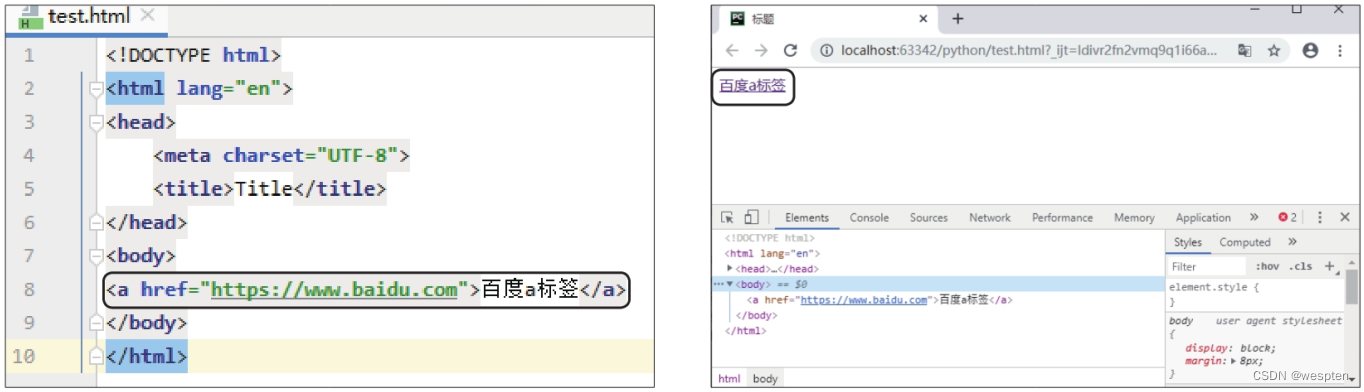

4)<a>标签

<a>标签用于定义链接,在网页中单击链接,可以跳转到<a>标签的href属性指定的页面地址。

在<body>标签下添加<a>标签的代码,如下左图所示。使用谷歌浏览器打开修改后的网页,效果如下右图所示,如果单击链接“百度a标签”,会跳转到百度首页。

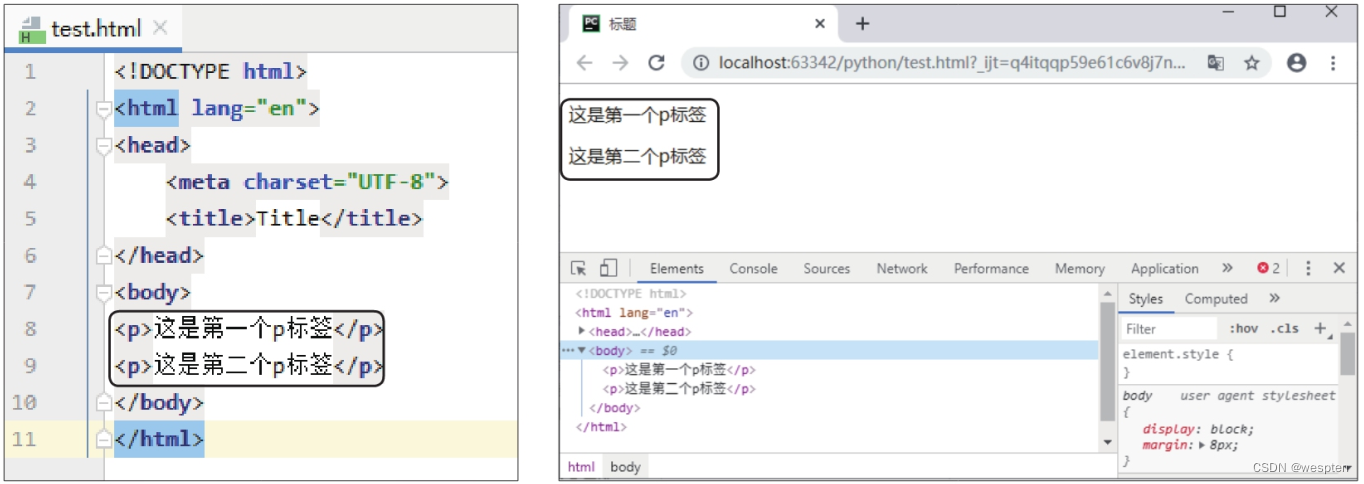

5)<p>标签

<p>标签用于定义段落,不设置样式时,一个<p>标签的内容在网页中显示为一行。

在<body>标签下添加<p>标签的代码,如下左图所示。使用谷歌浏览器打开修改后的网页,效果如下右图所示。

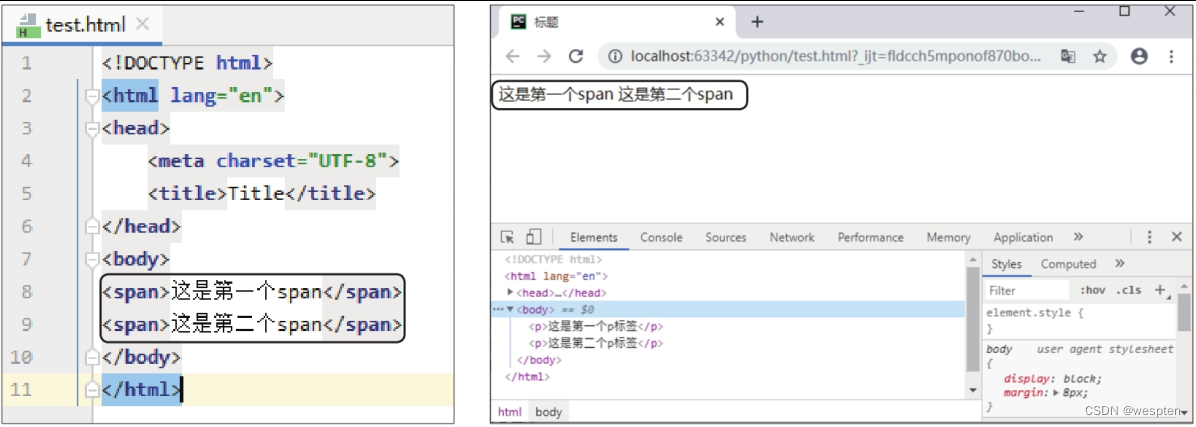

6)<span>标签

<span>标签可以将网页元素放在一行中显示。在<body>标签下添加<span>标签的代码,如下右图所示。使用谷歌浏览器打开修改后的网页,效果如下右图所示。

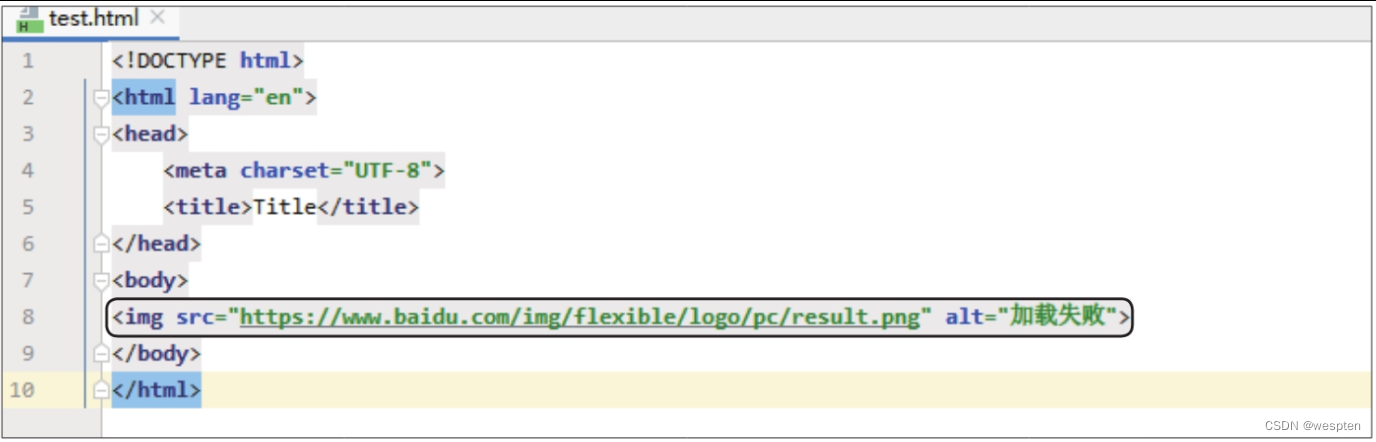

7)<img>标签

<img>标签主要用于显示图片,src属性指定图片的地址,alt属性指定图片无法正常加载时的替换文本。在<body>标签下添加<img>标签的代码,如下图所示。

使用谷歌浏览器打开修改后的网页,可看到图片显示在网页中的效果,如下图所示。

3. 百度新闻页面结构剖析

通过前面的学习,相信大家对网页的结构和源代码已经有了基本的认识。下面对百度新闻的页面结构进行剖析,帮助大家进一步理解各个HTML标签的作用。

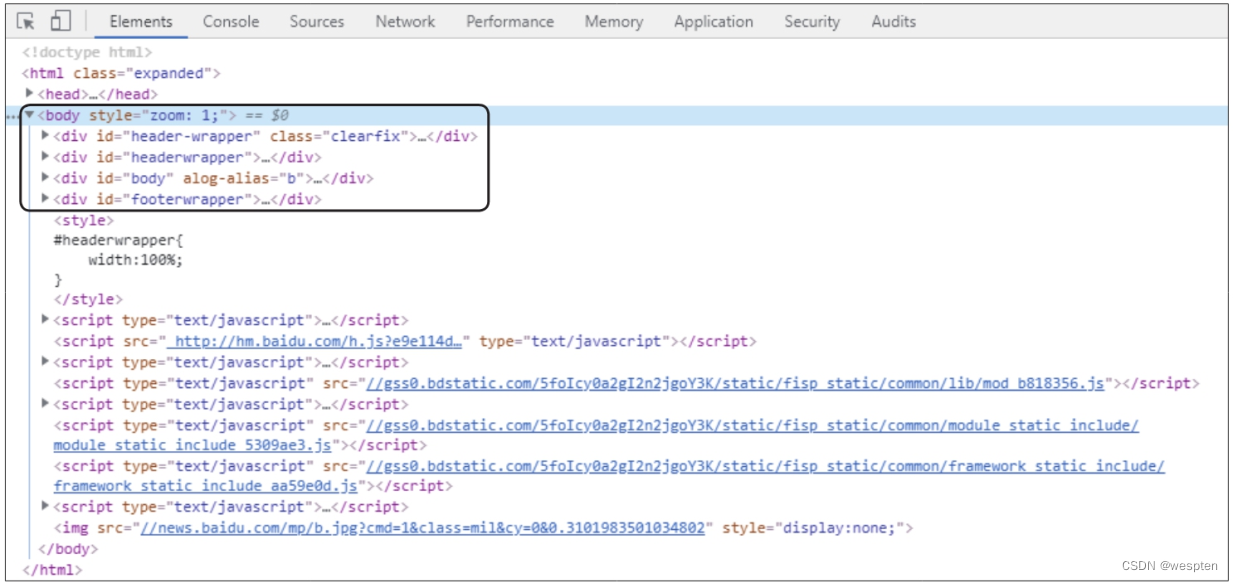

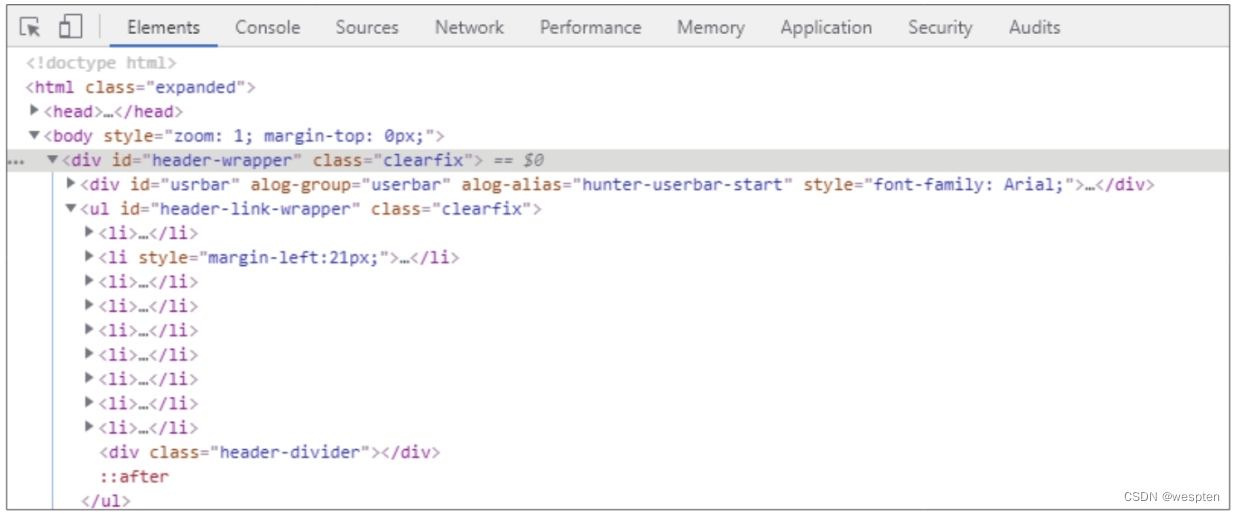

在谷歌浏览器的地址栏中输入网址https://news.baidu.com/sports,按【Enter】键,打开百度新闻的体育频道。然后按【F12】键打开开发者工具,在“Elements”选项卡下可以看到网页的源代码,如下图所示。其中的<body>标签下存放的就是该网页的主要内容,<body>标签下又包含4个<div>标签和一些<script>标签,<script>标签主要与JavaScript相关,这里不做具体介绍。

我们需要重点查看4个<div>标签。在网页源代码中分别单击前3个<div>标签,可以在窗口的上半部分看到分别在网页中选中了3块区域,如下图所示。

单击第4个<div>标签,可看到选中了网页底部的区域,如下图所示。

单击每个<div>标签前方的折叠/展开按钮,可以看到该<div>标签下包含的标签,可能是另一个<div>标签,也可能是<ul>标签、<li>标签等,如下图所示,这些标签同样可以继续展开。这样一层层地剖析,就能大致了解网页的结构组成和源代码之间的对应关系。

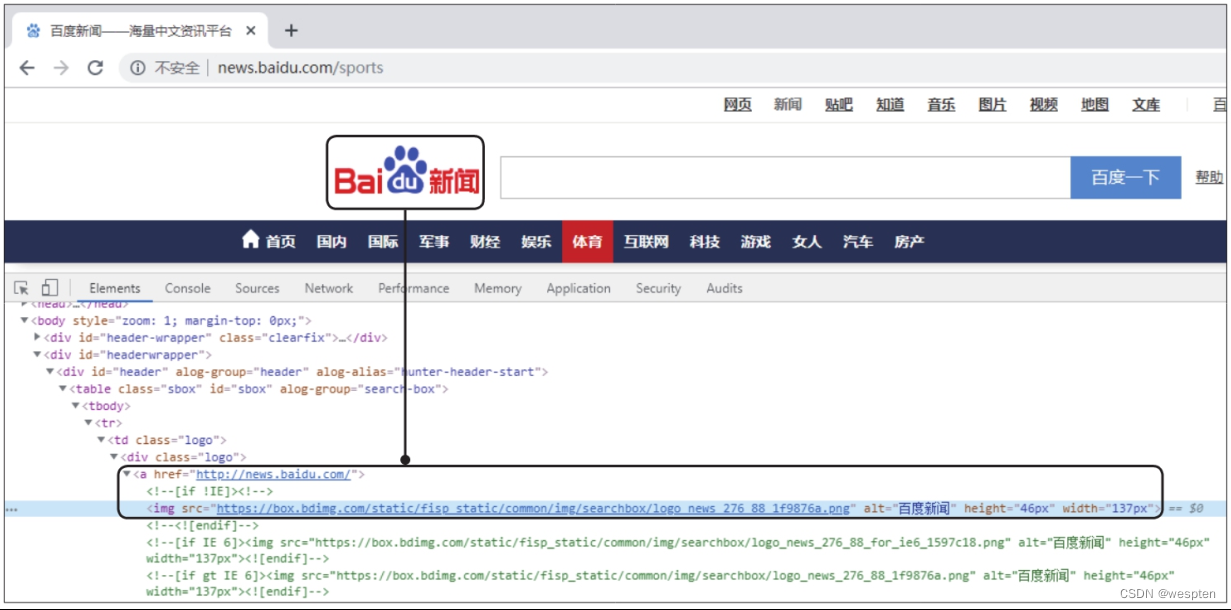

前面介绍<a>标签时定义的是一个文字链接,而许多网页的源代码中的<a>标签下还包含<img>标签,这表示该链接是一个图片链接。如下图所示为百度新闻页面中的一个图片链接及其对应的源代码,在网页中单击该图片,就会跳转到<a>标签中指定的页面地址。

经过剖析可以发现,百度新闻页面中的新闻标题和链接基本是由大量<li>标签下嵌套的<a>标签定义的。取出<a>标签的文本和href属性值,就能得到每条新闻的标题和链接。

3、网页两种加载方式

只有同步加载的数据才能直接在网页源代码中直接查看到,异步加载的数据直接查看网页源代码是看不到的。

- 同步加载:改变网址上的某些参数会导致网页发生改变,例如:www.itjuzi.com/company?page=1(改变 page= 后面的数字,网页会发生改变)。

- 异步加载:改变网址上的参数不会使网页发生改变,例如:www.lagou.com/gongsi/(翻页后网址不会发生变化)。

- 同步任务:在主线程上排队执行的任务,只有前一个任务执行完毕,才能执行后一个任务。

- 异步任务:不进入主线程,而进入"任务队列"(task queue)的任务。有等主线程任务执行完毕,"任务队列"开始通知主线程,请求执行任务,该任务才会进入主线程执行(如回调函数)。

验证网页是同步还是异步加载的方法:把 JavaScript 由“允许”改为“阻止”,重新刷新页面。若网页正常加载,说明该网页的加载方式是同步加载;若网页没有正常加载,说明该网页的加载方式是异步加载。

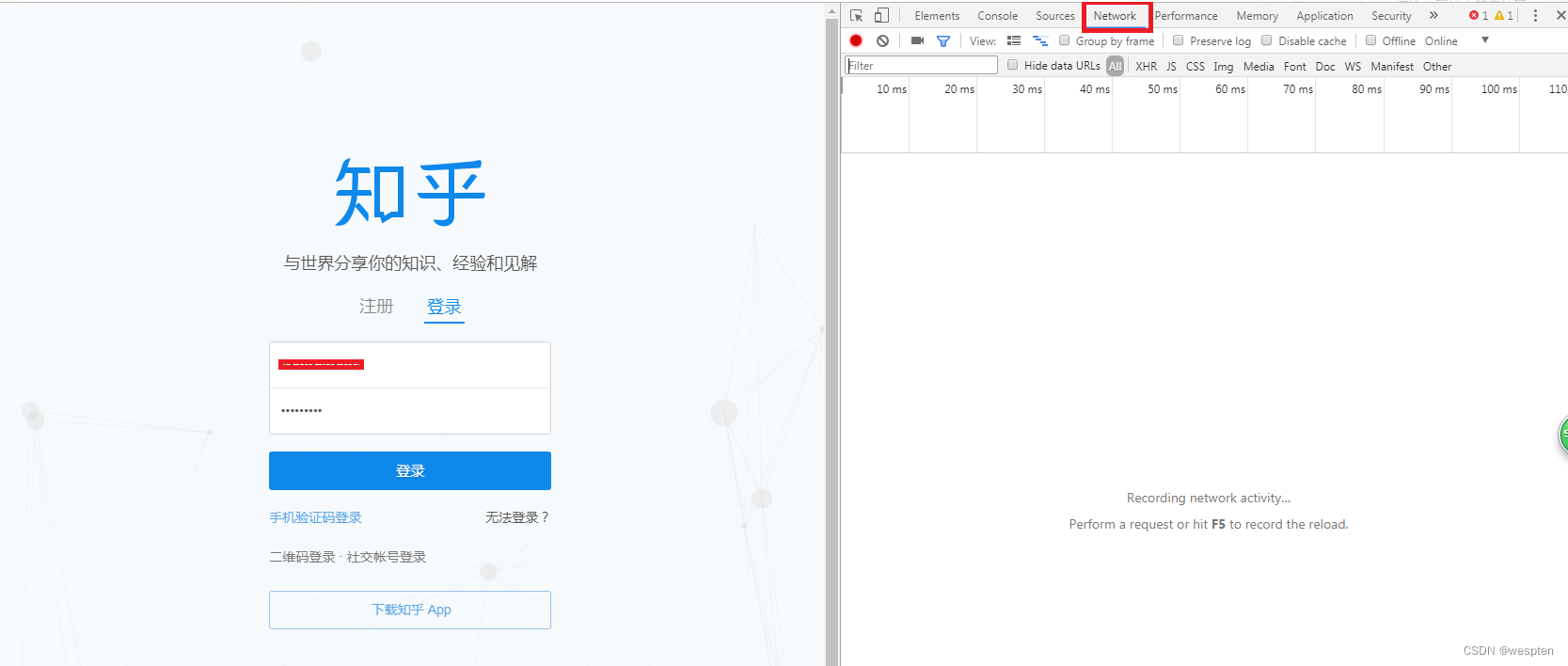

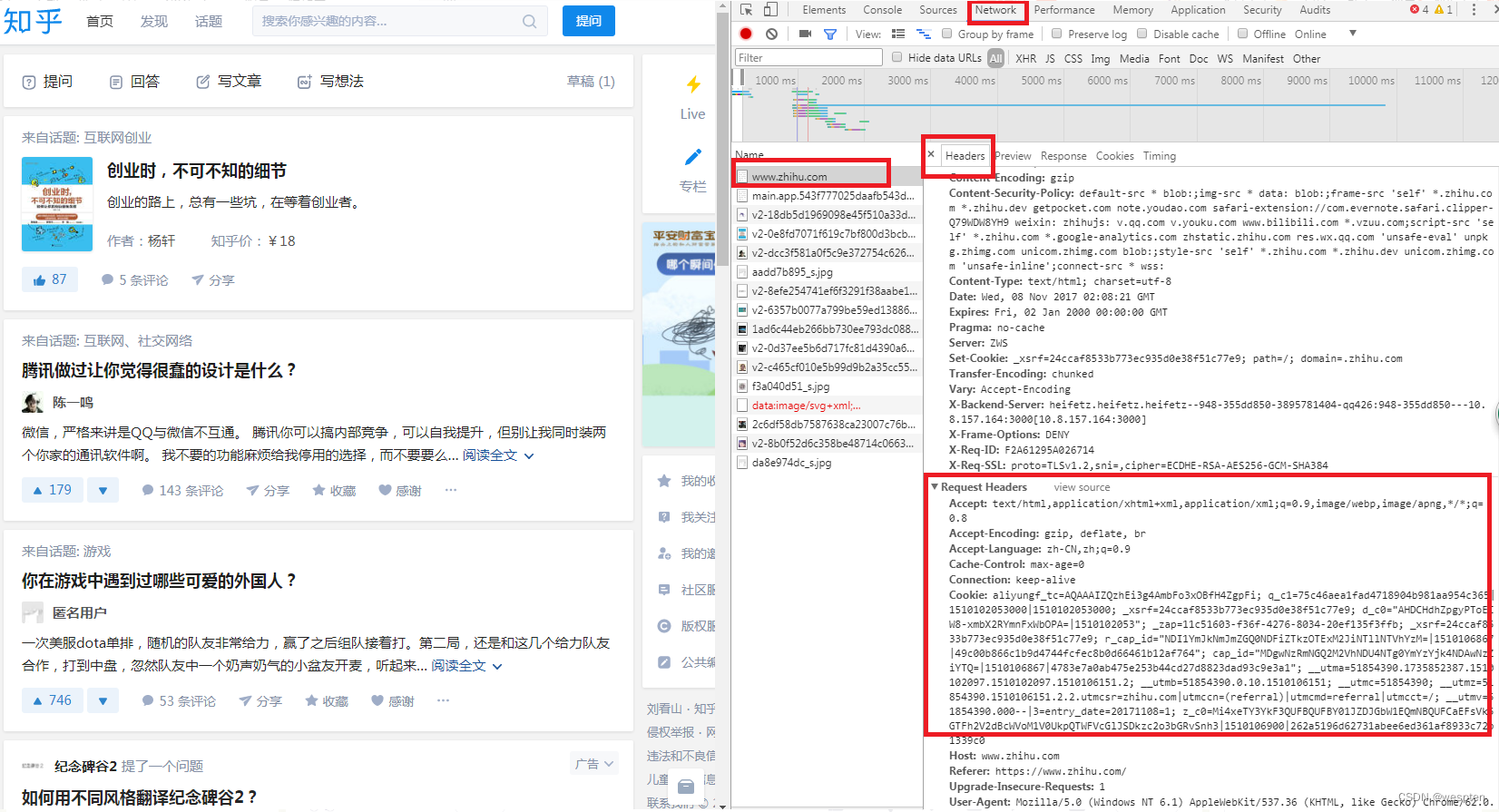

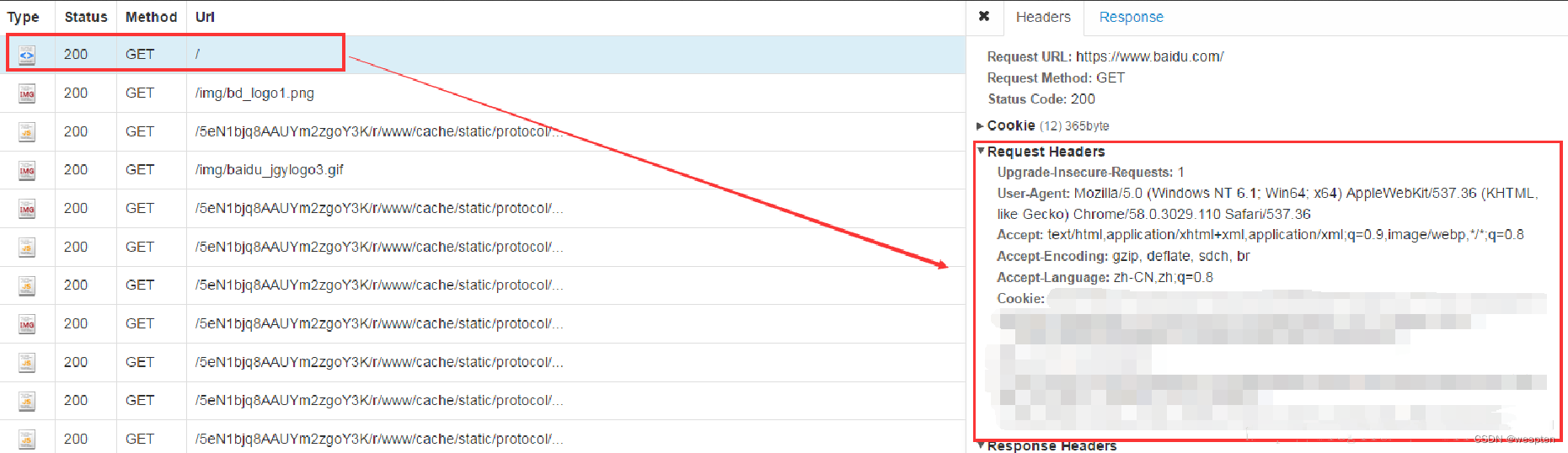

4、网页请求

以 chrome 浏览器为例,在网页上点击鼠标右键,选择“检查”(或者直接 F12),选择“network”,刷新页面,选择 ALL 下面的第一个链接,这样就可以看到网页的各种请求信息。

请求头(Request Headers):

- Accept: text/html,image/* (浏览器可以接收的类型)

- Accept-Charset: ISO-8859-1 (浏览器可以接收的编码类型)

- Accept-Encoding: gzip,compress (浏览器可以接收压缩编码类型)

- Accept-Language: en-us,zh-cn (浏览器可以接收的语言和国家类型)

- Host: www.it315.org:80 (浏览器请求的主机和端口)

- If-Modified-Since: Tue, 11 Jul 2000 18:23:51 GMT (某个页面缓存时间)

- Referer: http://www.it315.org/index.jsp (请求来自于哪个页面)

- User-Agent: Mozilla/4.0 (compatible; MSIE 5.5; Windows NT 5.0) (浏览器相关信息)

- Cookie: (浏览器暂存服务器发送的信息)

- Connection: close(1.0)/Keep-Alive(1.1) (HTTP请求的版本的特点)

- Date: Tue, 11 Jul 2000 18:23:51 GMT (请求网站的时间)

响应头(Response Headers):

- Location: http://www.it315.org/index.jsp (控制浏览器显示哪个页面)

- Server: apache tomcat (服务器的类型)

- Content-Encoding: gzip (服务器发送的压缩编码方式)

- Content-Length: 80 (服务器发送显示的字节码长度)

- Content-Language: zh-cn (服务器发送内容的语言和国家名)

- Content-Type: image/jpeg; charset=UTF-8 (服务器发送内容的类型和编码类型)

- Last-Modified: Tue, 11 Jul 2000 18:23:51 GMT (服务器最后一次修改的时间)

- Refresh: 1;url=http://www.it315.org (控制浏览器1秒钟后转发URL所指向的页面)

- Content-Disposition: attachment; filename=aaa.jpg (服务器控制浏览器下载方式打开文件)

- Transfer-Encoding: chunked (服务器分块传递数据到客户端)

- Set-Cookie: SS=Q0=5Lb_nQ; path=/search (服务器发送Cookie相关的信息)

- Expires: -1 (服务器控制浏览器不要缓存网页,默认是缓存)

- Cache-Control: no-cache (服务器控制浏览器不要缓存网页)

- Pragma: no-cache (服务器控制浏览器不要缓存网页)

- Connection: close/Keep-Alive (HTTP请求的版本的特点)

- Date: Tue, 11 Jul 2000 18:23:51 GMT (响应网站的时间)

二、抓包工具Fiddler

1、Fiddler简介

Fiddler是一个C#实现的浏览器抓包和调试工具,fiddler启用后作为一个proxy存在于浏览器和服务器之间,从中监测浏览器与服务器之间的http/https级别的网络交互。

目前可以支持各种主要浏览器如IE, Chrome, FireFox, Safari, Opera。Fiddler是最强大最好用的Web调试工具之一,已更新至4.4.9.9版。它能记录所有客户端和服务器的http和https请求,允许用户监视,设置断点,甚至修改输入输出数据。

主要用途:

- http/https监测与分析

- 动态修改请求或回复

- 断点调试

- 自动回复

- 自定义脚本扩展

软件下载:

点击下载

2、Fiddler使用方法

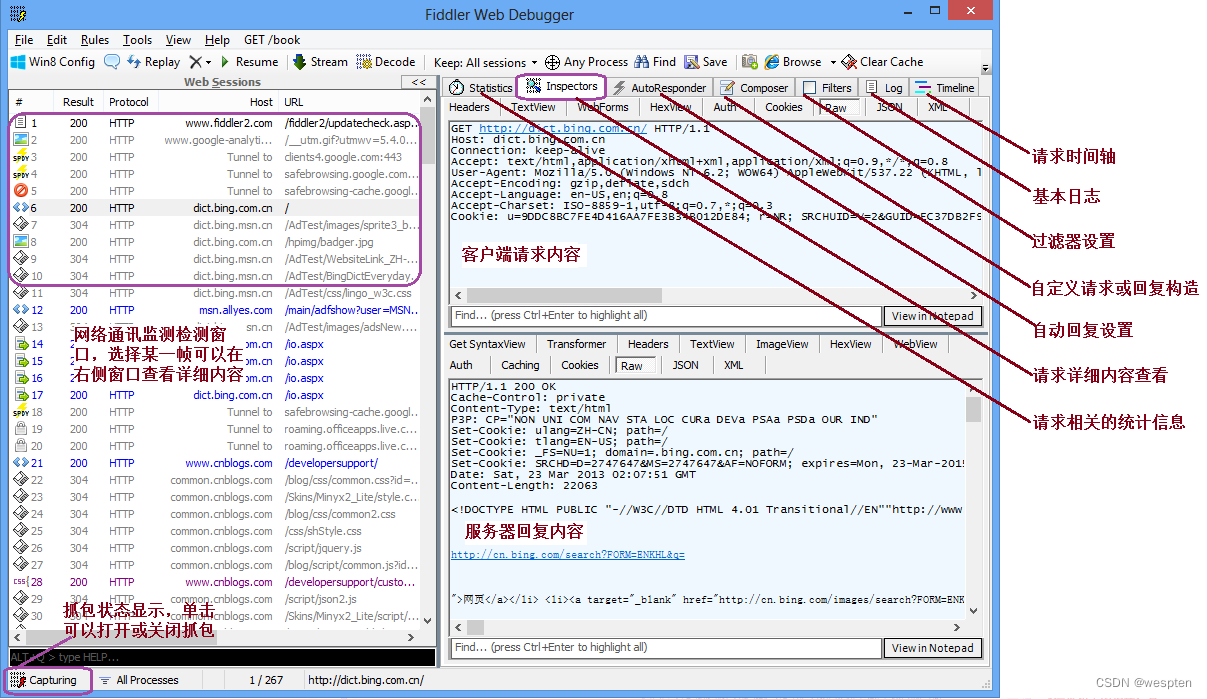

1. 基本界面

Fiddler的界面通过多个标签页形式显示各种类型的信息,最常用的标签页为Inspectors,通过这个标签页可以查看抓取的网络请求和回复的详细内容。

抓包每一帧前面都有不同的图标表示各种请求类型或状态:

2. 抓包方法

开发fiddler之后默认情况下就是抓包状态,可以查看界面左下角显示capturing,如果没有显示,单击此处可以开始抓包。

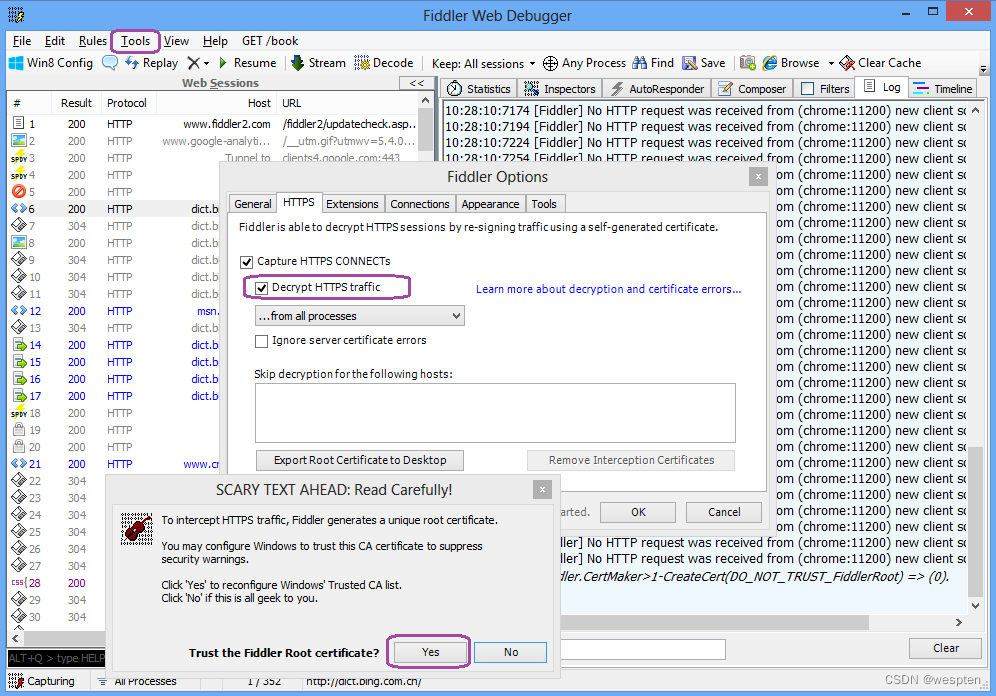

如果访问的网站是https网站,则需要通过Tools - Fiddler Options - Https - Decrypt Http Traffic来设置将https解密。

通过浏览器发送请求(在windows平台上此处并不限于浏览器,只要程序是通过winhttp或者wininet发送请求都可以被监测到)。

在收到回复后回到fiddler查看抓包内容。

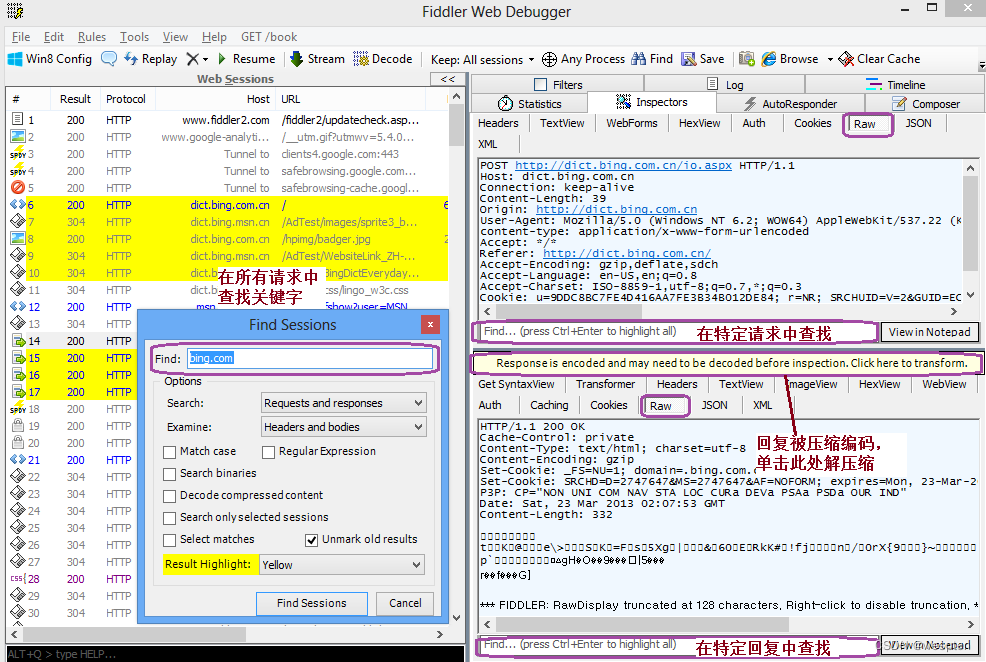

3. 关键字查找

通过Ctr+F调出查找对话框,在全局查找关键字。

在选中特定请求之后可以在Inspecters - Raw中分别在特定的请求或回复中查找内容。

如果回复被压缩过,通过单击提示按钮可以将内容解压缩。

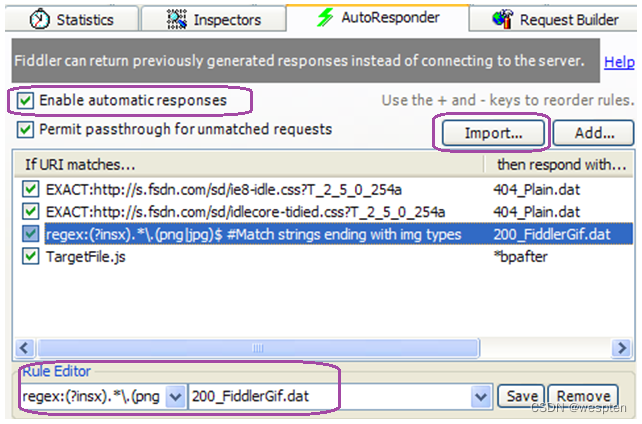

4. 自动回复

请求自动回复应用也比较广,例如将其他机器抓包倒入自动回复,然后再本机回放重现问题;或者动态调试过程中不希望有些请求去调用服务器,而在自动回复中配制或者进行相应的更改直接查看效果。

- 切换到自动回复(AutoResponder)标签页

- 选中Enable automatic responses

- 点击Import按钮导入抓包的saz文件

- 可以通过默认Url或者通过Rule Editor来修改请求匹配规

5. 断点设置

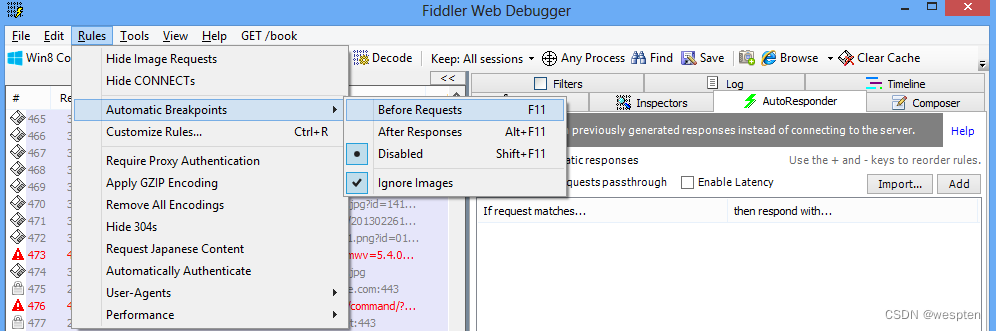

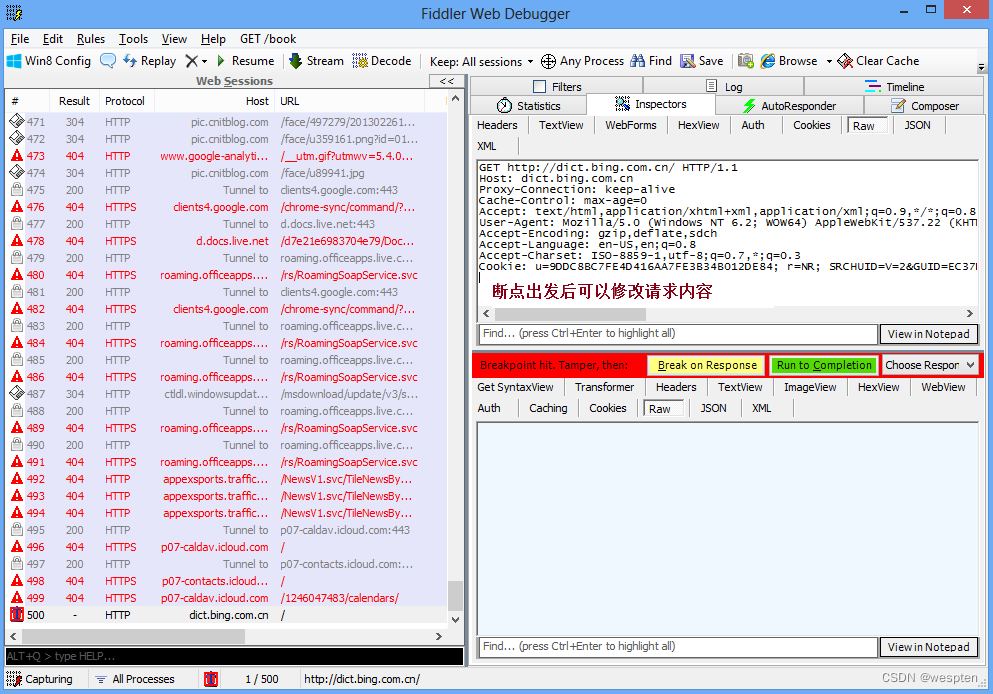

通过Rules - Automatic Breakpoints - Before Requests/After Response设置断点:

断点在请求或者回复受到后触发,可以动态的修改请求或者回复来进行不同的测试:

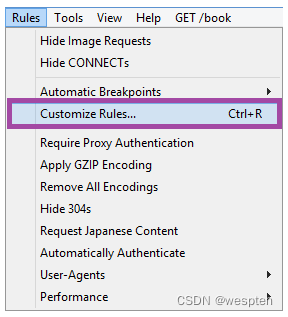

3、自定义扩展脚本

Fiddler支持通过Jscript方式扩展功能,比如自动通过脚本对请求及回复进行处理。

具体的实例可以参考fiddler提供的实例代码:

Fiddler | Web Debugging Proxy and Troubleshooting Solutions

以下是两个简单例子

以下提到的方法可以在CustomRule.js中找到并进行相应的更改,可以通过Rules - CustomRule来打开CustomRule.js。

目标 需要添加的代码 需要添加代码的方法

Add a request header oSession.oRequest["NewHeaderName"] = "New header value"; nBeforeRequest

Delete a response header oSession.oResponse.headers.Remove("Set-Cookie"); OnBeforeResponse

三、网络爬虫库

前面介绍的是如何在浏览器中获取和查看网页的源代码,那么如何在Python中获取网页的源代码呢?

这里介绍Python的一个第三方模块requests,它可以模拟浏览器发起HTTP或HTTPS协议的网络请求,从而获取网页源代码。

1、request模块

Python中有多种库可以用来处理http请求,比如urllib、requests库等。

requests VS urllib:

- urllib 和 urllib2 是相互独立的模块,python3.0 以上把 urllib 和 urllib2 合并成一个库了,requests 库使用了 urllib3。

- requests 库的口号是“HTTP For Humans”(为人类使用 HTTP 而生),因此比起 urllib 包的繁琐,requests 库特别简洁和容易理解。

Requests库的主要方法:

Response对象的属性:

- r.status_code:http 请求的返回状态,200 表示连接成功(HTTP 状态码)

- r.text:返回对象的文本内容

- r.content:猜测返回对象的二进制形式

- r.encoding:分析返回对象的编码方式

- r.apparent_encoding:响应内容编码方式(备选编码方式)

1. get 请求

# 使用 get 方法访问网页资源

>>> resp = requests.get("http://www.baidu.com")

# 返回响应对象

>>> resp

<Response [200]>

# 状态码

>>> resp.status_code

200

# 请求地址

>>> resp.url

'http://www.baidu.com/'

# 用 resp.encoding 对 resp.content 进行解码后的字符串

>>> print(resp.text[:100])

<!DOCTYPE html>

<!--STATUS OK--><html> <head><meta http-equiv=content-type content=text/html;charse

# 请求所使用的编码

>>> resp.encoding

'ISO-8859-1'

# 以字节方式获取的响应内容

>>> print(resp.content[:100])

b'<!DOCTYPE html>\r\n<!--STATUS OK--><html> <head><meta http-equiv=content-type content=text/html;charse'get 方法带请求参数:

# 方式1:使用字典的请求参数

>>> payload = {"key1":"value1", "key2":"value2"}

>>> resp = requests.get("http://httpbin.org/get", params=payload)

>>> print(resp.text)

{

"args": {

"key1": "value1",

"key2": "value2"

},

"headers": {

"Accept": "*/*",

"Accept-Encoding": "gzip, deflate",

"Host": "httpbin.org",

"User-Agent": "python-requests/2.23.0",

"X-Amzn-Trace-Id": "Root=1-5fb685f6-23b6c5e864d8dc4e41e8de27"

},

"origin": "113.116.22.63",

"url": "http://httpbin.org/get?key1=value1&key2=value2"

}

# 方式2:使用字典+列表的请求参数

>>> payload = {"key1":"value1", "key2":["value2", "value3"]}

>>> resp = requests.get("http://httpbin.org/get", params=payload)

>>> resp.url

'http://httpbin.org/get?key1=value1&key2=value2&key2=value3'2. post 请求

post 请求方法有两种方式:

- 表单提交:提交字典或二维元组的数据

- 非表单提交:提交 json 格式的数据

示例一:表单提交的两种方式

# 方式一:使用字典

>>> resp = requests.post("http://httpbin.org/post", data={"key": "value"})

>>> print(resp.text)

{

"args": {},

"data": "",

"files": {},

"form": {

"key": "value"

},

"headers": {

"Accept": "*/*",

"Accept-Encoding": "gzip, deflate",

"Content-Length": "9",

"Content-Type": "application/x-www-form-urlencoded",

"Host": "httpbin.org",

"User-Agent": "python-requests/2.23.0",

"X-Amzn-Trace-Id": "Root=1-5fb67ae5-6c15961202281a1d70522539"

},

"json": null,

"origin": "113.116.22.63",

"url": "http://httpbin.org/post"

}

# 方式二:使用二维元组

>>> payload = (('key1', 'value1'), ('key1', 'value2'))

>>> resp = requests.post("http://httpbin.org/post", data=payload)

>>> print(resp.text)

{

"args": {},

"data": "",

"files": {},

"form": {

"key1": [

"value1",

"value2"

]

},

"headers": {

"Accept": "*/*",

"Accept-Encoding": "gzip, deflate",

"Content-Length": "23",

"Content-Type": "application/x-www-form-urlencoded",

"Host": "httpbin.org",

"User-Agent": "python-requests/2.23.0",

"X-Amzn-Trace-Id": "Root=1-5fb67b74-716bca001516d46950d0d762"

},

"json": null,

"origin": "113.116.22.63",

"url": "http://httpbin.org/post"

}示例二:非表单提交

import requests

# 方式1:使用json.dumps

import json

url = 'http://httpbin.org/post'

payload = {'some': 'data'}

resp = requests.post(url, data=json.dumps(payload))

>>> print(resp.text)

{

"args": {},

"data": "{\"some\": \"data\"}",

"files": {},

"form": {},

"headers": {

"Accept": "*/*",

"Accept-Encoding": "gzip, deflate",

"Content-Length": "16",

"Host": "httpbin.org",

"User-Agent": "python-requests/2.23.0",

"X-Amzn-Trace-Id": "Root=1-5fb67c87-78a1dd216e987f0226d5b97a"

},

"json": {

"some": "data"

},

"origin": "113.116.22.63",

"url": "http://httpbin.org/post"

}

# 方式2:使用内置参数 json

url = 'http://httpbin.org/post'

payload = {'some': 'data'}

resp = requests.post(url, json=payload)3. 其他请求方法

# put:从客户端向服务器传送的数据取代指定的文档的内容

>>> r = requests.put('http://httpbin.org/put', data={'key':'value'})

>>> print("put:", r.text)

put: {

"args": {},

"data": "",

"files": {},

"form": {

"key": "value"

},

"headers": {

"Accept": "*/*",

"Accept-Encoding": "gzip, deflate",

"Content-Length": "9",

"Content-Type": "application/x-www-form-urlencoded",

"Host": "httpbin.org",

"User-Agent": "python-requests/2.23.0",

"X-Amzn-Trace-Id": "Root=1-5fb6808c-7842d5b450d1777139efab8e"

},

"json": null,

"origin": "113.116.22.63",

"url": "http://httpbin.org/put"

}

# delete:请求服务器删除指定的页面

>>> r = requests.delete('http://httpbin.org/delete')

>>> print("delete:", r.text)

delete: {

"args": {},

"data": "",

"files": {},

"form": {},

"headers": {

"Accept": "*/*",

"Accept-Encoding": "gzip, deflate",

"Content-Length": "0",

"Host": "httpbin.org",

"User-Agent": "python-requests/2.23.0",

"X-Amzn-Trace-Id": "Root=1-5fb6808e-042c04c61a6257820e4ff404"

},

"json": null,

"origin": "113.116.22.63",

"url": "http://httpbin.org/delete"

}

# head:类似于get请求,只不过返回的响应中没有具体的内容,用于获取报头

>>> r = requests.head('http://httpbin.org/get')

>>> print("head:", r.text)

head:

>>> print(r.headers)

{'Date': 'Thu, 19 Nov 2020 14:26:23 GMT', 'Content-Type': 'application/json', 'Content-Length': '306', 'Connection': 'keep-alive', 'Server': 'gunicorn/19.9.0', 'Access-Control-Allow-Origin': '*', 'Access-Control-Allow-Credentials': 'true'}

# options:允许客户端查看服务器的性能

>>> r = requests.options('http://httpbin.org/get')

>>> print("options:", r.text)

options:

>>> print(r.headers)

{'Date': 'Thu, 19 Nov 2020 14:26:24 GMT', 'Content-Type': 'text/html; charset=utf-8', 'Content-Length': '0', 'Connection': 'keep-alive', 'Server': 'gunicorn/19.9.0', 'Allow': 'OPTIONS, HEAD, GET', 'Access-Control-Allow-Origin': '*', 'Access-Control-Allow-Credentials': 'true', 'Access-Control-Allow-Methods': 'GET, POST, PUT, DELETE, PATCH, OPTIONS', 'Access-Control-Max-Age': '3600'}4. 高级用法

1)获取 json 格式的响应数据

1 r = requests.get('https://api.github.com/events')

2 print(r.json()) # (将json数据转成python对象)本例返回一个列表,里面是一个字典元素

3 print(type(r.json())) # List2)获取原始的 socket 响应数据

>>> resp = requests.get("https://api.github.com/events", stream=True)

>>> print(type(resp.raw))

<class 'urllib3.response.HTTPResponse'>

>>> print(resp.raw)

<urllib3.response.HTTPResponse object at 0x000001E3F2A0C2B0>

>>> print(resp.raw.read()) # 获取流格式的响应数据

b'\x1f\x8b\x08\x00\x00\x00\x00\ ......将数据流保存到文件中:

>>> resp = requests.get("https://api.github.com/events", stream=True)

>>> with open("e:\\file.txt", "wb") as f:

... for chunk in resp.iter_content(1000):

... f.write(chunk)

...

2748

2853

4761

4835

4691

4066

5545

7525

4489

2732

3259

2115

>>> with open("e:\\file.txt") as f:

... print(f.read(50))

...

[{"id":"14250730635","type":"PushEvent","actor":{"...]3)设置请求头

1 >>> url = "http://api.github.com/some/endpoint"

2 >>> headers = {"user-agent": "my-app/0.0.1"} # 增加浏览器及版本信息

3 >>> r = requests.get(url, headers=headers)4)上传文件

方式 1:

import requests

url = 'http://httpbin.org/post'

files = {'file': open('e:\\test.xlsx', 'rb')}

r = requests.post(url, files=files)

print(r.text)方式 2:显式设置文件名、文件类型和请求头

import requests

url = 'http://httpbin.org/post'

files = {'file': ('report.xls', open('e:\\test.xlsx', 'rb'), 'application/vnd.ms-excel', {'Expires': '0'})}

r = requests.post(url, files=files)

print(r.text)建议用二进制模式(binary mode)打开文件。这是因为 requests 可能会试图为你提供 Content-Length header,在它这样做的时候,这个字段值会被设为文件的字节数(bytes)。如果用文本模式(text mode)打开文件,就可能会发生错误。

5)状态码

import requests

r = requests.get('http://httpbin.org/get')

print(r.status_code) # 200

print(r.status_code == requests.codes.ok) # 状态码判断:True

# 非200时抛出异常代码

print(r.raise_for_status()) # None

r = requests.get('https://www.cnblogs.com/dinex.indd')

print(r.raise_for_status()) # 抛异常:...404 Client Error: Not Found...6)获取响应头信息

1 import requests

2

3 r = requests.get('https://api.github.com/events')

4 print(r.headers)

5 print(r.headers['Content-Type'])

6 print(r.headers.get('content-type'))7)获取/发送 Cookie

获取 Cookie:

import requests

url = 'https://www.baidu.com'

r = requests.get(url)

print(r.cookies) # 存储在字典里 # <RequestsCookieJar[<Cookie BDORZ=27315 for .baidu.com/>]>

for k, v in r.cookies.items():

print(k, v) # BDORZ 27315发送 Cookie:

import requests

url = 'http://httpbin.org/cookies'

cookies = dict(cookies_are='working')

r = requests.get(url, cookies=cookies)

print(r.text) # {"cookies":{"cookies_are":"working"}}设定跨多个路径的 Cookie:

import requests

jar = requests.cookies.RequestsCookieJar()

jar.set('tasty_cookie', 'yum', domain='httpbin.org', path='/cookies')

jar.set('gross_cookie', 'blech', domain='httpbin.org', path='/elsewhere')

url = 'http://httpbin.org/cookies'

r = requests.get(url, cookies=jar)

print(r.text) # {"cookies":{"tasty_cookie":"yum"}}8)请求超时

1 import requests

2

3 requests.get('http://github.com', timeout=0.001) # 抛超时的异常9)获取重定向响应数据

1 import requests

2

3 r = requests.head('http://github.com', allow_redirects=True)

4 print(r.url) # 最终访问的url:'https://github.com/'

5 print(r.history[0].url) # 跳转前的url:http://github.com/

6 print(r.history) # 历史响应对象的列表 # [<Response [301]>]禁止重定向:

1 import requests

2

3 r = requests.get('http://github.com', allow_redirects=False)

4 print(r.status_code) # 301

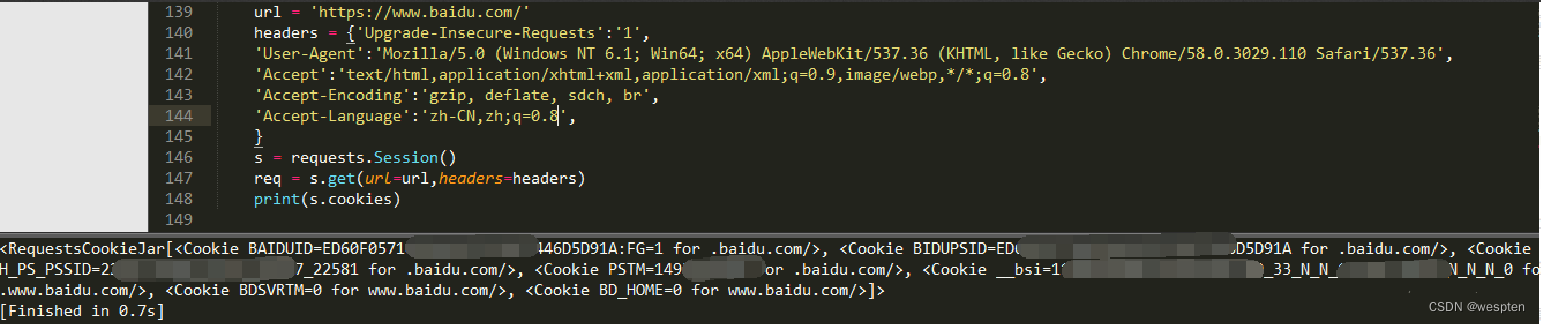

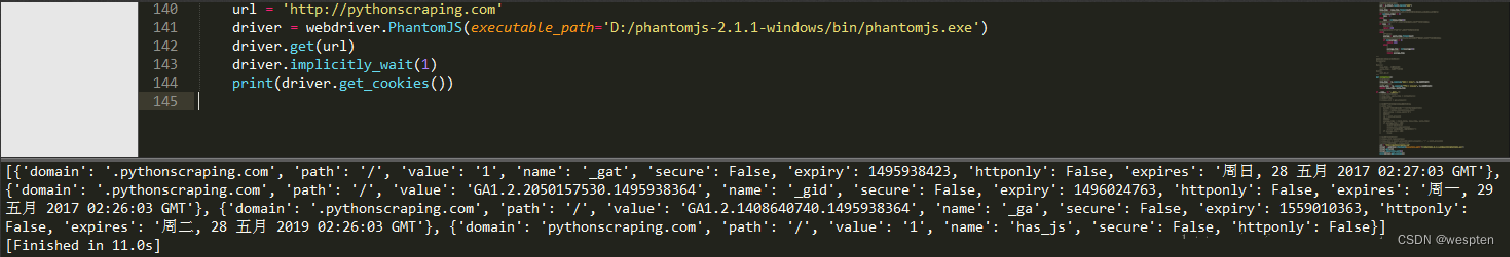

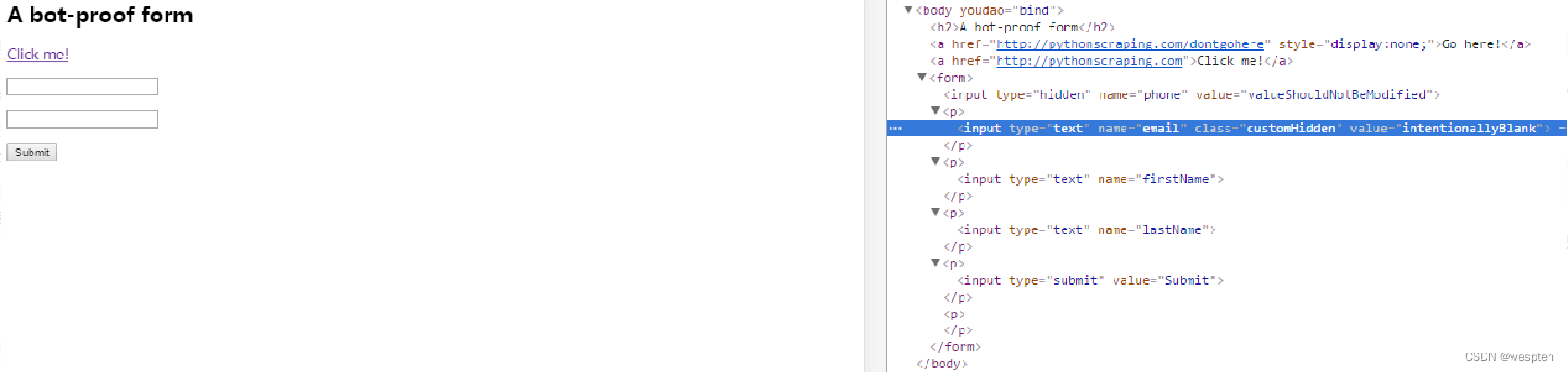

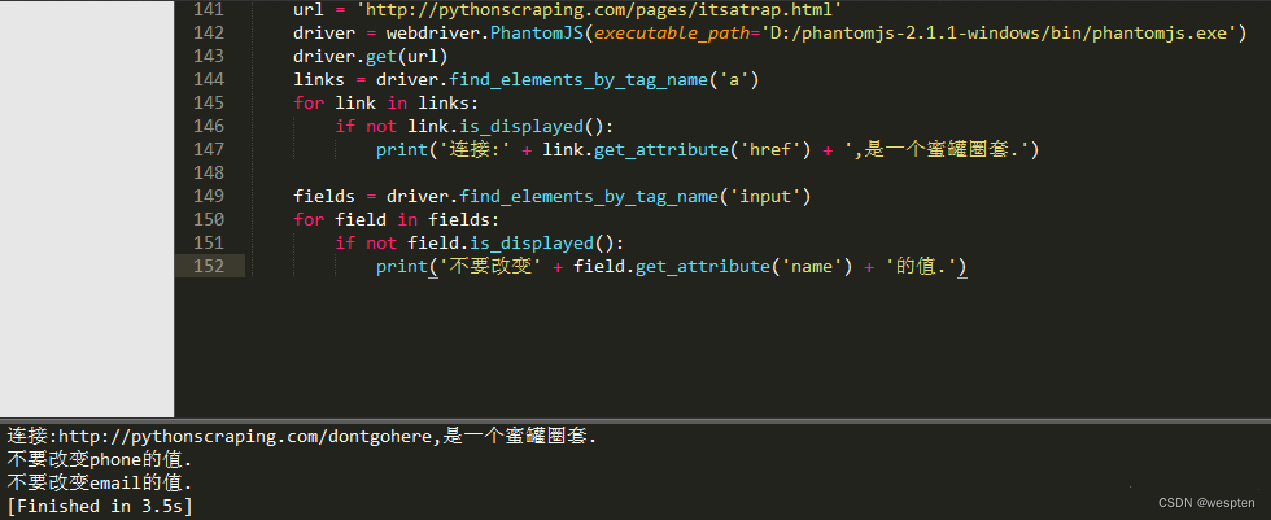

5 print(r.history) # []10)Session

会话对象让你能够跨请求保持某些参数,它也会在同一个 Session 实例发出的所有请求之间保持 Cookie。

import requests

s = requests.Session()

# 跨请求主体去请求

s.get('http://httpbin.org/cookies/set/sessioncookie/123456789')

# 从上一个请求中获得的cookie信息,会自动的发给下一次请求的网址。

r = s.get("http://httpbin.org/cookies")

print(r.text) # {"cookies": {"sessioncookie": "123456789"}}在会话中添加默认请求头配置:

import requests

s = requests.Session()

s.auth = ('username', 'passwd')

# 添加的一个默认header信息

s.headers.update({'x-test': 'true'})

# both 'x-test' and 'x-test2' are sent

r=s.get('http://httpbin.org/headers', headers={'x-test2': 'true'})

print(r.text)

# both 'x-test' and 'x-test3' are sent

r=s.get('http://httpbin.org/headers', headers={'x-test3': 'true'})

print(r.text)5. requests库使用

python2.7、python3.6下:

#coding:utf-8

#python网络爬虫库requests库应用全解

import requests

import json

print(u'================入门================')

r = requests.get('http://blog.csdn.net/luanpeng825485697/') #返回Response对象

# print(r.status_code) # 获取整型返回状态

# print(r.headers) # 获取头部信息,#以字典对象存储服务器响应头,但是这个字典比较特殊,字典键不区分大小写,若键不存在则返回None

# print(r.encoding) #获取编码类型

# print(r.url) #获取响应网址

# print(r.history) #获取访问历史

# print(r.reason) #获取文本描述,"Not Found" or "OK".

# print(r.cookies) #获取cookie

# print(r.raw) #返回原始响应体,也就是 urllib 的 response 对象,使用 r.raw.read() 读取

# print(r.content) #字节方式的响应体,会自动为你解码 gzip 和 deflate 压缩

# print(r.text) #字符串方式的响应体,会自动根据响应头部的字符编码进行解码

# print(r.links) #解析响应的头部连接

# print(r.is_redirect) #是否是重定向响应

#*特殊方法*#

# r.json() #如果返回的是json字符串将翻译为python对象

# r.raise_for_status() #功能:如果失败请求(非200响应)抛出异常

# r.close() #关闭连接

print(u'================基本请求================')

r = requests.post("http://httpbin.org/post")

r = requests.put("http://httpbin.org/put")

r = requests.delete("http://httpbin.org/delete")

r = requests.head("http://httpbin.org/get")

r = requests.options("http://httpbin.org/get")

print(u'================基本GET请求================')

payload = {'key1': 'value1', 'key2': 'value2'} #字典数据

headers = {'content-type': 'application/json'} #header数据

r = requests.get("http://httpbin.org/get", params=payload, headers=headers) #payload可以省略,会在网址中添加

print(r.url)

print(u'================基本POST请求================')

url = 'http://httpbin.org/post'

payload = {'some': 'data'}

r = requests.post(url, data=payload) #上传字典数据

r = requests.post(url, json=json.dumps(payload)) #上传json数据

print(r.text)

url = 'http://httpbin.org/post'

myfiles = {'file': open('test.txt', 'rb')} #获取文件对象

r = requests.post(url, files=myfiles) #上传文件

print(r.text)

#with open('test.txt') as f: #流式上传

# requests.post('http://some.url/streamed', data=f)

print('=============携带认证信息的请求==========')

from requests.auth import HTTPBasicAuth

response = requests.get(host,auth=HTTPBasicAuth('intellif', 'introcks'))

print(u'================Cookies================')

url = 'http://httpbin.org/cookies'

r = requests.get(url) #响应中会包含cookie

print(r.cookies)

url = 'http://httpbin.org/cookies'

cookies = dict(cookies_are='working') #自定义cookie变量

r = requests.get(url, cookies=cookies) #请求时附带cookie

print(r.text)

print(u'================超时配置================')

requests.get('http://github.com', timeout=1) #1秒没有响应就报错

print(u'================会话对象(持久连接)================')

s = requests.Session()

s.get('http://httpbin.org/cookies/set/sessioncookie/123456789') #get方式设置cookie

r = s.get("http://httpbin.org/cookies") #获取cookie

print(r.text)

headers = {'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

'Accept-Encoding': 'gzip, deflate, compress',

'Accept-Language': 'en-us;q=0.5,en;q=0.3',

'Cache-Control': 'max-age=0',

'Connection': 'keep-alive',

'User-Agent': 'Mozilla/5.0 (X11; Ubuntu; Linux x86_64; rv:22.0) Gecko/20100101 Firefox/22.0'}

s = requests.Session()

s.headers.update(headers) #更新header

r = s.get('http://httpbin.org/headers', headers={'x-test': 'true'}) #get函数中添加的headers会覆盖原有同名,添加不同名的,去除值为None的

print(r.text)

print(u'================SSL证书验证================')

r = requests.get('https://github.com', verify=True)

print(r.text)

r = requests.get('https://kyfw.12306.cn/otn/', verify=False) #把 verify 设置为 False即可跳过证书验证

print(r.text)

print(u'================设置代理服务器================')

#第一种方法

proxies = {

"https": "http://121.193.143.249:80"

}

r = requests.post("http://httpbin.org/post", proxies=proxies)

print(r.text)

#第2中方法

s = requests.session()

s.proxies = {'http': '121.193.143.249:80'}

s.get('http://httpbin.org/ip')

6. 应用案例

1)requests模块获取数据的方式

发起网络请求主要使用的是requests模块中的get()函数和post()函数。get()函数的功能是向服务器发起获取网页的请求,获取到的响应对象可以被缓存到浏览器中,该函数只获取资源,不会在服务器中执行修改操作。而post()函数的功能是向服务器传送数据,服务器会根据这些数据作出响应,所以post()函数常用来模拟用户登录。

用爬虫获取数据最常见的操作是发起获取网页的请求,因此这里先介绍利用get()函数获取数据的3种方式。

(1)获取静态网页的源代码

代码文件:获取静态网页的源代码.py

静态网页是指设计好后其内容就不再变动的网页,所有用户访问该网页时看到的页面效果都一样。对于这种页面可以直接请求源代码,然后对源代码进行数据解析,就能获取想要的数据。

演示代码如下:

1 import requests

2 response = requests.get(url='https://www.baidu.com')

3 print(response.text)第1行代码导入requests模块。

第2行代码使用requests模块中的get()函数对由参数url指定的网页地址发起请求,服务器会根据请求的地址返回一个响应对象。响应对象分为响应头和响应体两部分,响应头包含响应的状态码、日期、内容类型和编码格式等信息,响应体则包含字符串形式的网页源代码。这里将返回的响应对象存储在变量response中。

第3行代码使用响应对象的text属性提取响应对象中的网页源代码字符串,然后使用print()函数进行输出,以便确定网页源代码是否获取成功。

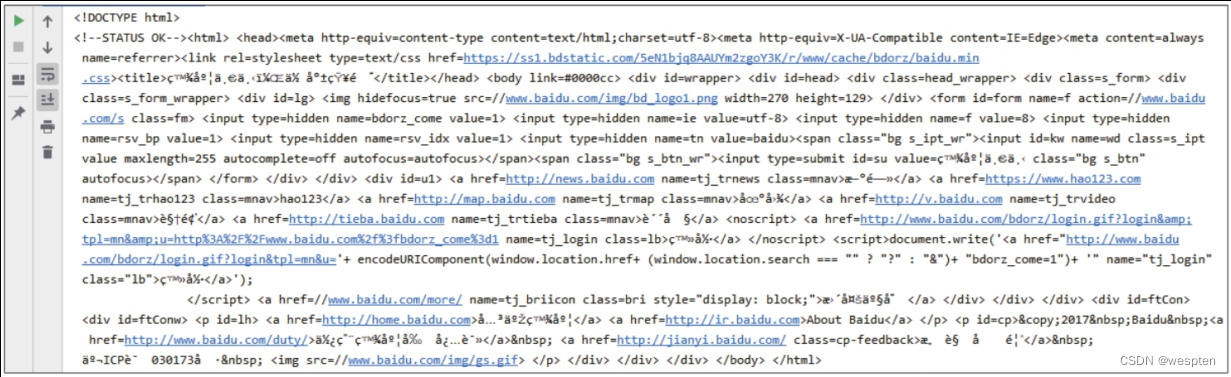

在PyCharm中运行代码的结果如下图所示:

(2)获取动态加载的数据

代码文件:获取动态加载的数据.py

动态网页是指服务器返回一个网页模板,其数据通过Ajax或其他方式填充到模板的指定位置,我们想要的数据一般都在服务器返回的JSON格式数据包中。

提示:

JSON(JavaScript Object Notation)是一种与开发语言无关的、轻量级的数据存储格式,起初来源于JavaScript,后来使用范围越来越广。如今几乎每门编程语言都能处理JSON格式数据。

那么如何判断想要的数据是静态的还是动态加载的呢?一般来说,如果随着浏览器的滚动条的下拉,网页中会有更多的数据加载出来,这种数据就是动态加载的。我们还可以利用开发者工具定位目标数据所在的数据包,再根据数据包的类型判断数据是否是动态加载的。

下面通过一个实例来讲解具体的方法。

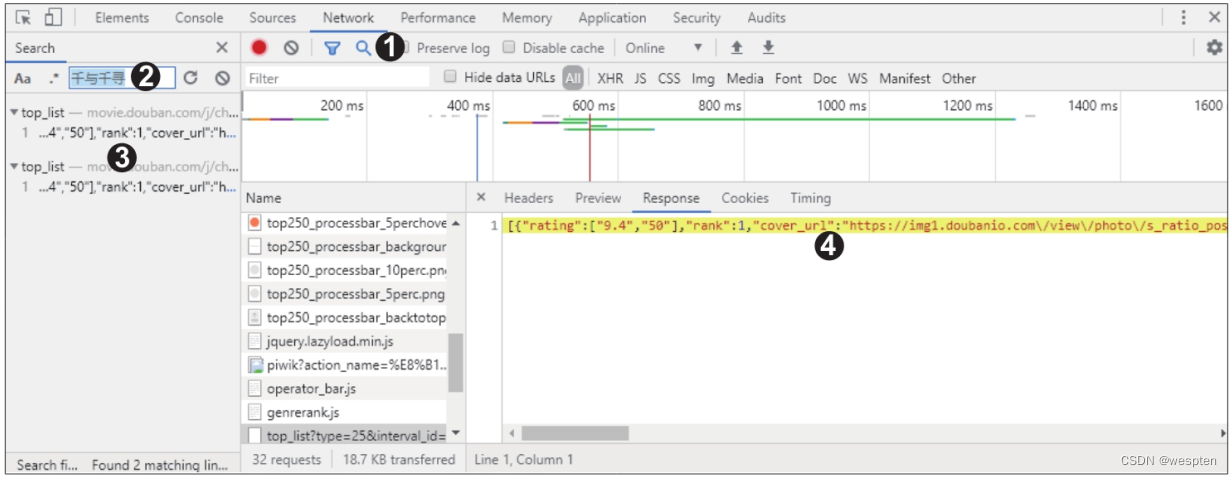

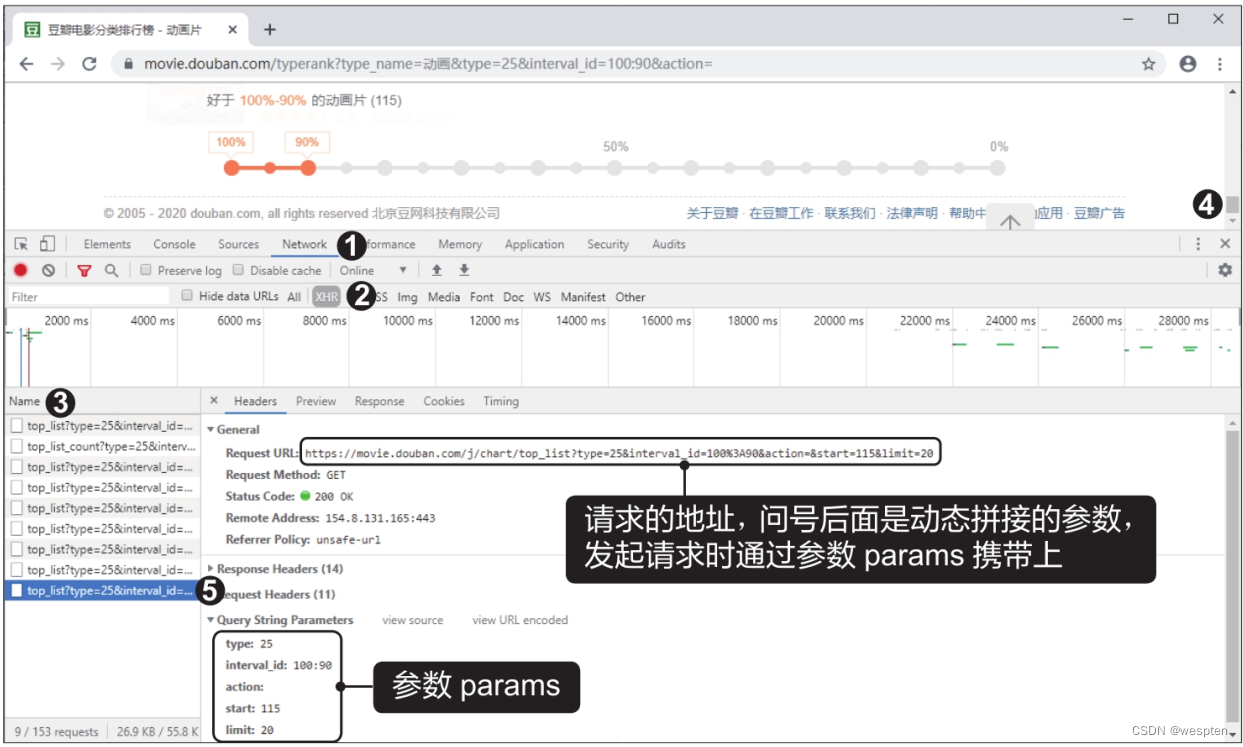

在谷歌浏览器中打开豆瓣电影排行榜,网址为https://movie.douban.com/chart,在页面右侧的“分类排行榜”栏目中单击“动画”分类,打开“豆瓣电影分类排行榜-动画片”页面,按【F12】键打开开发者工具,切换到“Network”选项卡。

然后单击“All”按钮,按【F5】键刷新页面,在下方左侧的“Name”窗格中找到主页面的数据包并单击(通常第一个数据包就是主页面的数据包),在“Name”窗格的右侧切换至“Response”选项卡,并在网页源代码的任意处单击,按快捷键【Ctrl+F】调出局部搜索框,输入要爬取的数据包含的关键词,如“千与千寻”,按【Enter】键后,如果该关键词存在于静态网页的源代码中,那么就能在源代码中定位到该关键词,这里可以看到搜索框的末端显示搜索结果为“0 of 0”。

如下图所示,说明源代码中没有该关键词,数据是动态加载的:

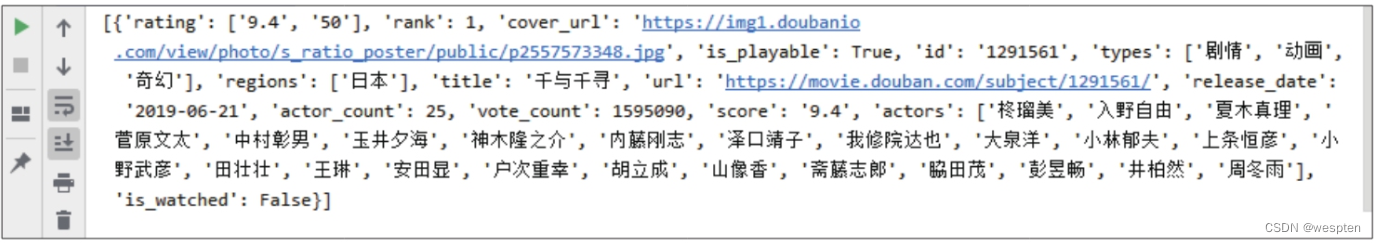

此时单击开发者工具界面上方的“Search”按钮(放大镜图标),会在左侧出现一个搜索框,在搜索框中输入关键词“千与千寻”后按【Enter】键,在搜索结果中单击数据包,即可在“Response”选项卡中定位到包含该关键词的数据包,如下图所示。

随后就可以编写代码来爬取动态加载的网页数据了。

演示代码如下:

1 import requests

2 headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36'}

3 url = 'https://movie.douban.com/j/chart/top_list'

4 params = {'type': '25', 'interval_id': '100:90', 'action': '', 'start': '0', 'limit': '1'}

5 response = requests.get(url=url, headers=headers, params=params)

6 print(response.json())第2行代码中的headers是get()函数的一个参数,{}里是浏览器的User-Agent信息。

第3行代码中的url地址及第4行代码中的参数params的获取方式。

第5行代码使用get()函数对动态加载的数据包的url地址发起请求并获取响应对象,第6行代码用json()函数获取响应对象的JSON格式数据后进行输出。

在PyCharm中运行代码的结果如下图所示:

(3)获取图片

代码文件:获取图片.py

前面获取网页源代码时,先用get()函数获取响应对象,再用响应对象的text属性提取网页源代码。如果想要获取图片,也是先用get()函数获取响应对象,但随后不能使用text属性来提取,因为网页源代码是文本,而图片是二进制文件,如果用text属性来提取会得到乱码,此时应该使用content属性来提取图片的二进制字节码。

演示代码如下:

1 import requests

2 url = 'https://timgsa.baidu.com/timg?image&quality=80&size=b9999_10000&sec=1587292481371&di=a47137f669670075ec1049a5738eb657&imgtype=0&src=http%3A%2F%2Fbbs.jooyoo.net%2Fattachment%2FMon_0905%2F24_65548_2835f8eaa933ff6.jpg'

3 response = requests.get(url=url)

4 content = response.content

5 with open('图片.jpg', 'wb') as fp:

6 fp.write(content)第2行代码中的url为图片的地址。第3行代码使用get()函数获取响应对象。第4行代码使用content属性提取图片的二进制字节码。第5行和第6行代码将提取到的二进制字节码写入文件,如果文件打开后可以正常显示图片内容,则代表爬取成功。

第5行代码中,open()函数用于指定图片的保存路径和文件名,这里使用相对路径将图片保存在当前代码文件所在的文件夹下,“图片.jpg”为图片的保存名称和保存格式。

运行代码后,在代码文件所在的文件夹下可看到爬取的图片,打开该图片,效果如下图所示,说明爬取成功。

2)get()函数使用方式

get()函数获取数据时,需要根据不同的需求设置其参数,下面就来详细介绍get()函数的一些常用参数。

(1)headers

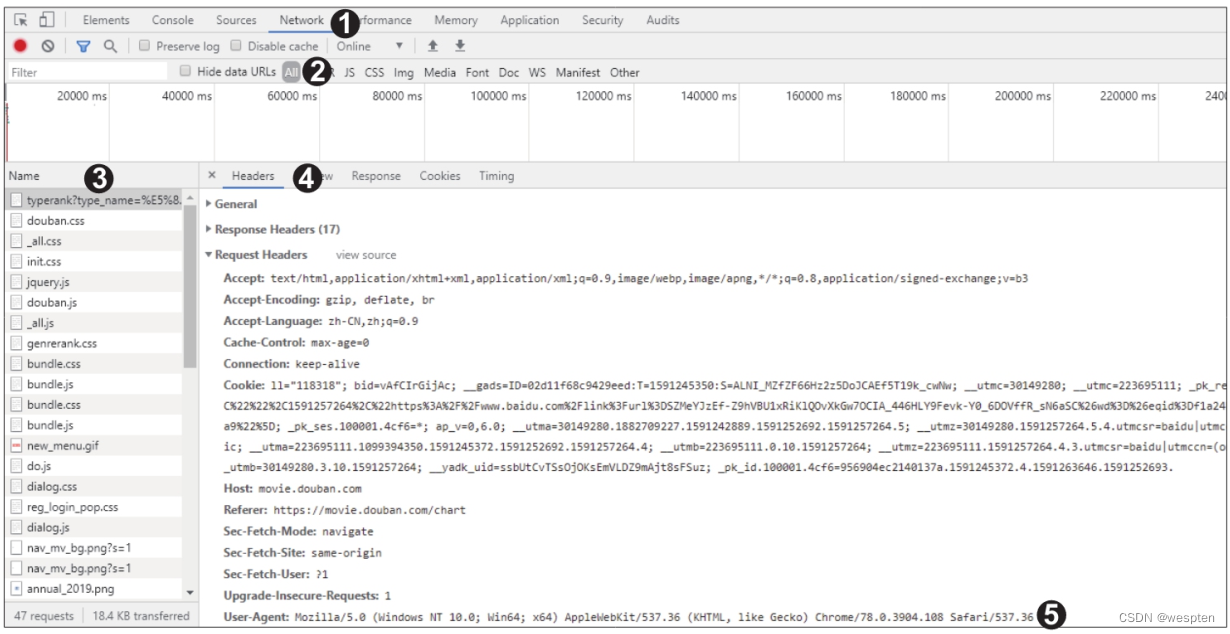

参数headers用于设置请求包中的请求头信息。很多网站服务器为了防止他人爬取数据,会对发起请求的一方进行身份验证,主要手段就是看请求包的请求头中的User-Agent信息,该信息描述了请求方的身份。

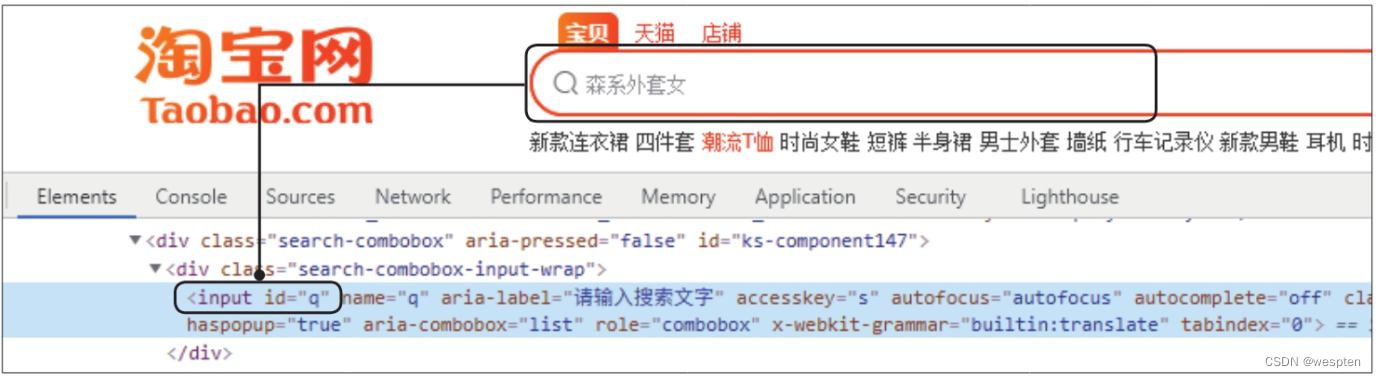

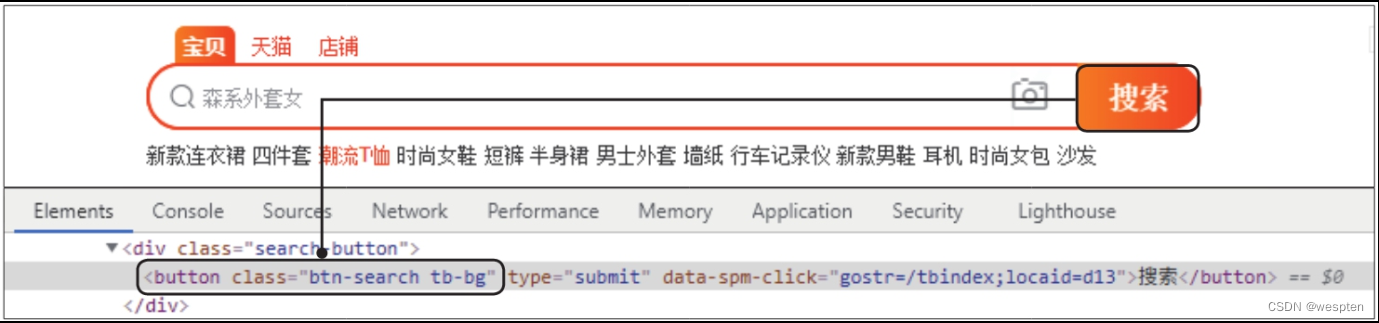

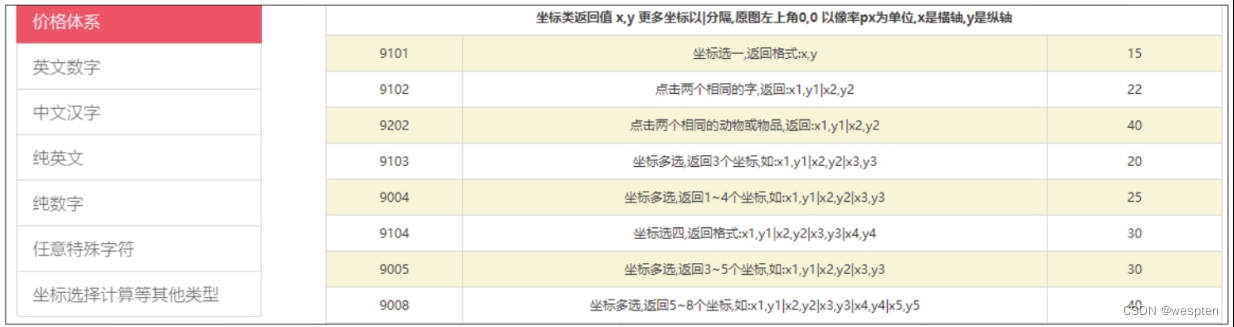

我们可以利用开发者工具查看请求头信息。打开开发者工具后切换至“Network”选项卡,然后单击“All”按钮,刷新页面后,在“Name”窗格中会显示加载的数据包,单击主页面的数据包,一般为第一个,切换至“Headers”选项卡,在“Request Headers”下有一个名为“User-Agent”的参数,如下图所示,服务器就是通过它判断请求方的身份的。

服务器对User-Agent信息进行识别后,如果认为请求不是由浏览器发起的,就不会返回正确的页面源代码。因此,爬虫为了将自己模拟成浏览器,就需要在get()函数发起请求时携带上参数headers,并为该参数设置合适的User-Agent值。

演示代码如下:

1 headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36'} # 浏览器的身份验证信息

2 response = requests.get(url='https://www.sogou.com/web', headers=headers)不同浏览器的User-Agent值不同,查看的方法也不同,有需要的读者可以利用搜索引擎查找具体的方法。

(2)params

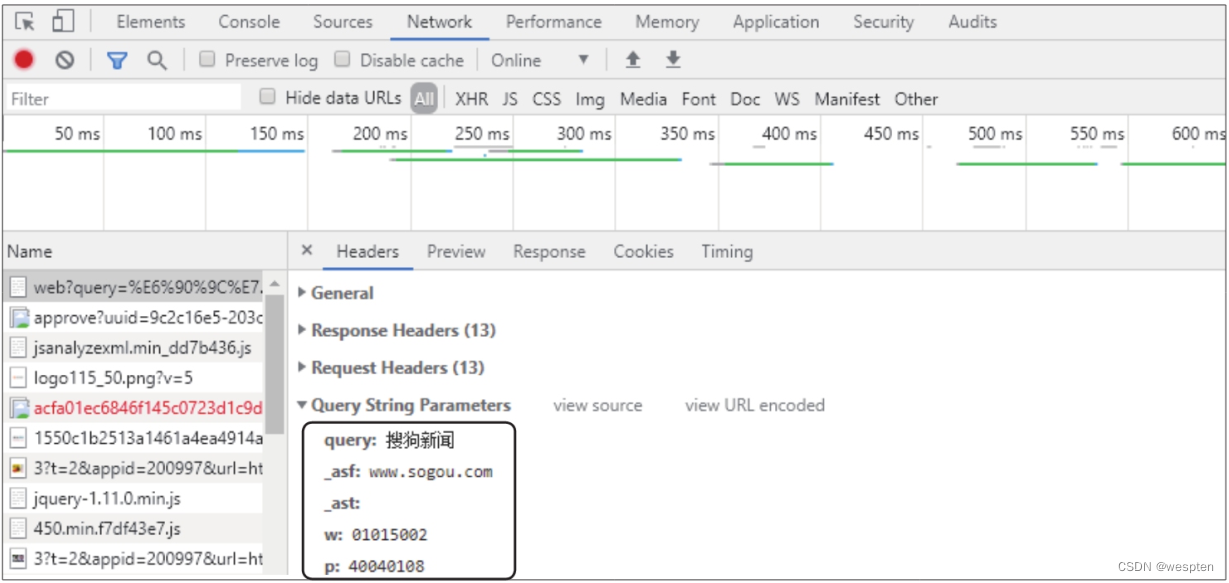

参数params用于在发送请求时携带动态参数,例如,搜索引擎会将用户在搜索框中输入的关键词作为参数发送给服务器,供服务器获取相关网页。

以搜狗搜索引擎为例,在搜索框中输入“搜狗新闻”,打开开发者工具,选中数据包后,在“Headers”选项卡下可以看到在“Query String Parameters”下有多个参数,其中就有我们输入的关键词“搜狗新闻”,如下图所示。

为了模拟这种携带动态参数的请求,就需要为get()函数设置参数params。

演示代码如下:

1 params = {'query': '搜狗新闻'}

2 response = requests.get(url='https://www.sogou.com/web', params=params)每一个动态参数都有其意义,服务器会根据动态参数返回不同的内容。第1行代码中不一定要指定所有动态参数,只需指定需要自定义的动态参数。如果运行代码后没有获取到正确的网页源代码,再尝试将“Query String Parameters”下所有的动态参数都携带上。

(3)timeout

参数timeout用于设置请求超时的时间。由于网络原因或其他原因,并不是每次请求都会被服务器接收到,如果一段时间内服务器还未返回响应结果,requests模块默认会重复发起同一个请求,爬虫程序可能会挂起很长时间来等待响应结果的返回。适当设置参数timeout的值(单位为秒),可以在请求超时时抛出异常,结束程序的运行。

演示代码如下:

1 response = requests.get(url='https://www.sogou.com/web', timeout=1.0)(4)proxies

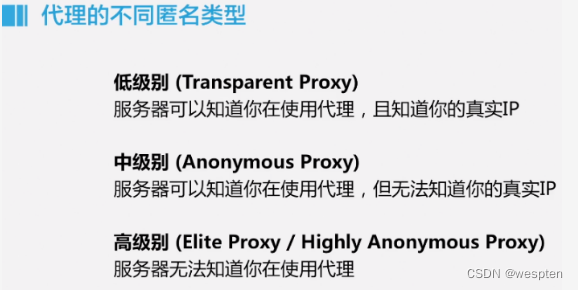

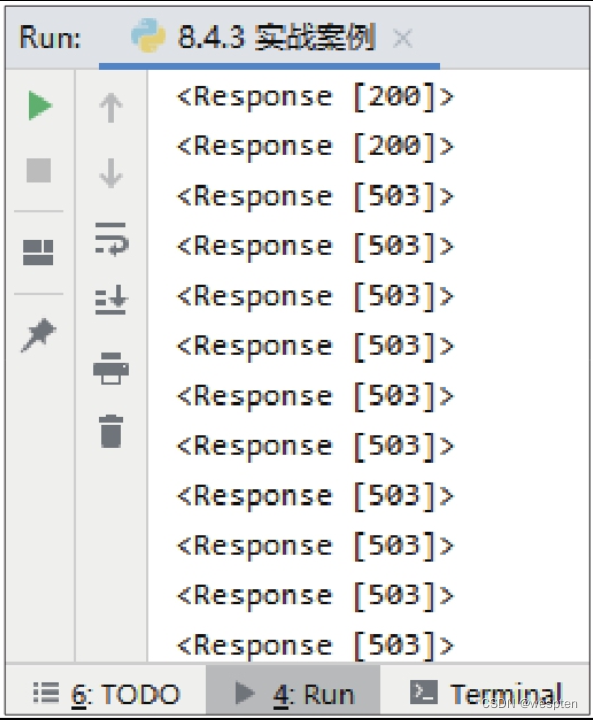

参数proxies用于设置代理服务器。网站服务器在收到请求的同时还能获得请求方的IP地址,当网站服务器检测到短时间内同一IP地址发起了大量请求,就会认为该IP地址的用户是爬虫程序,并对该IP地址进行访问限制。为了规避这种“反爬”手段,可以使用代理服务器代替实际的IP地址来发起请求。

演示代码如下:

1 proxies = {'https': '101.123.102.12:7999'} # {http或https协议: 代理服务器IP地址和端口}

2 response = requests.get(url='https://www.sogou.com/web', proxies=proxies)3)分析豆瓣短评网页

import requests

url = ' https://book.douban.com/subject/27147922/?icn=index-editionrecommend'

r = requests.get(url, timeout=20) # 设置超时时间为20秒

# #print(r.text) # 打印返回文本

# 抛出异常

print(r.raise_for_status()) # None4)爬取豆瓣电影动画排行榜

代码文件:案例:爬取豆瓣电影动画排行榜.py

通过前面的学习,相信大家对如何使用requests模块发起网络请求并获取网页源代码有了基本的了解,下面通过爬取豆瓣电影排行榜的动画分类的数据来巩固所学的知识。

首先需要判断数据是静态的还是动态加载的。在谷歌浏览器中打开豆瓣电影排行榜,网址为https://movie.douban.com/chart,在页面右侧的“分类排行榜”栏目中单击“动画”分类,打开“豆瓣电影分类排行榜-动画片”页面,向下拖动滚动条,会看到页面中加载出更多的动画片数据,由此可以判断数据是动态加载的。

爬虫程序需要携带动态参数发起请求,服务器才会返回我们需要的数据。

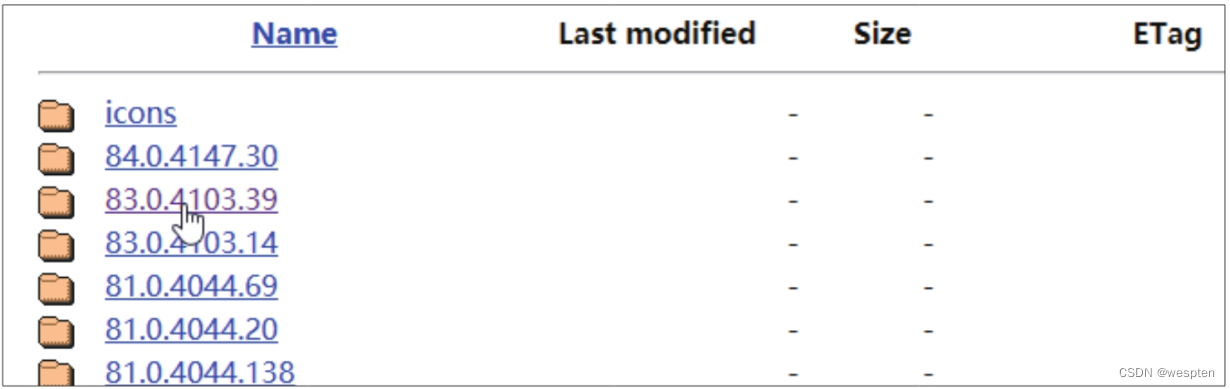

接着来获取参数。按【F12】键打开开发者工具,切换至“Network”选项卡,再单击“XHR”按钮,然后按【F5】键刷新页面,可在“Name”窗格中看到动态请求的多个数据包,将页面右侧的滚动条拉到底部,加载所有的动画片数据,在“Name”窗格中单击最后一个数据包,如下图所示。

此时即可在“Headers”选项卡下的“General”和“Query String Parameters”中看到数据包中的参数设置。这些参数的名称和值可以直接复制下来,然后在爬虫代码中使用。

上图中的请求地址是浏览器将要携带的动态参数拼接到网址后面得到的,我们在编写爬虫代码时只需要用get()函数对问号前面的网址发起请求,问号后面的动态参数则通过get()函数的参数params来携带。还可以看到动态参数中的start为115,limit为20,意思是从115条数据开始获取20条数据,可以得出排行榜数据总数为135条,因此,爬虫代码携带的动态参数中start应为0,limit应为135。

完成网页的分析和相关参数的查看后,下面开始编写爬虫代码。

步骤1:导入requests模块和json模块,定义请求的地址、需要携带的动态参数和身份验证信息。

演示代码如下:

1 import requests

2 import json # 用于处理JSON格式数据的模块

3 url = 'https://movie.douban.com/j/chart/top_list' # 请求的地址

4 params = {'type': '25', 'interval_id': '100:90', 'action': '', 'start': '0', 'limit': '135'} # 需要携带的动态参数

5 headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36'} # 模拟浏览器的身份验证信息步骤2:使用get()函数发起请求,获取响应对象;再使用json()函数提取响应对象中的JSON格式数据。

演示代码如下:

1 response = requests.get(url=url, params=params, headers=headers)

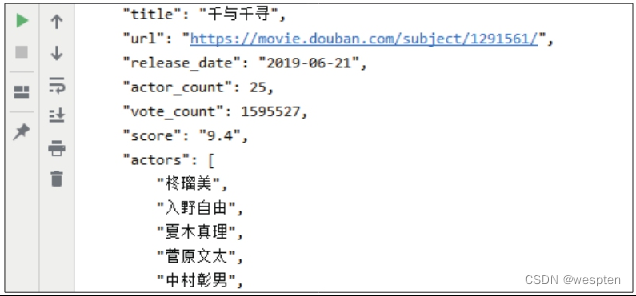

2 content = response.json() # 提取JSON格式数据步骤3:将content打印出来,可以得到一个含有大量字典的列表,要获取字典中的动画片的片名和评分,就需要将JSON格式数据打印出来,以便确定这两种数据在字典结构中的位置。

演示代码如下:

1 for i in content:

2 print(json.dumps(i, indent=4, ensure_ascii=False, separators=(', ', ': '))) # ensure_ascii设置将数据编码后显示文本内容,spearators设置键之间、键和值之间的分隔符,indent设置缩进量

3 break # 只需打印第1条JSON格式数据用于查看,因此主动结束循环代码运行结果如下图所示:

从运行结果可以看出,要获取动画片的片名和评分,需要分别提取title和score这两个键(key)对应的值(value)。

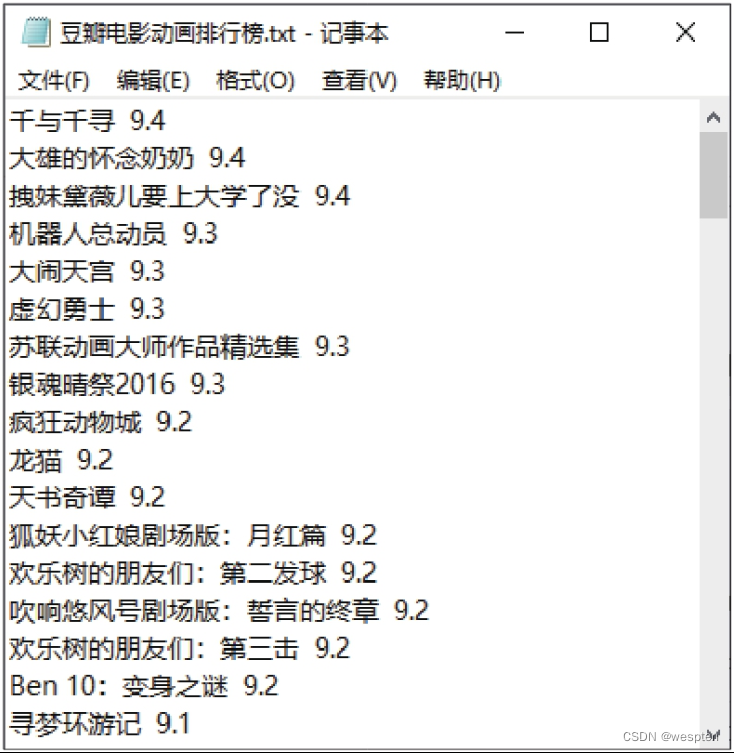

步骤4:利用for语句遍历JSON格式数据,提取title和score这两个键对应的值并写入文本文件中。

演示代码如下:

1 with open('豆瓣电影动画排行榜.txt', 'w', encoding='utf-8') as fp: # 将JSON格式数据写入文本文件中,方便展示效果

2 for i in content:

3 title = i['title'] # 片名

4 score = i['score'] # 评分

5 fp.write(title + ' ' + score + '\n') # '\n'表示换行最后运行整个爬虫代码,在代码文件所在的文件夹下会生成一个名为“豆瓣电影动画排行榜.txt”的文件,打开该文件,可看到爬取的数据,如下图所示。

2、urllib模块

python3.4以后中,将urllib2、urlparse、robotparser并入了urllib模块,并且修改了urllib模块,其中包含了5个子模块,每个子模块中的常用方法如下:

python3中的库 python2中的库

urllib.error: ContentTooShortError;

URLError;HTTPError

urllib.parse: urlparse;

_splitparams;

urlsplit;

urlunparse;

urlunsplit;

urljoin;

urldefrag;

unquote_to_bytes;

unquote;

parse_qs;

parse_qsl;

unquote_plus;

quote;

quote_plus;

quote_from_bytes;

urlencode;

to_bytes;

unwrap;

splittype;

splithost;

splituser;

splitpasswd;

splitport等;

urllib.request: urlopen;

install_opener;

urlretrieve;

urlcleanup;

request_host;

build_opener;

_parse_proxy;

ProxyHandler;

HTTPCookieProcessor;

parse_keqv_list;

parse_http_list;

_safe_gethostbyname;

ftperrors;

noheaders;

getproxies_environment;

proxy_bypass_environment;

_proxy_bypass_macosx_sysconf;

Request等

urllib.response: addbase;

addclosehook;

addinfo;

addinfourl;

urllib.robotparser: RobotFileParser

- 在Pytho2.x中使用import urllib2——-对应的,在Python3.x中会使用import urllib.request,urllib.error。

- 在Pytho2.x中使用import urllib——-对应的,在Python3.x中会使用import urllib.request,urllib.error,urllib.parse。

- 在Pytho2.x中使用import urlparse——-对应的,在Python3.x中会使用import urllib.parse。

- 在Pytho2.x中使用import urlopen——-对应的,在Python3.x中会使用import urllib.request.urlopen。

- 在Pytho2.x中使用import urlencode——-对应的,在Python3.x中会使用import urllib.parse.urlencode。

- 在Pytho2.x中使用import urllib.quote——-对应的,在Python3.x中会使用import urllib.request.quote。

- 在Pytho2.x中使用cookielib.CookieJar——-对应的,在Python3.x中会使用http.CookieJar。

- 在Pytho2.x中使用urllib2.Request——-对应的,在Python3.x中会使用urllib.request.Request。

python2.7环境,以下的所有程序需要导入以下库:

#coding:utf-8

import urllib

import urllib2

import cookielib

python3.6环境下,以下的所有程序需要导入以下库

#coding:utf-8

import urllib

import http.cookiejar as cookielib

1. urlretrieve()

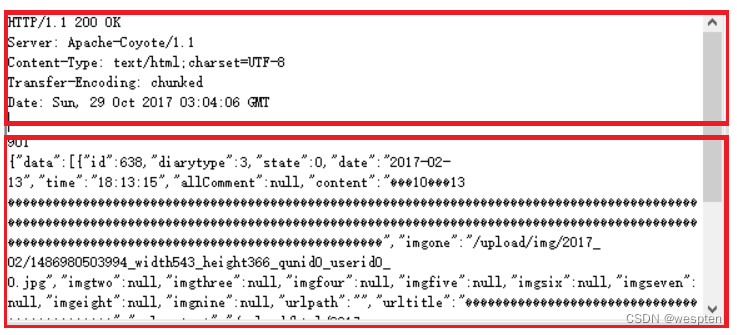

主要包含远程文件的下载,远程文件存储到本地,远程文件的读取,以及http响应的MIME头信息。

所谓的MIME头就是http协议中,数据传输都是以字节流在网线中传递,在一个文件或数据的传递起始部分都有个MIME头,用来描述本次传递的某些属性特点,如图中上面红色框中的内容。下面的红色框为传输的文件内容。

urlretrieve(url, filename=None, reporthook=None, data=None)

-

filename:指定了保存本地路径(如果参数未指定,urllib 会生成一个临时文件保存数据)。

-

reporthook:是一个回调函数,当连接上服务器、以及相应的数据块传输完毕时会触发该回调,我们可以利用这个回调函数来显示当前的下载进度。

-

data:指post导服务器的数据,该方法返回一个包含两个元素的(filename, headers)元组,filename 表示保存到本地的路径,header 表示服务器的响应头。

#远程文件

resphonse = urllib.request.urlopen("http://www.525heart.com/index/index/index.html") # urlopen(url,data,timeout)打开远程文件,返回的是类文件对象,可以使用readline等文件函数

htmlcode = resphonse.readline() #读取一行

htmlcode = resphonse.readlines() #读取所有行

htmlcode = resphonse.read() #读取字节流

print(resphonse.geturl()) #文件网址

print(resphonse.info()) #数据传输的MIME头文件

resphonse.close() #关闭

urllib.request.urlretrieve("http://www.525heart.com/index/index/index.html",'index.html') # 下载远程文件,参数为网址,可本地存储地址

示例 1:下载图片

使用 urlretrieve():

1 from urllib.request import urlretrieve

2

3 urlretrieve("http://pic1.win4000.com/pic/b/20/b42b4ca4c5_250_350.jpg", "e:\\1.jpg")使用 requests:

1 import requests

2

3 url = "http://pic1.win4000.com/pic/b/20/b42b4ca4c5_250_350.jpg"

4 r = requests.get(url)

5 with open("e:\\1.jpg", "wb") as fp:

6 fp.write(r.content)示例 2:下载文件并显示下载进度

import os

from urllib.request import urlretrieve

def cbk(a, b, c):

'''回调函数

@a:已经下载的数据块

@b:数据块的大小

@c:远程文件的大小

'''

per = 100*a*b/c

if per > 100:

per = 100

print('%.2f%%' % per)

url = 'http://www.python.org/ftp/python/2.7.5/Python-2.7.5.tar.bz2'

dir = os.path.abspath('.')

work_path = os.path.join(dir, 'Python-2.7.5.tar.bz2')

urlretrieve(url, work_path, cbk)执行效果:

2. urllib.parse.urlparse

urllib.parse.urlparse模块,网址字符串处理。

在python2中是urllib2.urlparse模块。

包含了将网址分解为6元组,将6元组分解为网址,获取指定网址上的链接所代表的绝对网址。

#urlparse()参数:网址、网络协议、是否使用片段,返回值:网络协议、服务器所在地、文件路径、可选参数、键值对、文档锚

prot_sch,net_loc,path,params,query,frag=urllib.parse.urlparse("http://www.525heart.com/index/index/index.html",None,None)

print(prot_sch,net_loc,path,params,query,frag)

#urlunparse()将6元组合并为网址字符串

urlpath=urllib.parse.urlunparse((prot_sch,net_loc,path,params,query,frag))

print(urlpath)

#urljoin()获取根域名,连接新网址

urlpath=urllib.parse.urljoin("http://www.525heart.com/index/index/index.html","../chanpin/detail.html")

print(urlpath)

3. urllib.request.Request

获取get方式请求响应流。

在python2中是urllib2.Request模块。

很多服务器或代理服务器会查看HTTP头,进而控制网络流量,实现负载均衡,限制不正常用户的访问。所以我们要学会设置HTTP头,来保证一些访问的实现。

HTTP头部分参数说明:

Upgrade-Insecure-Requests:参数为1。该指令用于让浏览器自动升级请求从http到https,用于大量包含http资源的http网页直接升级到https而不会报错。简洁的来讲,就相当于在http和https之间起的一个过渡作用。就是浏览器告诉服务器,自己支持这种操作,我能读懂你服务器发过来的上面这条信息,并且在以后发请求的时候不用http而用https;

User-Agent:有一些网站不喜欢被爬虫程序访问,所以会检测连接对象,如果是爬虫程序,也就是非人点击访问,它就会不让你继续访问,所以为了要让程序可以正常运行,我们需要设置一个浏览器的User-Agent;

Accept:浏览器可接受的MIME类型,可以根据实际情况进行设置;

Accept-Encoding:浏览器能够进行解码的数据编码方式,比如gzip。Servlet能够向支持gzip的浏览器返回经gzip编码的HTML页面。许多情形下这可以减少5到10倍的下载时间;

Accept-Language:浏览器所希望的语言种类,当服务器能够提供一种以上的语言版本时要用到;

Cookie:这是最重要的请求头信息之一。中文名称为“小型文本文件”或“小甜饼“,指某些网站为了辨别用户身份而储存在用户本地终端(Client Side)上的数据(通常经过加密)。定义于RFC2109。是网景公司的前雇员卢·蒙特利在1993年3月的发明。

url= "https://zhuanlan.zhihu.com/p/30488000"

postdata = urllib.parse.urlencode({"p":"30488000"}) # urlencode()字典序列化

headers={}

headers["User-Agent"]='Mozilla/4.0 (compatible;MSIE 5.5;Windows NT)' #标明浏览器身份,有些服务器或代理服务器会来判断。这里模仿的是IE浏览器

headers["Referer"]='http://www.zhihu.com/p' #标明文件来源,防止盗链用的

headers["Content-Type"]='text/html' #在谁用rest接口的服务器会检测这个值,来确定内容如何解析

request = urllib.request.Request(url,headers=headers) #headers控制请求,因为服务器会根据这个控制头决定如何响应。(resphonse.info()可以查看响应的头的信息)

resphonse = urllib.request.urlopen(request) #post请求消息

print(resphonse.read()) #读取响应数据

常见的User Agent

1)Android

Mozilla/5.0 (Linux; Android 4.1.1; Nexus 7 Build/JRO03D) AppleWebKit/535.19 (KHTML, like Gecko) Chrome/18.0.1025.166 Safari/535.19

Mozilla/5.0 (Linux; U; Android 4.0.4; en-gb; GT-I9300 Build/IMM76D) AppleWebKit/534.30 (KHTML, like Gecko) Version/4.0 Mobile Safari/534.30

Mozilla/5.0 (Linux; U; Android 2.2; en-gb; GT-P1000 Build/FROYO) AppleWebKit/533.1 (KHTML, like Gecko) Version/4.0 Mobile Safari/533.12)Firefox

Mozilla/5.0 (Windows NT 6.2; WOW64; rv:21.0) Gecko/20100101 Firefox/21.0

Mozilla/5.0 (Android; Mobile; rv:14.0) Gecko/14.0 Firefox/14.03)Google Chrome

Mozilla/5.0 (Windows NT 6.2; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/27.0.1453.94 Safari/537.36

Mozilla/5.0 (Linux; Android 4.0.4; Galaxy Nexus Build/IMM76B) AppleWebKit/535.19 (KHTML, like Gecko) Chrome/18.0.1025.133 Mobile Safari/535.194)iOS

Mozilla/5.0 (iPad; CPU OS 5_0 like Mac OS X) AppleWebKit/534.46 (KHTML, like Gecko) Version/5.1 Mobile/9A334 Safari/7534.48.3

Mozilla/5.0 (iPod; U; CPU like Mac OS X; en) AppleWebKit/420.1 (KHTML, like Gecko) Version/3.0 Mobile/3A101a Safari/419.3上面列举了Andriod、Firefox、Google Chrome、iOS的一些User Agent,直接copy就能用。

所谓get方式,就是将请求数据序列化以后添加到网址中,打开指定网址的过程。

request = urllib.request.Request('http://www.525heart.com/web/getdiaryurl?diaryid=612')

try:

resphonse = urllib.request.urlopen(request) # urlopen(url,data,timeout)打开远程文件,返回的是类文件对象,可以使用readline等文件函数

except urllib.error.URLError as e: #本机没联网、连接不到服务器、服务器不存在

print(e.reason)

except urllib.error.HTTPError as e: #响应状态,响应码

print(e.reason,e.code)

print(resphonse.read()) #读取响应数据

而对于我们想要爬取的网站,如何知道需要发送什么数据呢,需要用到浏览器的监听功能了。

这里以有道翻译为例,我们希望像服务器发送需要翻译的内容,获取翻译的结果,那么应该发送什么样的内容呢。

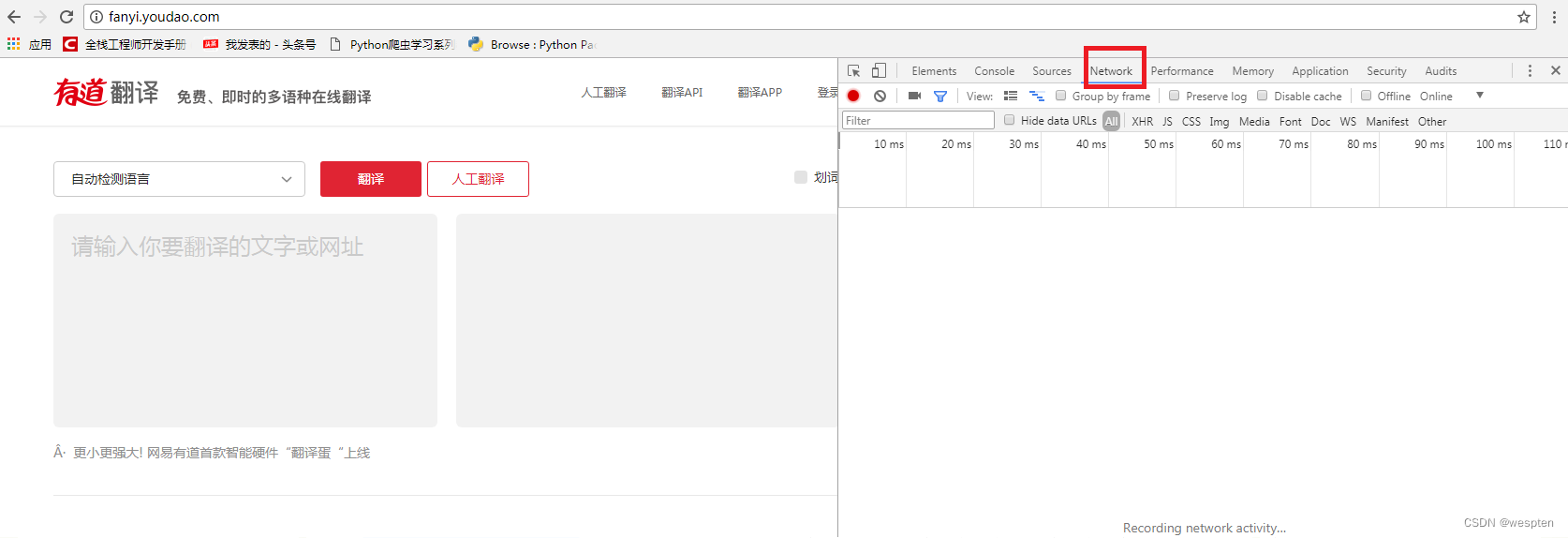

打开有道翻译的网址http://fanyi.youdao.com/

右键检查(审查元素)-切换到Network切换到网络监听部分。

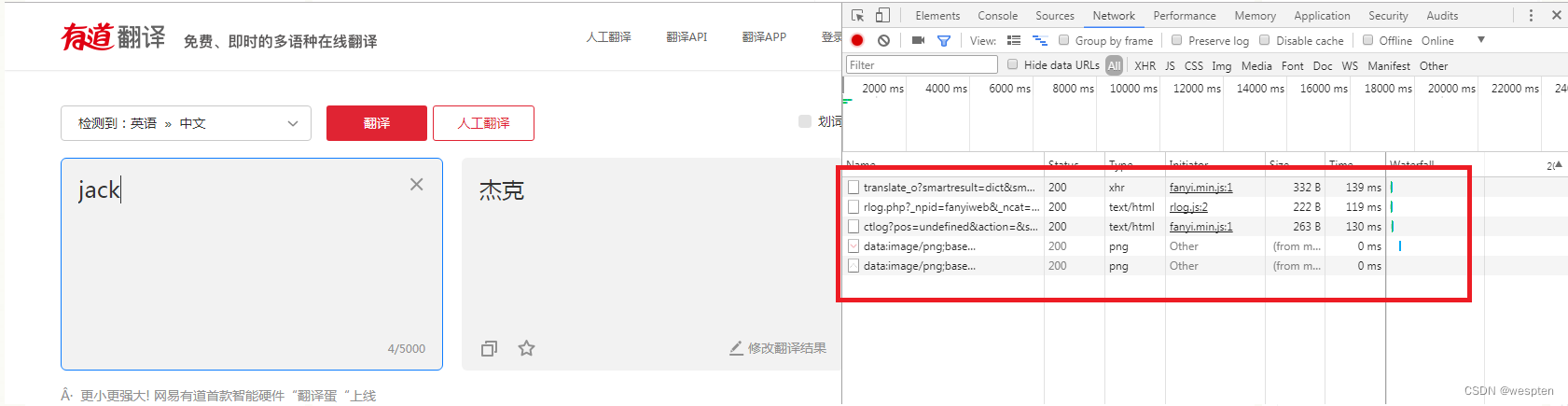

在左侧翻译区输入你要翻译的内容如“jack”,回车后网页自动翻译,获取了翻译结果“杰克”,同时我们看到在右侧网络监听部分,已经显示出在此过程中所有的信息交互。

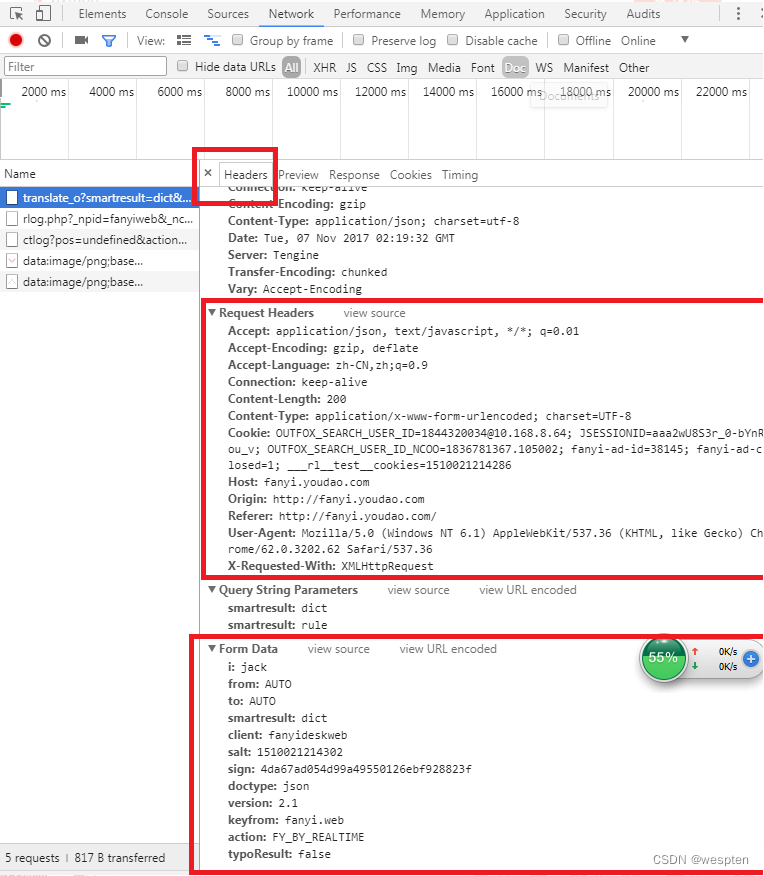

我们点击第一个信息交互记录,可以进入此次交互的详情。包括http头(MIME),和请求数据的格式。我们要发送的数据格式就按照图中的格式添加就可以了。

4. urllib.error

urllib.error有两个方法,URLError和HTTPError

URLError是OSError的一个子类,HTTPError是URLError的一个子类,服务器上HTTP的响应会返回一个状态码,根据这个HTTP状态码,我们可以知道我们的访问是否成功。200状态码,表示请求成功,再比如常见的404错误等。

最后值得注意的一点是,如果想用HTTPError和URLError一起捕获异常,那么需要将HTTPError放在URLError的前面,因为HTTPError是URLError的一个子类。如果URLError放在前面,出现HTTP异常会先响应URLError,这样HTTPError就捕获不到错误信息了。

5. urllib.request.ProxyHandler

设置代理服务器,防止限制IP。

在python2中是urllib2.ProxyHandler函数。

控制代理服务器,防止服务器限制IP。

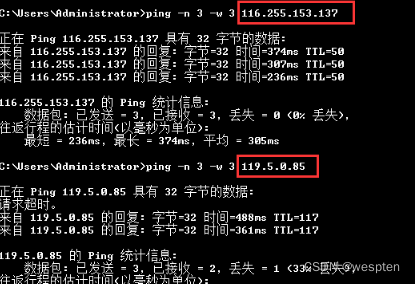

每隔一段时间换一个代理服务器,代理服务器的ip你可以从网页中自己选择和定期更换。

URL:http://www.xicidaili.com/

#控制代理服务器,防止服务器限制IP。每隔一段时间换一个代理服务器

enable_proxy = True

proxy_handler=urllib.request.ProxyHandler({"http":"61.135.217.7:80"})

null_proxy_handler = urllib.request.ProxyHandler({})

if enable_proxy:

opener = urllib.request.build_opener(proxy_handler)

else:

opener = urllib.request.build_opener(null_proxy_handler)

urllib.request.install_opener(opener)

使用install_opener方法之后,会将程序默认的urlopen方法替换掉。也就是说,如果使用install_opener之后,在该文件中,再次调用urlopen会使用自己创建好的opener。如果不想替换掉,只是想临时使用一下,可以使用opener.open(url),这样就不会对程序默认的urlopen有影响。

编写代码访问http://www.whatismyip.com.tw/,该网站是测试自己IP为多少的网址,服务器会返回访问者的IP。在使用代理服务器以后,访问这里查询本地IP地址的网址的返回结果也会由于代理服务器的存在而随机变化。

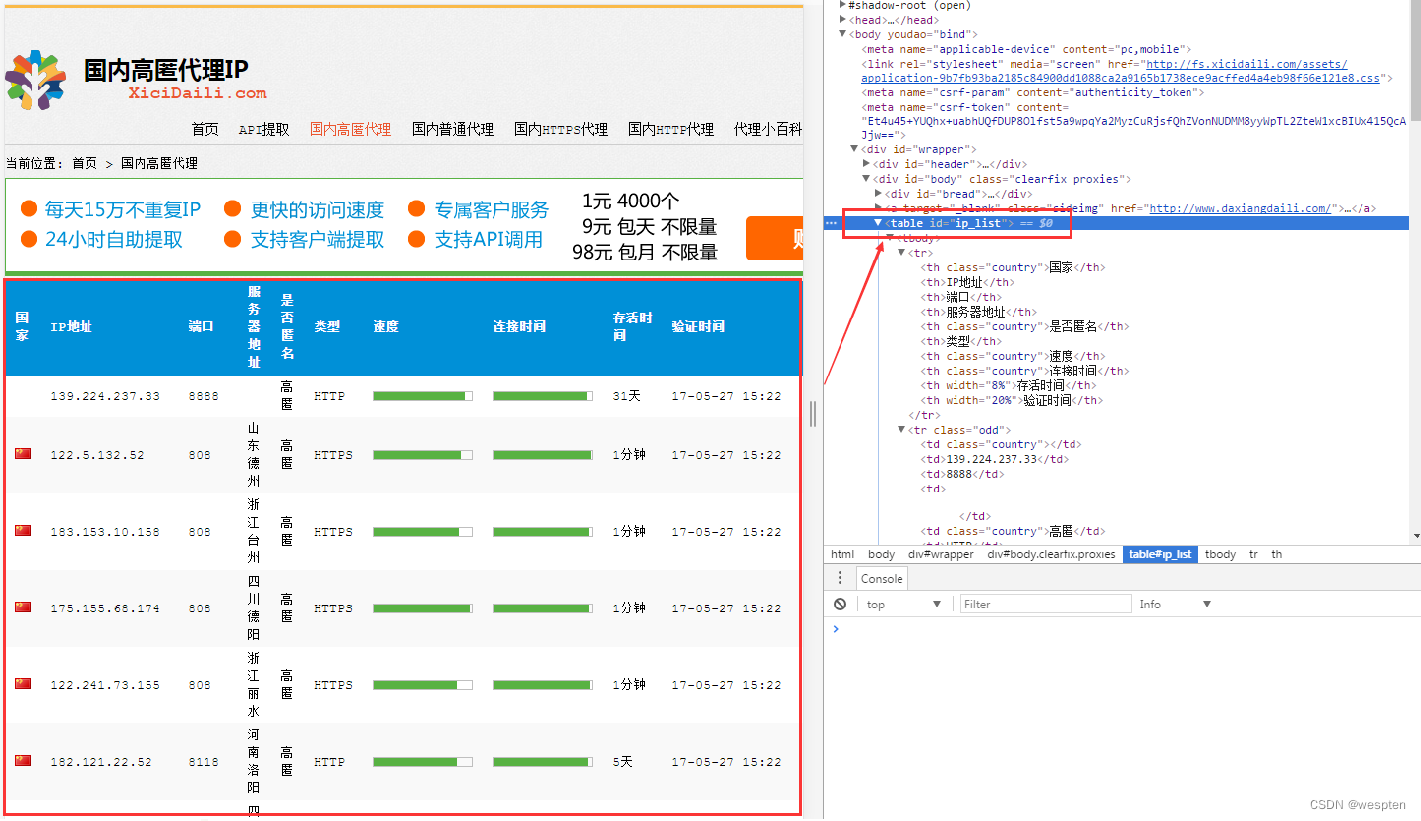

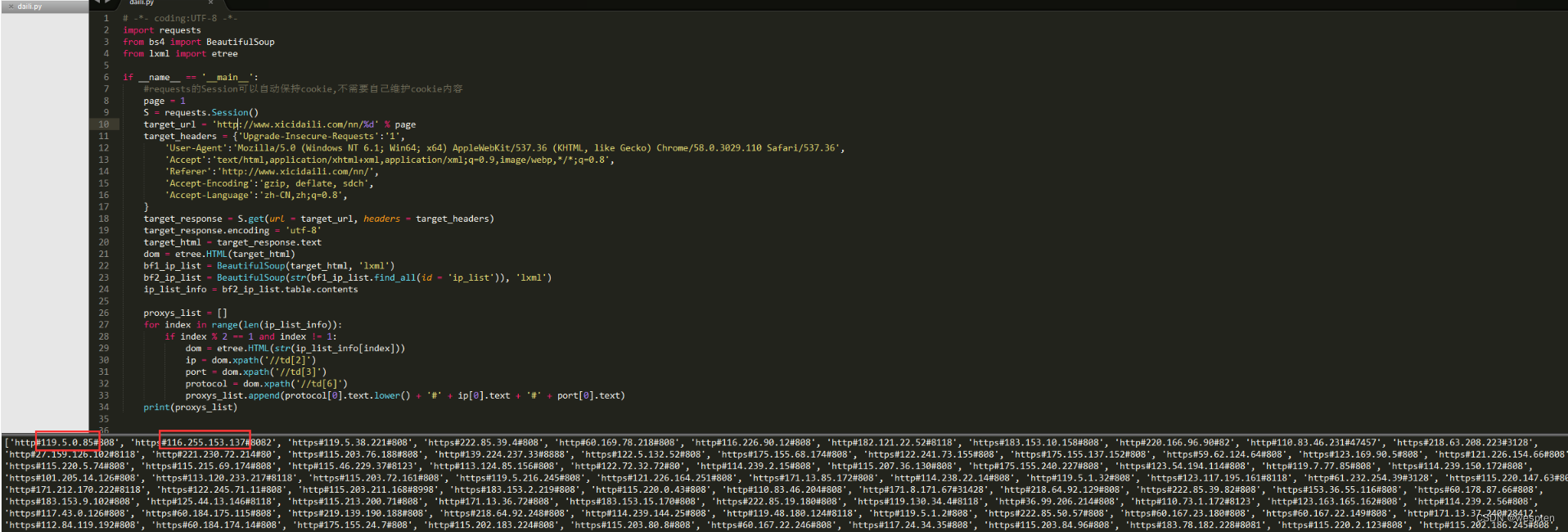

下面实现了一个爬虫,爬取http://www.xicidaili.com/ 网站中代理服务器的列表:

#coding:utf-8

#本实例用于获取国内高匿免费代理服务器

import urllib

from bs4 import BeautifulSoup

def getdata(html): #从字符串中安装正则表达式获取值

allproxy = [] # 所有的代理服务器信息

soup = BeautifulSoup(html, 'html.parser')

alltr = soup.find_all("tr", class_="")[1:] #获取tr ,第一个是标题栏,去除

for tr in alltr:

alltd =tr.find_all('td')

oneproxy ={

'IP地址':alltd[1].get_text(),

'端口号': alltd[2].get_text(),

# '服务器地址': alltd[3].a.get_text(),

'是否匿名': alltd[4].get_text(),

'类型': alltd[5].get_text(),

'速度': alltd[6].div['title'],

'连接时间': alltd[7].div['title'],

'存活时间': alltd[8].get_text(),

'验证时间': alltd[9].get_text(),

}

allproxy.append(oneproxy)

alltr = soup.find_all("tr", class_="odd")[1:] # 获取tr ,第一个是标题栏,去除

for tr in alltr:

alltd = tr.find_all('td')

oneproxy = {

'IP地址': alltd[1].get_text(),

'端口号': alltd[2].get_text(),

# '服务器地址': alltd[3].a.get_text(),

'是否匿名': alltd[4].get_text(),

'类型': alltd[5].get_text(),

'速度': alltd[6].div['title'],

'连接时间': alltd[7].div['title'],

'存活时间': alltd[8].get_text(),

'验证时间': alltd[9].get_text(),

}

allproxy.append(oneproxy)

return allproxy

#根据一个网址,获取该网址中符合指定正则表达式的内容

def getallproxy(url='"http://www.xicidaili.com/nn"'):

try:

# 构造 Request headers

agent = 'Mozilla/5.0 (Windows NT 6.3; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/57.0.2987.98 Safari/537.36 LBBROWSER'

headers = { # 这个http头,根据审查元素,监听发包,可以查看

"Host": "www.xicidaili.com",

"Referer": "http://www.xicidaili.com/",

'User-Agent': agent

}

request = urllib.request.Request(url, headers=headers) # 创建一个请求

response = urllib.request.urlopen(request) # 获取响应

html = response.read() #读取返回html源码

return getdata(html)

except urllib.error.URLError as e:

if hasattr(e,"code"):

print(e.code)

if hasattr(e,"reason"):

print(e.reason)

return []

# allproxy = getallproxy()

# print(allproxy)

有了上面的列表就可以直接从数组中随机选择一个代理服务器:

allproxy = proxy.getallproxy() #获取一批代理服务器列表

...

oneproxy = random.choice(allproxy) #随机选择一个代理服务器

proxy_handler = urllib.request.ProxyHandler({"http": oneproxy['IP地址']+":"+oneproxy['端口号']}) #将代理服务器ip绑定到请求对象中

6. urllib.request.HTTPCookieProcessor

设置cookie。

在python2中是urllib2.HTTPCookieProcessor函数:

cookie=cookielib.CookieJar() #声明一个CookieJar对象实例来保存cookie

handler=urllib.request.HTTPCookieProcessor(cookie) #利用urllib2库的HTTPCookieProcessor对象来创建cookie处理器

opener=urllib.request.build_opener(handler) #通过handler来构建opener

resphonse=opener.open('http://blog.csdn.net/luanpeng825485697/article/details/78264170') #cookie是由服务器来设定的存储在客户端,客户端每次讲cookie发送给服务器来携带数据

for item in cookie:

print('Name='+item.name)

print('Value='+item.value)

将cookie写入文件:

filename='cookie.txt'

cookie=cookielib.MozillaCookieJar(filename) #声明一个MozillaCookieJar对象实例来保存cookie,之后写入文件

handler=urllib.request.HTTPCookieProcessor(cookie) #利用urllib2库的HTTPCookieProcessor对象来创建cookie处理器

opener = urllib.request.build_opener(handler) #通过handler来构建opener

resphonse=opener.open('http://blog.csdn.net/luanpeng825485697/article/details/78264170') #创建一个请求,原理同urllib2的urlopen

cookie.save(ignore_discard=True, ignore_expires=True) #保存cookie文件

cookie.save的参数说明:

- ignore_discard的意思是即使cookies将被丢弃也将它保存下来;

- ignore_expires的意思是如果在该文件中cookies已经存在,则覆盖原文件写入。

在这里,我们将这两个全部设置为True。

运行之后,cookies将被保存到cookie.txt文件中。我们可以查看自己查看下cookie.txt这个文件的内容。

从文件中读取cookie:

cookie=cookielib.MozillaCookieJar() #声明一个MozillaCookieJar对象实例

cookie.load("cookie.txt",ignore_discard=True, ignore_expires=True) #从文件中读取cookie内容到变量

req=urllib.request.Request("http://blog.csdn.net/luanpeng825485697/article/details/78264170") #创建请求的request

opener=urllib.request.build_opener(urllib.request.HTTPCookieProcessor(cookie)) #利用urllib2的build_opener方法创建一个opener

response=opener.open(req) #使用包含了指定cookie的opener发起请求

print(resphonse.read()) #打印响应

利用cookie模拟登陆:

创建一个带有cookie的opener,在访问登录的URL时,将登录后的cookie保存下来,然后利用这个cookie来访问其他网址。

现在很多网站需要登陆后才能访问,如知乎,地址https://www.zhihu.com

在没有登陆时访问这个网址,只能出现登陆界面。

如果登陆以后,在访问这个网址,就会出现文章列表:

这是因为访问此地址,知乎服务器会查询请求cookie,如果请求cookie没有用户信息,就证明没有登陆,就会返回登陆界面,如果有cookie信息就会返回文章列表界面,同时包含用户的其他信息。所以首先需要让自己的请求中能带有包含自己信息的cookie。这一步通过登陆来实现。

在登陆界面,通过post将用户账号密码发送给服务器,服务器会将用户信息以cookie的形式返回给用户,用户在下次请求时,就会自动将这个cookie添加到请求http头中,这样下次再访问时,服务器就知道这个用户已经登陆了。

所以在使用cookie模拟登陆,需要两步,第一步是获取cookie,第二步是将cookie添加到http中,模拟用户已经存在的方式请求文章。

第一步,登陆获取cookie(通过post向指定网址发送数据,获取返回cookie即可)

对于发送数据需要添加的post数据和http头可以通过审查元素监听。

由于浏览器的监听在跳转到新的网页就会清空重新监听,所以在登陆到文章列表页面,浏览先监听了登陆页面的数据,后清空监听记录,重新监听文章列表页面的数据。不能及时记录下载登陆界面发送的请求数据,所以建议使用fiddle监听数据。

不过也不是没有办法,监听区红色的记录开关按钮,可以及时的阻止监听。

这里在点击登陆后,我立刻点击了浏览监听中的红色记录按钮,拦截了登陆界面的数据。

可以看到需要发送的数据除了phone_num手机号、password密码、captcha_type验证码类型(选择不同的登陆方式需要发送的数据类型可以不同),还有一个_xsrf,这个字段是在登陆网页源代码中:

所以在发送post前还要获取网页源代码解析这个字段。

# -*- coding: UTF-8 -*-

import requests

#import http.cookiejar as cookielib

from bs4 import BeautifulSoup

import cookielib

#post登陆信息,生成cookie文件

session = requests.Session()

session.cookies = cookielib.LWPCookieJar("cookie")

agent = 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Maxthon/5.1.2.3000 Chrome/55.0.2883.75 Safari/537.36'

headers = { #这个http头,根据审查元素,监听发包,可以查看

"Host": "www.zhihu.com",

"Origin":"https://www.zhihu.com/",

"Referer":"http://www.zhihu.com/",

'User-Agent':agent

}

postdata = {

'phone_num': '18158208197', #填写手机号

'password': '19910101a', #填写密码

'captcha_type':'cn',

}

response = session.get("https://www.zhihu.com", headers=headers)

soup = BeautifulSoup(response.content, "html.parser")

xsrf = soup.find('input', attrs={"name": "_xsrf"}).get("value") #解析_xsrf字段

postdata['_xsrf'] =xsrf #因为知乎登陆需要这个字段的消息

result = session.post('http://www.zhihu.com/login/email', data=postdata, headers=headers) #发送数据

session.cookies.save(ignore_discard=True, ignore_expires=True) #及时登陆失败也会生成cookie,不过这个cookie不能支持后面的模拟登陆状态

第二步、通过获取的cookie,模拟已经登陆的状态。这样再次访问知乎网址,就能获取文章了。

访问文章需要的http头可以通过审查元素查看。

# -*- coding: UTF-8 -*-

import requests

#import http.cookiejar

from bs4 import BeautifulSoup

import cookielib

#加载cookie文件模拟登陆

session = requests.session()

session.cookies = cookielib.LWPCookieJar(filename='cookie')

try:

session.cookies.load(ignore_discard=True)

except:

print("Cookie 未能加载")

def isLogin():

url = "https://www.zhihu.com/"

login_code = session.get(url, headers=headers, allow_redirects=False).status_code

if login_code == 200:

return True

else:

return False

if __name__ == '__main__':

agent = 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Maxthon/5.1.2.3000 Chrome/55.0.2883.75 Safari/537.36'

headers = {

"Host": "www.zhihu.com",

"Origin": "https://www.zhihu.com/",

"Referer": "http://www.zhihu.com/",

'User-Agent': agent,

}

if isLogin():

print('您已经登录')

四、正则表达式

前面使用requests模块发起请求来获取静态网页或动态网页的数据。对于动态加载的数据,我们可以直接提取出JSON格式数据;但是对于静态网页,爬取到的网页源代码中有很多内容是我们不需要的,还需要做进一步的筛选。

我们可以使用正则表达式对网页源代码的字符串进行匹配,从而提取出需要的数据。

1、正则表达式基础

正则表达式用于对字符串进行匹配操作,符合正则表达式逻辑的字符串能被匹配并提取出来。正则表达式由一些特定的字符组成,每个字符有不同的含义,编写正则表达式就是利用这些字符组合出用于匹配特定字符串的规则。将编写好的正则表达式与爬取到的网页源代码进行对比,就能筛选出符合要求的字符串。Python内置的re模块可以处理正则表达式。

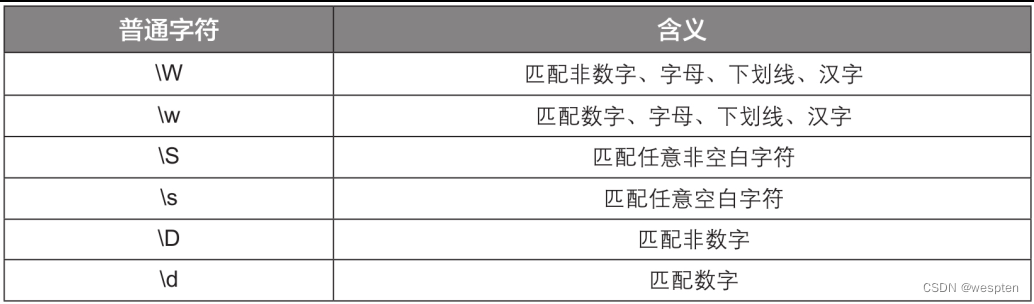

组成正则表达式的字符分为两种基本类型:普通字符和元字符。

普通字符包含所有大写和小写字母、所有数字、所有标点符号和一些其他符号。

常用普通字符的含义见下表:

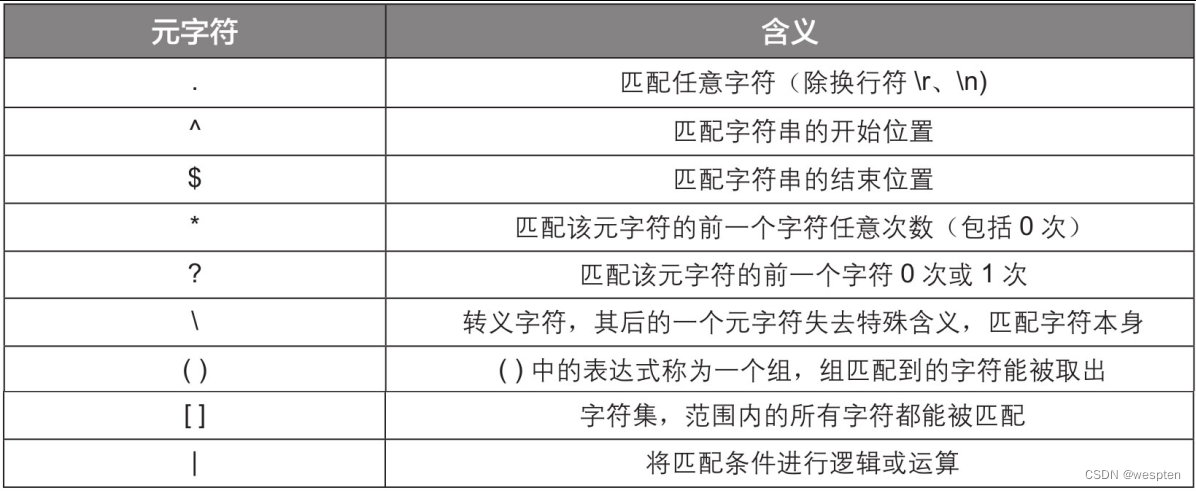

元字符是指在正则表达式中具有特殊含义的专用字符,可以用来规定其前导字符(即位于元字符前面的字符)在目标对象中的出现模式,使正则表达式具有处理能力。

常用元字符的含义见下表:

下面通过一些简单的实例,帮助大家理解普通字符和元字符的用法。

1. \w和\W的用法

演示代码如下:

1 import re

2 str1 = '123Qwe!_@#你我他'

3 print(re.findall('\w', str1)) # 匹配所有字母、数字、下划线、汉字

4 print(re.findall('\W', str1)) # 匹配所有非字母、数字、下划线、汉字代码运行结果如下:

1 ['1', '2', '3', 'Q', 'w', 'e', '_', '你', '我', '他']

2 ['!', '@', '#'] 2. \s和\S的用法

演示代码如下:

1 import re

2 str2 = "123Qwe!_@#你我他\t \n\r"

3 print(re.findall('\s', str2)) # 匹配所有空白字符,如空格、换行符\r和\n、制表符\t

4 print(re.findall('\S', str2)) # 匹配所有非空白字符代码运行结果如下:

1 ['\t', ' ', '\n', '\r']

2 ['1', '2', '3', 'Q', 'w', 'e', '!', '_', '@', '#', '你', '我', '他']3. \d和\D的用法

演示代码如下:

1 import re

2 str3 = "123Qwe!_@#你我他\t \n\r"

3 print(re.findall('\d', str3)) # 匹配所有数字

4 print(re.findall('\D', str3)) # 匹配所有非数字代码运行结果如下:

1 ['1', '2', '3']

2 ['Q', 'w', 'e', '!', '_', '@', '#', '你', '我', '他', '\t', ' ', '\n', '\r]4. ^和$的用法

演示代码如下:

1 import re

2 str4 = '你好吗,我很好'

3 print(re.findall('^你好', str4)) # 匹配位于字符串开头的“你好”

4 str5 = '我很好,你好'

5 print(re.findall('你好$', str5)) # 匹配位于字符串末尾的“你好”代码运行结果如下:

1 ['你好']

2 ['你好']5. .、*、?的用法

演示代码如下:

1 import re

2 str6 = 'abcaaabb'

3 print(re.findall('a.b', str6)) # 匹配任意一个字符

4 print(re.findall('a?b', str6)) # 匹配字符a 0次或1次

5 print(re.findall('a*b', str6)) # 匹配字符a任意次数(包括0次)

6 print(re.findall('a.*b', str6)) # 匹配任意字符任意次数(贪婪匹配)

7 print(re.findall('a.*?b', str6)) # 匹配任意字符任意次数(非贪婪匹配)代码运行结果如下:

1 ['aab']

2 ['ab', 'ab', 'b']

3 ['ab', 'aaab', 'b']

4 ['abcaaabb']

5 ['ab', 'aaab']注意:正则表达式“.*”表示匹配任意个数的任意字符,能匹配多长就匹配多长,称为贪婪匹配;正则表达式“.*?”也表示匹配任意个数的任意字符,但是能匹配多短就匹配多短,称为非贪婪匹配。

6. 转义字符\的用法

演示代码如下:

1 import re

2 str7 = '\t123456'

3 print(re.findall('t', str7)) # 匹配不到字符t,因为\t有特殊含义,是一个整体

4 str8 = '\\t123456'

5 print(re.findall('t', str8)) # 使用转义字符\后,\t变为无特殊含义的普通字符,能匹配到字符t

6 str9 = r'\t123456' # 在字符串前加r也可以对字符串进行转义

7 print(re.findall('t', str9))代码运行结果如下:

1 []

2 ['t']

3 ['t']7. 字符集[]的用法

演示代码如下:

1 import re

2 str10 = 'aab abb acb azb a1b'

3 print(re.findall('a[a-z]b', str10)) # 只要中间的字符在字母a~z之间就能被匹配到

4 print(re.findall('a[0-9]b', str10)) # 只要中间的字符在数字0~9之间就能被匹配到

5 print(re.findall('a[ac1]b', str10)) # 只要中间的字符是字符集[ac1]的成员就能被匹配到代码运行结果如下:

1 ['aab', 'abb', 'acb', 'azb']

2 ['a1b']

3 ['aab', 'acb', 'a1b']8. 分组()与元字符的搭配使用

演示代码如下:

1 import re

2 str11 = '123qwer'

3 print(re.findall('(\w+)q(\w+)', str11)) # \w+代表匹配一个或多个数字、字母、下划线、汉字代码运行结果如下:

1 [('123', 'wer')]9. 逻辑或|的用法

演示代码如下:

1 import re

2 str12 = '你好,女士们先生们,大家好好学习呀'

3 print(re.findall('女士|先生', str12)) # 匹配“女士”或“先生”代码运行结果如下:

1 ['女士', '先生']2、用正则表达式提取数据

代码文件:用正则表达式提取数据.py

学会了正则表达式的编写方法,就可以利用re模块提供的一些函数,在网页源代码中根据正则表达式匹配和提取数据了。

常用的几个函数介绍如下。

1. findall()函数

findall()函数能提取满足正则表达式的所有字符串。

演示代码如下:

1 import requests

2 import re

3 url = 'https://www.cnblogs.com/'

4 headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.75 Safari/537.36'}

5 response = requests.get(url=url, headers=headers).text

6 ex = '<div class="post_item_body">.*?target="_blank">(.*?)</a></h3>' # 正则表达式

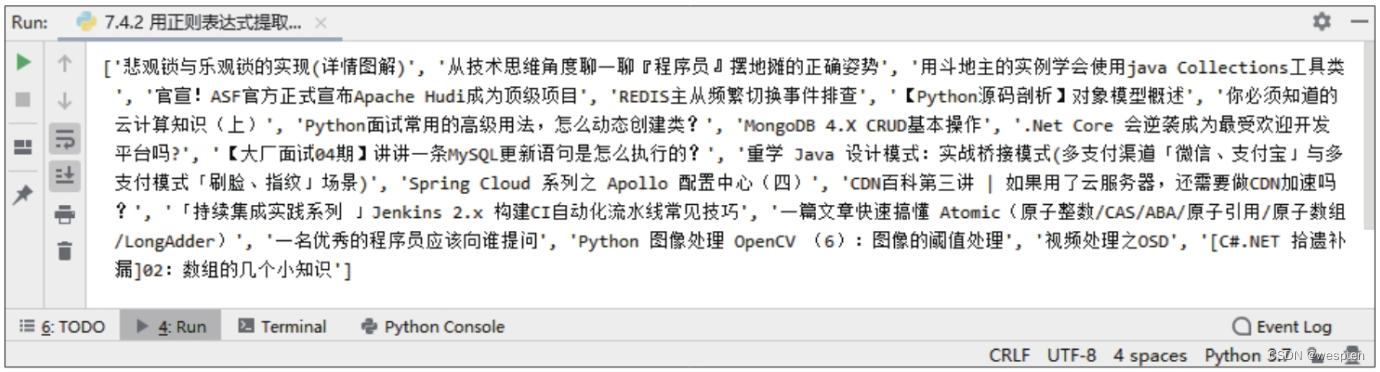

7 print(re.findall(ex, response, re.S))上述代码爬取的是博客园首页的热门技术博客标题。第6行代码中的正则表达式含义为:先匹配出以“<div class="post_item_body">×××target="_blank">”开头、以“</a></h3>”结尾的所有字符串片段,再在片段中定位“target="_blank">”和“</a></h3>”之间的字符串,并将其提取出来。

第7行代码使用findall()函数根据第6行代码定义的正则表达式在网页源代码中提取字符串,其中的参数re.S表示匹配换行符。

代码运行结果如下:

2. search()函数

search()函数只会匹配第一个满足正则表达式的字符串,匹配后用group()函数取值。

演示代码如下:

1 import re

2 str1 = '123Qwe!_@#你我他'

3 ret = re.search('\w', str1) # 匹配第一个字母、数字、下划线、汉字,如果匹配不到,会返回None,使用group()函数取值时会报错

4 print(ret.group()) # 使用group()函数取值代码运行结果如下:

1 13. match()函数

match()函数和search()函数的功能差不多,区别是match()函数是从开头匹配,如果开头不满足正则表达式,后面满足正则表达式的字符串也不会被匹配到。

4. finditer()函数

finditer()函数和findall()函数的功能差不多,区别是findall()函数返回的是一个列表,finditer()函数返回的则是一个迭代器,需要利用循环来取值。

演示代码如下:

1 import re

2 str1 = '123Qwe!_@#你我他'

3 ret = re.finditer('\w', str1) # 匹配所有字母、数字、下划线、汉字

4 for i in ret:

5 print(i.group(), end='') # end=''表示输出时不换行代码运行结果如下:

1 123Qwe_你我他五、XPath表达式与BeautifulSoup模块

1、BeautifulSoup模块

通过正则表达式从网页源代码中提取数据是从字符串处理的角度来进行的,这种方法需要分析网页源代码的特征和规律,并编写复杂的正则表达式,对于不熟悉HTML和正则表达式的人来说难度比较高。那么有没有更简单的方法呢?答案是肯定的。

在开发者工具中可以看到,网页源代码是由结构化的Elements对象组成的,如果能解析这个结构,在结构中定位包含所需内容的标签,再将标签中的内容提取出来,就能得到想要的数据。

BeautifulSoup 提供一些简单的、python 式的函数用来处理导航、搜索、修改分析树等功能。它是一个工具箱,通过解析文档为用户提供需要抓取的数据。

建议使用“pip install beautifulsoup4”或"pip install bs4"命令安装该模块的最新版本。

BeautifulSoup模块是一个HTML/XML解析器,主要用于解析和提取HTML/XML文档中的数据。该模块不仅支持Python标准库中的HTML解析器,而且支持许多功能强大的第三方解析器。推荐使用lxml解析器,该解析器能将网页源代码加载为BeautifulSoup对象,再使用对象的方法提取数据。

1. 常用属性与方法

1)解析HTML文档

soup = BeautifulSoup(html_doc, 'html.parser')

- html_doc:文档名称

- "html_parser":解析网页所需的解析器

2)用soup.prettify更友好地打印网页

print(soup.prettify())

3)常用属性

- soup.title:返回 title 部分的全部内容:<title>The Dormouse's story</title>

- soup.title.name:返回 title 标签的名称( name 标签):'title'

- soup.title.string:返回这个标签的内容:"The Dormouse's story"

- soup.find_all('a'):返回所有超链接的元素如下:

<a class="sister" href="http://example.com/elsie" id="link1">Elsie</a>,

<a class="sister" href="http://example.com/lacie" id="link2">Lacie</a>,

<a class="sister" href="http://example.com/tillie" id="link3">Tillie</a>]- soup.find(id="link3"):返回 id=link3 部分的内容,如下:

<a class="sister" href="http://example.com/tillie" id="link3">Tillie</a>]

2. BeautifulSoup使用

1)实例化BeautifulSoup对象

简单来说,实例化BeautifulSoup对象就是使用解析器分析指定的网页源代码,得到该源代码的结构模型。

要解析的网页源代码可以是存储在本地硬盘上的HTML文档,也可以是爬虫程序从网站服务器获取到的源代码字符串。下面分别介绍具体方法。

将本地硬盘上存储的HTML文档实例化为BeautifulSoup对象的演示代码如下:

1 from bs4 import BeautifulSoup

2 fp = open('test1.html', encoding='utf-8') # 读取本地HTML文档

3 soup = BeautifulSoup(fp, 'lxml') # 用读取的HTML文档实例化一个BeautifulSoup对象,第2个参数'lxml'表示指定解析器为lxml将获取到的网页源代码字符串实例化为BeautifulSoup对象的演示代码如下:

1 from bs4 import BeautifulSoup

2 import requests

3 headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36'}

4 response = requests.get(url='https://www.baidu.com', headers=headers).text # 获取网页源代码

5 soup = BeautifulSoup(response, 'lxml') # 用获取的网页源代码实例化BeautifulSoup对象2)用BeautifulSoup对象定位标签

代码文件:用BeautifulSoup对象定位标签.py、test1.html

实例化一个BeautifulSoup对象后,就可以使用该对象来定位网页中的标签元素。将通过一个简单的网页“test1.html”讲解标签定位的方法。

该文件中的网页源代码如下:

1 <html lang = 'en'>

2 <head>

3 <meta charset = 'UTF-8' />

4 <title>测试BeautifulSoup</title>

5 </head>

6 <body>

7 <div class = 'first ten'></div>

8 <div class = 'first'>第一个div

9 <p>first div下的p标签</p>

10 <a href = 'http://www.baidu.com/' title = '百度一下' target = '_self' class = 'first'>

11 <span>a标签下的span标签</span>

12 first div下的第一个a标签

13 </a>

14 <a href="" class="two"></a>

15 <img src="" alt="" />

16 </div>

17 <div class="two">

18 <ul>

19 <li class="first" id="first">第一个li标签</li>

20 <li class="two" id="two">第二个li标签</li>

21 <li class="three" id="three">第三个li标签</li>

22 <li class="four" id="four">第四个li标签</li>

23 <li class="five" id="five">第五个li标签</li>

24 </ul>

25 </div>

26 </body>

27 </html>(1)通过标签名进行定位

网页源代码中可能会有多个同名标签,通过标签名进行定位只能返回其中的第一个标签。演示代码如下:

1 from bs4 import BeautifulSoup

2 fp = open('test1.html', encoding='utf-8') # 读取HTML文档

3 soup = BeautifulSoup(fp, 'lxml') # 实例化BeautifulSoup对象

4 print(soup.p) # 通过标签名定位第一个<p>标签代码运行结果如下:

1 <p>first div下的p标签</p>(2)通过标签属性进行定位

标签属性有class、id等,实践中主要使用class属性来定位标签。需要注意的是,因为class这个单词本身是Python的保留字,所以BeautifulSoup模块中的class属性在末尾添加了下划线来进行区分。其他标签属性,如id属性,则没有添加下划线。

演示代码如下:

1 from bs4 import BeautifulSoup

2 fp = open('test1.html', encoding='utf-8')

3 soup = BeautifulSoup(fp, 'lxml')

4 print(soup.find(class_='first')) # 返回class属性值为first的第一个标签

5 print(soup.find_all(class_='first')) # 返回class属性值为first的所有标签的列表第4行代码中的find()函数可以返回符合属性条件的第一个标签。第5行代码中的find_all()函数则可以将符合属性条件的所有标签放在一个列表中返回。

代码运行结果如下:

1 <div class="first ten"></div>

2 [<div class="first ten"></div>, <div class="first">第一个div

3 <p>first div下的p标签</p>

4 <a class="first" href="http://www.baidu.com/" target="_self" title="百度一下">

5 <span>a标签下的span标签</span>

6 first div下的第一个a标签

7 </a>

8 <a class="two" href=""></a>

9 <img alt="" src=""/>

10 </div>, <a class="first" href="http://www.baidu.com/" target="_self" title="百度一下">

11 <span>a标签下的span标签</span>

12 first div下的第一个a标签

13 </a>, <li class="first" id="first">第一个li标签</li>]一个标签的属性可以有多个值,例如,第一个<div>标签的class属性就有first和ten两个值。从运行结果可以看出,find()和find_all()函数在执行时,只要标签的任意一个值满足条件,就会将标签返回。

(3)通过标签名+标签属性进行定位

将标签名和标签属性相结合也可以定位标签。

演示代码如下:

1 from bs4 import BeautifulSoup

2 fp = open('test1.html', encoding='utf-8')

3 soup = BeautifulSoup(fp, 'lxml')

4 print(soup.find('div', class_='first'))

5 print(soup.find_all('div', class_='first'))第4行和第5行代码中的find()和find_all()函数的功能在前面已经介绍过,这里为函数设置的第1个参数为标签名,第2个参数为标签属性值。

代码运行结果如下:

1 <div class="first ten"></div>

2 [<div class="first ten"></div>, <div class="first">第一个div

3 <p>first div下的p标签</p>

4 <a class="first" href="http://www.baidu.com/" target="_self" title="百度一下">

5 <span>a标签下的span标签</span>

6 first div下的第一个a标签

7 </a>

8 <a class="two" href=""></a>

9 <img alt="" src=""/>

10 </div>](4)通过选择器进行定位

使用select()函数可以根据指定的选择器返回所有符合条件的标签。常用的选择器有id选择器、class选择器、标签选择器和层级选择器,下面一一介绍。

- id选择器

id选择器可以根据标签的id属性进行定位。

演示代码如下:

1 from bs4 import BeautifulSoup

2 fp = open('test1.html', encoding='utf-8')

3 soup = BeautifulSoup(fp, 'lxml')

4 print(soup.select('#first'))第4行代码中,select()函数括号中的'#first'是id选择器的书写格式,“#”代表id选择器,“#”后的内容为id属性的值。代码运行结果如下:

1 [<li class="first" id="first">第一个li标签</li>]从运行结果可以看出,尽管符合条件的标签只有一个,返回的仍然是一个列表。

- class选择器

class选择器可以根据标签的class属性进行定位。

演示代码如下:

1 from bs4 import BeautifulSoup

2 fp = open('test1.html', encoding='utf-8')

3 soup = BeautifulSoup(fp, 'lxml')

4 print(soup.select('.first'))第4行代码中,select()函数括号中的'.first'是class选择器的书写格式,“.”代表class选择器,“.”后的内容为class属性的值。

代码运行结果如下:

1 [<div class="first ten"></div>, <div class="first">第一个div

2 <p>first div下的p标签</p>

3 <a class="first" href="http://www.baidu.com/" target="_self" title="百度一下">

4 <span>a标签下的span标签</span>

5 first div下的第一个a标签

6 </a>

7 <a class="two" href=""></a>

8 <img alt="" src=""/>

9 </div>, <a class="first" href="http://www.baidu.com/" target="_self" title="百度一下">

10 <span>a标签下的span标签</span>

11 first div下的第一个a标签

12 </a>, <li class="first" id="first">第一个li标签</li>]从运行结果可以看出,返回了class属性值为first的所有标签。

- 标签选择器

用标签选择器进行定位与只用标签名进行定位的不同之处在于,该方法能返回所有该类型的标签。演示代码如下:

1 from bs4 import BeautifulSoup

2 fp = open('test1.html', encoding='utf-8')

3 soup = BeautifulSoup(fp, 'lxml')

4 print(soup.select('li')) # 返回所有<li>标签代码运行结果如下:

1 [<li class="first" id="first">第一个li标签</li>, <li class="two" id="two">第二个li标签</li>, <li class="three" id="three">第三个li标签</li>, <li class="four" id="four">第四个li标签</li>, <li class="five" id="five">第五个li标签</li>]- 层级选择器

一个标签可以包含另一个标签,这些标签位于不同的层级,形成层层嵌套的结构。利用层级选择器可以先定位外层的标签,再定位内层的标签,这样一层层地往里定位,就能找到需要的标签。

演示代码如下:

1 from bs4 import BeautifulSoup

2 fp = open('test1.html', encoding='utf-8')

3 soup = BeautifulSoup(fp, 'lxml')

4 print(soup.select('div>ul>#first')) # 选中所有<div>标签下<ul>标签中id属性值为first的所有标签

5 print(soup.select('div>ul>li')) # 选中所有<div>标签下所有<ul>标签中的所有<li>标签

6 print(soup.select('div li')) # 选中<div>标签包含的所有<li>标签第4行和第5行代码中的“>”在层级选择器中表示向下找一个层级,中间不能有其他层级。第6行代码中的空格表示中间可以有多个层级。

代码运行结果如下:

1 [<li class="first" id="first">第一个li标签</li>]

2 [<li class="first" id="first">第一个li标签</li>, <li class="two" id="two">第二个li标签</li>, <li class="three" id="three">第三个li标签</li>, <li class="four" id="four">第四个li标签</li>, <li class="five" id="five">第五个li标签</li>]

3 [<li class="first" id="first">第一个li标签</li>, <li class="two" id="two">第二个li标签</li>, <li class="three" id="three">第三个li标签</li>, <li class="four" id="four">第四个li标签</li>, <li class="five" id="five">第五个li标签</li>]3)从标签中提取文本内容和属性值

(1)从标签中提取文本内容

定位到标签后,还需要从标签中提取文本内容,才能获得需要的数据。从标签中提取文本内容可以利用标签的string属性或text属性。

string属性返回的是指定标签的直系文本,即直接存在于该标签中的文本,而不是存在于该标签下的其他标签中的文本。text属性返回的则是指定标签下的所有文本。

演示代码如下:

1 from bs4 import BeautifulSoup

2 fp = open('test1.html', encoding='utf-8')

3 soup = BeautifulSoup(fp, 'lxml')

4 print(soup.select('.first')[1].string)

5 print(soup.select('.first')[1].text)第4行和第5行代码中的“select('.first')[1]”表示使用select()函数根据class选择器定位class属性值为first的所有标签,再从返回的标签列表中指定第2个标签用于提取文本内容。第4行代码使用string属性提取直系文本,如果当前标签没有直系文本,或者由于当前标签包含子标签导致string属性无法确定要提取哪些文本,会返回None。第5行代码使用text属性提取所有文本。

代码运行结果如下:

1 None

2 第一个div

3 first div下的p标签

4

5 a标签下的span标签

6 first div下的第一个a标签(2)从标签中提取属性

定位到标签后,还可以通过字典取值的方式取出标签的属性值。

演示代码如下:

1 from bs4 import BeautifulSoup

2 fp = open('test1.html', encoding='utf-8')

3 soup = BeautifulSoup(fp, 'lxml')

4 print(soup.find(class_='first')['class'])第4行代码表示定位class属性值为first的第一个标签,然后提取该标签的class属性值,返回一个列表。

代码运行结果如下:

1 ['first', 'ten']3. BeautifulSoup使用案例

1)爬取“NATIONAL WEATHER”的天气数据

import requests

from bs4 import BeautifulSoup

# 通过requests来获取我们需要爬取的网页

weather_url = 'http://forecast.weather.gov/MapClick.php?lat=37.77492773500046&lon=-122.41941932299972'

try:

# 调用get函数对请求的url返回一个response对象

web_page = requests.get(weather_url).text

except Exception as e:

print('Error code:', e.code)

# 通过BeautifulSoup解析和获取已爬取的网页内容

soup = BeautifulSoup(web_page, 'html.parser')

soup_forecast = soup.find(id='seven-day-forecast-container')

# 找到所需要部分的内容

date_list = soup_forecast.find_all(class_='period-name')

desc_list = soup_forecast.find_all(class_='short-desc')

temp_list = soup_forecast.find_all(class_='temp')

# 将获取的内容更好地打印出来

for i in range(9):

date = date_list[i].get_text()

desc = desc_list[i].get_text()

temp = temp_list[i].get_text()

print('{} - {} - {}'.format(date, desc, temp))执行效果:

Today - DecreasingClouds - High: 62 °F

Tonight - Mostly Clear - Low: 49 °F

Monday - Sunny - High: 70 °F

MondayNight - Mostly Clear - Low: 48 °F

Tuesday - Sunny - High: 68 °F

TuesdayNight - Mostly Clear - Low: 46 °F

Wednesday - Mostly Sunny - High: 64 °F

WednesdayNight - Mostly Clear - Low: 47 °F

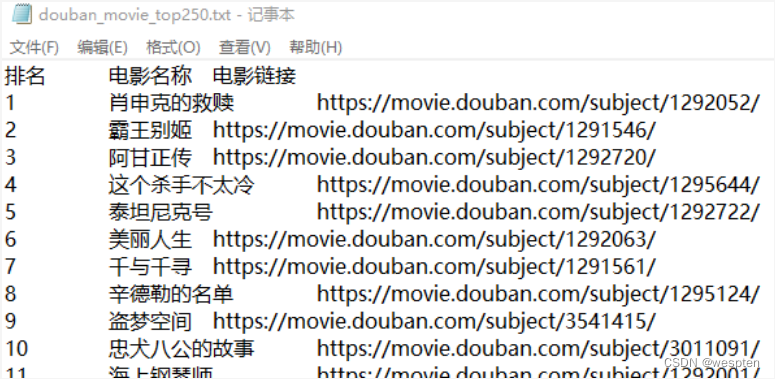

Thursday - Sunny - High: 62 °F2)爬取豆瓣电影 TOP 250 的电影名与链接

import requests

from bs4 import BeautifulSoup

from fake_useragent import UserAgent # 伪装请求头的库

ua = UserAgent()

movie_top250 = 'https://movie.douban.com/top250?start={}'

with open('C:\\Users\\juno\\Desktop\\douban_movie_top250.txt', 'w') as file:

file.write('排名\t电影名称\t电影链接\n')

# 每页展示25部电影,因此需要遍历10页

for i in range(10):

start = i * 25

visit_url = movie_top250.format(start)

crawler_content = requests.get(visit_url, headers={"User-Agent": ua.random}).text

soup = BeautifulSoup(crawler_content, 'html.parser')

all_pic_divs = soup.find_all(class_='pic')

for index, each_pic_div in enumerate(all_pic_divs):

movie_name = each_pic_div.find('img')['alt']

movie_href = each_pic_div.find('a')['href']

print('{}\t{}\t{}\n'.format(index+1+start, movie_name, movie_href))

file.write('{}\t{}\t{}\n'.format(index+1+start, movie_name, movie_href))执行效果:

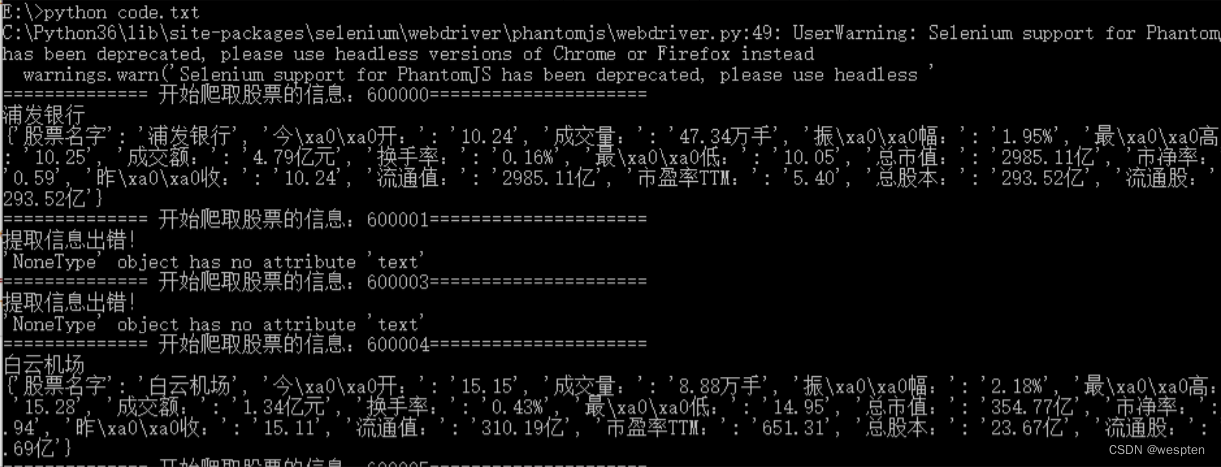

3)爬取股票信息

import requests

import re

from selenium import webdriver

from bs4 import BeautifulSoup

import time

import json

# 通过正则,从股票列表页面,获取所有的股票编号

def get_stock_no_list(url):

r = requests.get(url)

html = r.text

# print(html)

stock_codes = re.findall(r'php\?stockcode=(\d+)"', html)

return stock_codes

# print(get_stock_no_list(url))

# 使用无头浏览器获取页面js执行后的源码

def get_page_souce(driver, url):

driver.get(url)

html = driver.page_source

return html

# 用bs4把信息提取出来,保存到文件中,

def save_stock_info_to_file(html, file_path):

infoDict = {}

if html=="":

return None

soup = BeautifulSoup(html, 'html.parser')

# 通过find方法,使用h1标签和id属性,确定h1这个元素,在用find(i)找到它下面的i元素,

# 再用.text,取到i元素的文本---》股票名字

try:

print(soup.find("h1", attrs={'id':"stockName"}).find("i").text)

stock_name = soup.find("h1", attrs={'id':"stockName"}).find("i").text

infoDict["股票名字"]= stock_name

ths = soup.find("div", attrs={'id':"hqDetails"}).find_all("th")

tds = soup.find("div", attrs={'id':"hqDetails"}).find_all("td")

for i in range(len(ths)):

key = ths[i].text

value = tds[i].text

infoDict[key]=value

print(infoDict)

with open(file_path, "a", errors="ignore") as fp:

fp.write(json.dumps(infoDict, ensure_ascii=False))

except Exception as e:

print("提取信息出错!")

print(e)

# 股票列表的网址

stock_list_url = 'http://www.bestopview.com/stocklist.html'

# 股票详情页面网址

url = "http://finance.sina.com.cn/realstock/company/sh600121/nc.shtml"

# 浏览器所在位置

path = r'E:\phantomjs\bin\phantomjs.exe'

# 启动一个无头浏览器

driver = webdriver.PhantomJS(path)

# 获取指定网址的源码

# print(get_page_souce(driver, url))

stock_list = get_stock_no_list(stock_list_url)

for stock_no in stock_list[:20]:

stock_info_url = "http://finance.sina.com.cn/realstock/company/sh%s/nc.shtml" %stock_no

html = get_page_souce(driver, stock_info_url)

print("============== 开始爬取股票的信息:%s=====================" %stock_no)

save_stock_info_to_file(html, "e:\\stock_info.txt")执行效果:

2、XPath表达式

1. Xpath 简介

XPath 即为 XML 路径语言(XML Path Language),它是一种用来定位 XML 文档中某部分内容的所处位置的语言。

XPath 基于 XML 的树状结构,提供在数据结构树中找寻节点的能力。起初 XPath 提出的初衷是将其作为一个通用的、介于 XPointer 与 XSL 间的语法模型。但是 XPath 很快的被开发者采用来当作小型查询语言。

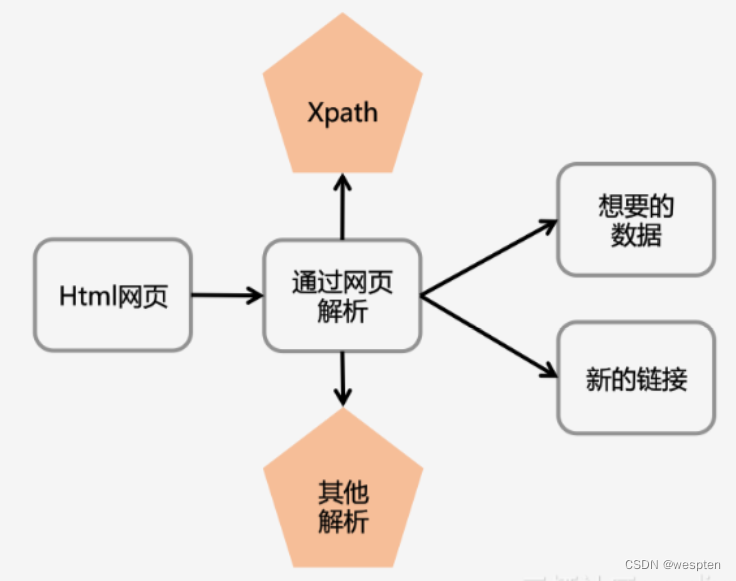

Xpath 解析网页的流程:

-

首先通过 Requests 库获取网页数据;

-

通过网页解析,得到想要的数据或者新的链接;

-

网页解析可以通过 Xpath 或者其它解析工具进行,Xpath 是一个非常好用的网页解析工具。

常用的网页解析:

- 正则表达式:使用比较困难,学习成本较高。

- BeautifulSoup:性能较慢,相对于 Xpath 较难,在某些特定场景下有用。

- Xpath:使用简单,速度快(Xpath 是 lxml 里面的一种),是抓取数据最好的选择。

2. lxml模块

lxml作为BeautifulSoup的解析器对网页源代码进行解析,其实lxml本身就是一个功能强大的第三方模块,该模块中的etree类可以将网页源代码实例化为一个etree对象,该对象支持使用XPath表达式进行标签的定位,从而获取想要的数据。

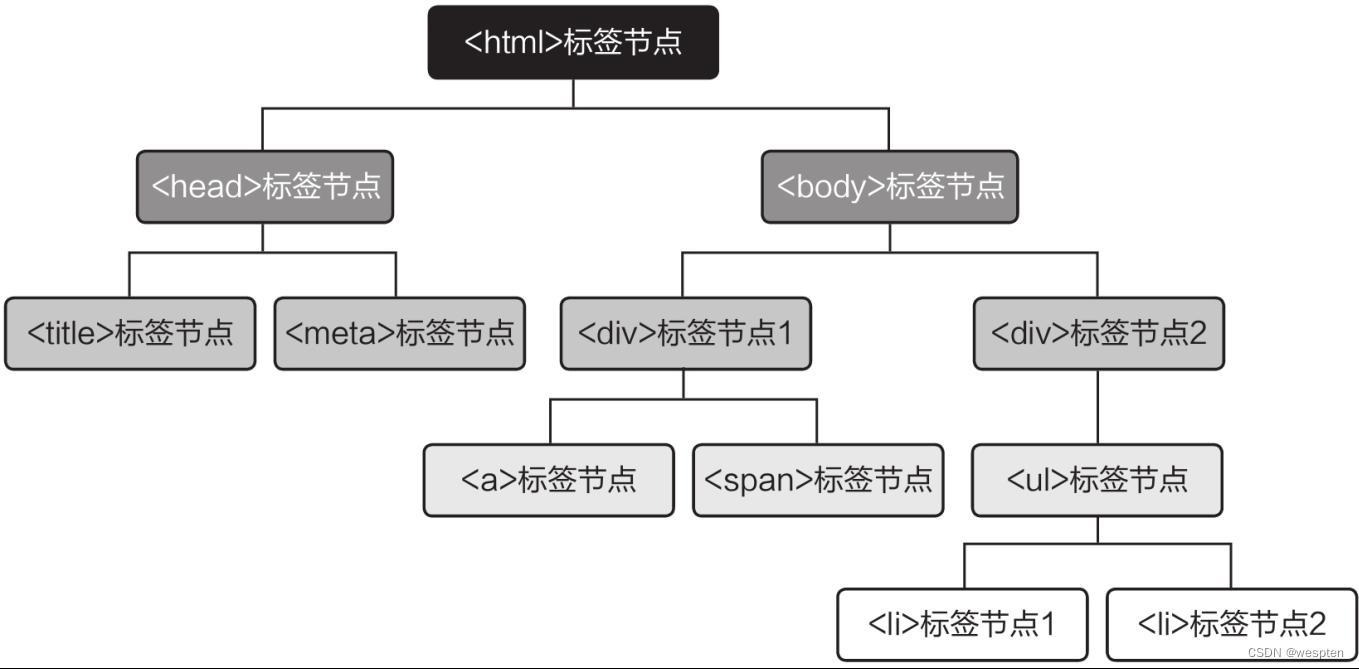

创建为etree对象后的网页源代码可以视为一个树形结构,每个标签是树的一个节点,节点之间为平级或上下级关系,通过上级能定位到下级,如下图所示。而XPath表达式则描述了从一个节点到另一个节点的路径,通过标签的属性或名称定位到上级标签,再通过路径定位到该上级标签的任意下级标签。

使用lxml模块前需要通过pip命令安装该模块。需要注意的是,由于lxml模块的部分版本没有集成etree类,建议在安装时要指定模块的版本。

例如,“pip install lxml==4.5.2”就表示指定安装4.5.2版本的lxml模块,这个版本的模块集成了etree类。

3. lxml路径选择语法

1)语法规则

表达式 描述

nodename 选取此节点的所有子节点。

/ 子元素。

// 后代元素。

. 选取当前节点。

.. 选取当前节点的父节点。

@ 选取属性(获取属性的值)。

举例:

路径表达式 结果

bookstore 选取 bookstore 元素的所有子节点。

/bookstore 选取根元素 bookstore。注释:假如路径起始于正斜杠( / ),则此路径始终代表到某元素的绝对路径!

bookstore/book 选取属于 bookstore 的子元素的所有 book 元素。

//book 选取所有 book 后代元素,而不管它们在文档中的位置。

bookstore//book 选择属于 bookstore 元素的后代的所有 book 元素,而不管它们位于 bookstore 之下的什么位置。

//@lang 选取名为 lang 的所有属性(获取所有名为lang属性的值)。

2)谓语

路径表达式 结果

/bookstore/book[1] 选取属于 bookstore 子元素的第一个 book 元素。

/bookstore/book[last()] 选取属于 bookstore 子元素的最后一个 book 元素。

/bookstore/book[last()-1] 选取属于 bookstore 子元素的倒数第二个 book 元素。

/bookstore/book[position()<3] 选取最前面的两个属于 bookstore 元素的子元素的 book 元素。

//title[@lang] 选取所有拥有名为 lang 的属性的 title 元素。

//title[@lang=’eng’] 选取所有 title 元素,且这些元素拥有值为 eng 的 lang 属性。

/bookstore/book[price>35.00] 选取 bookstore 元素的所有 book 元素,且其中的 price 元素的值须大于 35.00。

/bookstore/book[price>35.00]/title 选取 bookstore 元素中的 book 元素的所有 title 元素,且其中的 price 元素的值须大于 35.00。

3)通配符

通配符 描述

* 匹配任何元素节点。

@* 匹配任何属性节点。

node() 匹配任何类型的节点。

通配符举例:

路径表达式 结果

/bookstore/* 选取 bookstore 元素的所有子元素。

//* 选取文档中的所有元素。

//title[@*] 选取所有带有属性的 title 元素。

4)|或运算符

路径表达式 结果

//book/title | //book/price 选取 book 元素的所有 title 和 price 元素。

//title | //price 选取文档中的所有 title 和 price 元素。

/bookstore/book/title | //price 选取属于 bookstore 元素的 book 元素的所有 title 元素,以及文档中所有的 price 元素。

python2.7、python3.6中代码:

# coding:utf-8

# 网络爬虫库lxml的应用

from lxml import etree

print(u'解析html(具有自动修复功能)')

text = '''

<div>

<ul>

<li class="item-0"><a href="link1.html">first item</a></li>

<li class="item-1"><a href="link2.html">second item</a></li>

<li class="item-inactive"><a href="link3.html"><span class="bold">third item</span></a></li>

<li class="item-1"><a href="link4.html">fourth item</a></li>

<li class="item-0"><a href="link5.html">fifth item</a>

</ul>

</div>

'''

html = etree.HTML(text)

result = etree.tostring(html)

print(result)

# 将字符串写入文件

fh = open('test.html', 'w')

fh.write(result.decode("utf8")) #fh.write(result)

fh.close()

print(u'读取文件(要求html代码完整)')

html = etree.parse('test.html') #只能解析本地html、xml文件

result = etree.tostring(html, pretty_print=True)

print(result)

print(u'获取所有的 <li> 标签')

html = etree.parse('test.html') # 创建dom树

print(type(html))

result = html.xpath('//li') # 获取元素列表

print(result)

print(len(result)) # 获取列表长度

print(type(result))

print(type(result[0])) # 获取元素

result = html.xpath('//li/@class') # 获取 <li> 标签的所有 class属性的值

print(result)

result = html.xpath('//li/a[@href="link1.html"]') # 获取 <li> 标签下 href 为 link1.html 的 <a> 标签

print(result)

result = html.xpath('//li//span') # 获取 <li> 标签下的所有后代元素 <span> 标签

print(result)

result = html.xpath('//li/span') # 获取 <li> 标签下的所有子元素 <a> 标签

print(result)

result = html.xpath('//li/a//@class') # 获取 <li> 标签下的所有a元素的后代 class

print(result)

result = html.xpath('//li[last()]/a/@href') # 获取最后一个 <li> 下的 <a> 的 href属性

print(result)

result = html.xpath('//li[last()-1]/a') # 获取倒数第二个li元素下的a元素列表

print(result[0].text) # 打印输出元素文本

result = html.xpath('//*[@class="bold"]') # 获取 class 为 bold 的标签名

print(result[0].tag)

4. lxml模块使用

1)实例化etree对象

要使用XPath表达式进行数据解析,首先需要实例化一个etree对象,具体方法有两种,分别介绍如下。

(1)etree.parse('HTML文档路径')

对于本地HTML文档,使用parse()函数进行etree对象的实例化。

演示代码如下:

1 from lxml import etree

2 html = etree.parse('test1.html') #将HTML文档加载到etree类中,实例化成一个名为html的etree对象(2)etree.HTML(网页源代码)

对于爬虫程序从网站服务器获取到的网页源代码字符串,使用HTML()函数进行etree对象的实例化。

演示代码如下:

1 import requests

2 from lxml import etree

3 headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36'}

4 response = requests.get(url='https://www.baidu.com', headers=headers) # 获取响应对象

5 result = response.text # 获取响应对象中的网页源代码

6 html = etree.HTML(result) # 将获取的网页源代码加载到etree类中,实例化成一个名为html的etree对象2)用XPath表达式定位标签并提取数据

完成etree对象的实例化后,就可以使用XPath表达式定位标签并提取数据了。

(1)定位标签

XPath表达式提供了多种定位标签的方法,下面以开头的树状图为例,分别进行介绍。

- 标签名定位

假设要定位<ul>标签节点下的所有<li>标签节点,在图中从下往上逆向推导可知,路径是从上往下依次定位<html>标签节点→<body>标签节点→<div>标签节点2→<ul>标签节点→<li>标签节点1、<li>标签节点2。那么如何表达每个标签节点之间的层级关系呢?很简单,用“/”表示一个层级,用“//”表示多个层级,因此,上述路径的XPath表达式为“/html/body/div[1]/ul/li”。

如果需要不加区分地定位页面中的所有<li>标签,也可以用“//”表示<li>标签节点之上的每一级标签节点,对应的XPath表达式为“//li”。

- 索引定位

etree对象的每一个层级都是一个包含所有标签节点的列表,如果同一层级中有多个同名的标签节点,使用列表切片就能定位到所需的标签节点,即通过索引定位。

- 属性定位

在复杂的网页中,每个标签都有其属性,此时可以通过属性进行定位。

演示代码如下:

1 import requests

2 from lxml import etree

3 headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36'}

4 response = requests.get(url='https://www.baidu.com', headers=headers)

5 result = response.text

6 html = etree.HTML(result) # 实例化etree对象

7 print(html.xpath('//*[@class = 'title']')) # 用class属性定位标签第7行代码中的“//”表示多个层级,处于XPath表达式的开头代表从任意层级开始定位;“*”代表任意标签;“[@class = 'title']”代表定位class属性值为title的任意标签。使用这种方法能定位到指定属性的任意标签。

如果拥有同一个class属性值的标签不止一个,可考虑用id属性值来定位,因为在同一个网页中一个id属性值通常只能出现一次。如果还不能达到目的,可用其他属性来定位,也可将上述XPath表达式中的“*”替换为指定的标签名称,如html.xpath('//p[@class = 'title']')。

- 逻辑运算定位

如果使用上述方法仍然不能满足要求,可以配合逻辑运算来进行更精确的定位。

演示代码如下:

1 html.xpath('//p[@class="title" and @name="color"]')

2 html.xpath('//p[@class="title" or @name="color"]')第1行代码中的“and”表示定位同时满足两种属性条件的标签节点。第2行代码中的“or”表示定位满足两种属性条件中的任意一个条件的标签节点。

(2)提取文本内容和属性值

定位到标签节点后,可在XPath表达式后面添加“/text()”来提取该节点的直系文本内容,添加“//text()”来提取该节点下的所有文本内容,添加“/@属性名”来提取该节点的指定属性值。

演示代码如下:

1 html.xpath('//*[@class="title"]/text()')

2 html.xpath('//*[@class="title"]//text()')

3 html.xpath('//*[@class="title"]/@id')3)快速获取标签节点的XPath表达式

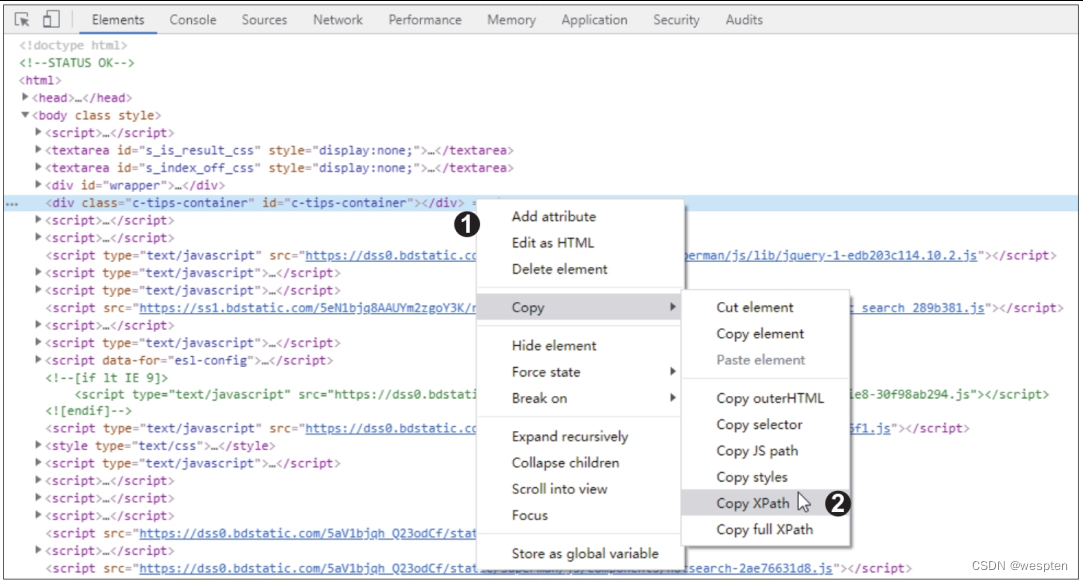

XPath表达式虽然不复杂,但编写时还是需要费点心思,那么有没有更快捷的方法来获取XPath表达式呢?答案是肯定的。使用谷歌浏览器开发者工具的右键快捷菜单命令就能快速获取XPath表达式。

在谷歌浏览器中打开一个网页,然后打开开发者工具,在“Elements”选项卡下的网页源代码中右击要获取XPath表达式的标签,在弹出的快捷菜单中执行“Copy>Copy XPath”命令,如下图所示,即可复制该标签的XPath表达式。随后就可以将复制的XPath表达式粘贴到爬虫代码中使用了。

5. lxml模块使用案例

使用 Xpath 解析网页数据的步骤:

- 从 lxml 导入 etree;

- 解析数据,返回 xml 结构;

- 使用 .xpath() 寻找和定位数据。

import requests

from lxml import etree

from fake_useragent import UserAgent # 伪装请求头的库

# 伪装请求头中的浏览器

ua = UserAgent()

url = "https://book.douban.com/subject/27147922/comments/"

# html数据,使用requests获取

# 写爬虫最实用的是可以随意变换headers,一定要有随机性。ua.random支持随机生成请求头

r = requests.get(url, headers={"User-Agent": ua.random}).text

# print(r)

# 解析html数据

s = etree.HTML(r)

# 使用.xpath()

print(s.xpath('//*[@id="comments"]/div[1]/ul/li[1]/div[2]/p/span'))

# [<Element span at 0x24ee3701a08>]

# 获取文本,加上/text()

print(s.xpath('//*[@id="comments"]/div[1]/ul/li[1]/div[2]/p/span/text()'))

# ['周而复始、如履薄冰的生活仍值得庆幸,因为无论是主动还是被动的脱轨,都可能导致万劫不复。吉根是描绘“日常灾难”的大师,所有绝望都薄如蝉翼,美得微妙。']获取Xpath的两种方法:

第一种方法:从浏览器直接复制

- 首先在浏览器上定位到需要爬取的数据;

- 右键,点击“检查”,在“Elements”下找到定位到所需数据;

- 右键——Copy——Copy Xpath,即可完成Xpath的复制。

第二种方法:手写 Xpath

- 获取文本内容用 text()。

- 获取注释用 comment()。

- 获取其它任何属性用@xx,如:src、value 等。

- 想要获取某个标签下所有的文本(包括子标签下的文本),使用 string。

- 如”< p>123< a>来获取我啊< /a>< /p>”,这边如果想要得到的文本为”123来获取我啊”,则需要使用 string。

- starts-with 匹配字符串前面相等。

1 # 手写Xpath

2 import requests

3 from lxml import etree

4

5 url = 'https://book.douban.com/subject/1084336/comments/'

6 r = requests.get(url).text

7

8 s = etree.HTML(r)

9 print(s.xpath('//div[@class="comment"]/p/text()')[0])使用 Xpath 爬取豆瓣图书《小王子》短评网页

import requests

from lxml import etree

from fake_useragent import UserAgent # 伪装请求头的库

# 伪装请求头中的浏览器

ua = UserAgent()

url = 'https://book.douban.com/subject/1084336/comments/'

r = requests.get(url, headers={"User-Agent": ua.random}).text

s = etree.HTML(r)

# 从浏览器复制第一条评论的Xpath

print(s.xpath('//*[@id="comments"]/div[1]/ul/li[1]/div[2]/p/span/text()'))

# 从浏览器复制第二条评论的Xpath

print(s.xpath('//*[@id="comments"]/div[1]/ul/li[2]/div[2]/p/span/text()'))

# 从浏览器复制第三条评论的Xpath

print(s.xpath('//*[@id="comments"]/div[1]/ul/li[3]/div[2]/p/span/text()'))

# 掌握规律,删除li[]的括号,获取全部短评

# print(s.xpath('//*[@id="comments"]/div[1]/ul/li/div[2]/p/span/text()'))

# 手写Xpath获取全部短评

# print(s.xpath('//div[@class="comment"]/p/span/text()'))执行效果:

['十几岁的时候渴慕着小王子,一天之间可以看四十四次日落。是在多久之后才明白,看四十四次日落的小王子,他有多么难过。']

['读了好多年,终于读完了,但是实在共鸣不起来,虽然知道那些道理,但真的觉得没什么了不起啊,是我还太幼稚吗?']

['我早该猜到,在她那可笑的伎俩后面是缱绻柔情啊。花朵是如此的天真无邪,可是,我毕竟太年轻了,不知该如何去爱她。']通过对比可以发现从浏览器复制的 Xpath 中,“li[]”括号中的数字代表对应的第几条评论,直接删除括号,即可获取全部短评。

对于结构清晰的 html 网页,可以直接手写 Xpath,更加简洁且高效。

对于结构复杂的 html 网页,可以通过浏览器复制的方式获取 Xpath。

6. pyquery模块

在线安装方法:cmd中输入”pip install pyquery”。

python2.7、python3.6中代码:

#coding:utf-8

#网络爬虫库pyquery的应用,以下代码同时支持python2和python3

from pyquery import PyQuery as pq

print(u'=====================初始化====================')

doc = pq("<html></html>") #传入html代码

#from lxml import etree

#doc = pq(etree.fromstring("<html></html>")) #可以首先用lxml 的 etree 处理一下代码

doc = pq('http://www.baidu.com') #传入网址

text = '''

<html><body><div>

<ul>

<li class="item-0"><a href="link1.html">first item</a></li>

<li class="item-1"><a href="link2.html">second item</a></li>

<li class="item-inactive"><a href="link3.html"><span class="bold">third item</span></a></li>

<li class="item-1"><a href="link4.html">fourth item</a></li>

<li class="item-0"><a href="link5.html">fifth item</a>

</li></ul>

</div>

</body></html>

'''

#将字符串写入文件

fh = open('test.html', 'w')

fh.write(text)

fh.close()

doc = pq(filename='test.html') #传入本地文件

print(doc.html()) #获取元素的内部html代码

print(type(doc)) #返回类型是PyQuery

li = doc('li') #获取所有的li元素

print(type(li)) #返回类型依然是PyQuery,可以进行二次筛选

print(li.text()) #获取li的内部文本

print(u'=====================属性====================')

p = pq('<p id="hello" class="hello"></p>')('p') #创建dom树后获取标签

print(p.attr("id")) #读取属性值

print(p.attr("id", "plop")) #设置属性值

print(p.attr("id", "hello")) #设置属性值

print(p.addClass('beauty')) #添加class

print(p.removeClass('hello')) #去除class

print(p.css('font-size', '16px')) #设置css值

print(p.css({'background-color': 'yellow'})) #通过列表设置css

print(u'=====================DOM====================')

print(p.append(' check out <a href="http://reddit.com/r/python"><span>reddit</span></a>')) #在内部原有html代码后添加代码

print(p.prepend('Oh yes!')) #在内部原有html代码前添加代码

d = pq('<div class="wrap"><div id="test"><a href="http://cuiqingcai.com">Germy</a></div></div>') #创建一个dom树

td = d('#test') #获取id为test的元素