特征降维

1、简介

特征降维是指通过减少特征空间中的维度,将高维数据映射到一个低维子空间的过程。

在机器学习和数据分析中,特征降维可以帮助减少数据的复杂性、降低计算成本、提高模型性能和可解释性,以及解决维度灾难等问题。特征降维通常分为两种主要方法:特征选择和特征提取。

- 特征选择(Feature Selection):特征选择是指从原始特征中选择一部分最具有代表性和重要性的特征子集,而忽略其他特征。这样可以减少特征的数量,从而降低了维度。特征选择方法可以基于统计检验、信息增益、模型权重等指标来评估特征的重要性,然后选择排名靠前的特征。

- 特征提取(Feature Extraction):特征提取是通过数学变换将原始特征映射到一个新的低维子空间,从而保留数据中的关键信息。常见的特征提取方法包括主成分分析(PCA)、线性判别分析(LDA)、独立成分分析(ICA)等。这些方法通过线性或非线性的映射,将高维数据转化为低维表示,使得新特征具有更强的表达能力。

特征降维的优点包括:

- 减少维度灾难:维度灾难是指在高维空间中,数据稀疏性增加,距离度量失效等问题。特征降维可以减轻这些问题,使得数据更易处理和分析。

- 减少计算成本:高维数据的计算成本较高,特征降维可以降低计算复杂性,提高算法效率。

- 提高模型性能:在一些情况下,特征降维可以提高模型的性能,减少过拟合,提高泛化能力。

- 可视化和解释性:将数据映射到低维空间可以更容易地进行可视化和解释,帮助理解数据中的模式和关系。

特征降维的选择取决于数据的性质、问题的需求和模型的要求。不同的降维方法适用于不同的情况,需要根据具体问题来进行选择和应用。

2、降维

降维是指在某些限定条件下,降低随机变量(特征)个数,得到一组“不相关”主变量的过程

降低随机变量的个数:

相关特征(correlated feature):相对湿度与降雨量之间的相关

正是因为在进行训练的时候,我们都是使用特征进行学习。如果特征本身存在问题或者特征之间相关性较强,对于算法学习预测会影响较大

降维的两种方式:特征选择和主成分分析(可以理解一种特征提取的方式)

3、特征选择

3.1、简述

定义:数据中包含冗余或无关变量(或称特征、属性、指标等),旨在从原有特征中找出主要特征。

特征选择是指从原始数据的特征集合中选择出最具有代表性和重要性的一部分特征,以便用于构建模型、分析数据或解决问题。

特征选择的目标是减少特征的数量,同时保留数据中最具信息量的部分,从而降低计算成本、提高模型性能、加速训练过程和提高模型的可解释性。

特征选择的主要动机是:

- 降低维度:高维数据集中的特征数量可能非常庞大,导致计算和存储开销增加,降低了算法的效率。

- 减少过拟合:过多的特征可能导致模型过于复杂,容易在训练集上表现良好,但在新数据上表现较差(过拟合)。

- 提高模型性能:一些特征可能对模型性能没有贡献,甚至可能带来噪声。通过选择重要的特征,可以提高模型的性能。

- 改善解释性:使用更少的特征可以使模型更容易理解和解释。

特征选择方法可以分为三大类:

- 过滤法(Filter Methods):通过在特征选择之前对特征进行评估和排序,选择与目标变量相关性较高的特征。常用的过滤方法包括方差选择、相关系数、互信息等。

- 包装法(Wrapper Methods):将特征选择视为一个优化问题,根据模型的性能来选择特征。常见的包装方法包括递归特征消除(Recursive Feature Elimination, RFE)和前向选择(Forward Selection)等。

- 嵌入法(Embedded Methods):在模型训练过程中进行特征选择,通过优化模型的性能来选择特征。例如,决策树和正则化线性模型可以在训练过程中剪枝或约束特征的权重。

特征选择方法的选择取决于数据的性质、问题的需求和模型的要求。不同的方法适用于不同的情况,需要根据具体问题来选择和应用。特征选择是数据预处理的重要一环,能够为构建更准确、高效和可解释的机器学习模型奠定基础。

3.2、两种方法

Filter(过滤式):主要探究特征本身特点、特征与特征和目标值之间关联

方差选择法:低方差特征过滤

相关系数

Embedded (嵌入式):算法自动选择特征(特征与目标值之间的关联)

决策树:信息熵、信息增益

正则化:L1、L2

深度学习:卷积等

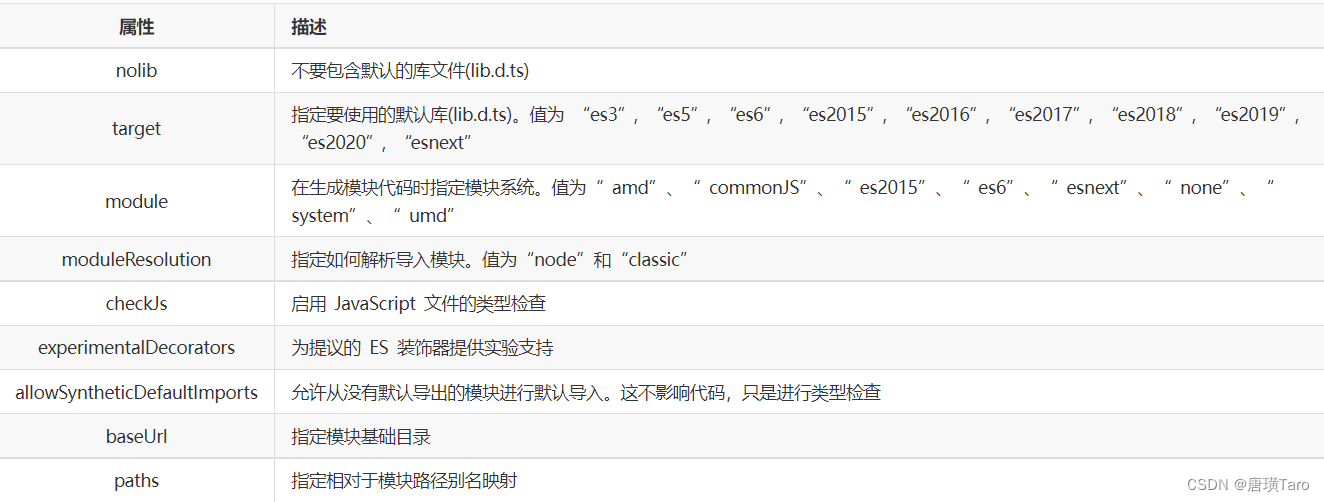

需要使用的模块:sklearn.feature_selection

3.3、过滤式

3.3.1、低方差特征过滤

删除低方差的一些特征,前面讲过方差的意义。再结合方差的大小来考虑这个方式的角度。

特征方差小:某个特征大多样本的值比较相近

特征方差大:某个特征很多样本的值都有差别

API:

sklearn.feature_selection.VarianceThreshold(threshold = 0.0)

删除所有低方差特征

Variance.fit_transform(X)

X:numpy array格式的数据[n_samples,n_features]

返回值:训练集差异低于threshold的特征将被删除。默认值是保留所有非零方差特征,即删除所有样本中具有相同值的特征。

案例实践:

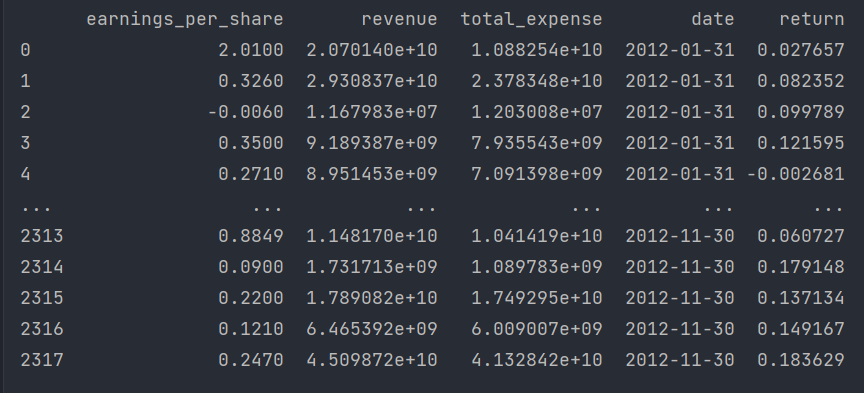

下面进行数据计算,我们对某些股票的指标特征之间进行一个筛选,需要的数据保存在factor_returns.csv文件。

需要除去'index,'date','return'列不考虑(这些类型不匹配,也不是所需要指标)

所以需要的特征如下:pe_ratio,pb_ratio,market_cap,return_on_asset_net_profit,du_return_on_equity,ev,earnings_per_share,revenue,total_expense

下面进行分析:

1、初始化VarianceThreshold,指定阀值方差

2、调用fit_transform

# -*- coding: utf-8 -*-

# @Author:︶ㄣ释然

# @Time: 2023/8/16 10:01

import pandas as pd

from sklearn.feature_selection import VarianceThreshold # 低方差特征过滤

'''

sklearn.feature_selection.VarianceThreshold(threshold = 0.0)

删除所有低方差特征

Variance.fit_transform(X)

X:numpy array格式的数据[n_samples,n_features]

返回值:训练集差异低于threshold的特征将被删除。默认值是保留所有非零方差特征,即删除所有样本中具有相同值的特征。

'''

def variance_demo():

"""

删除低方差特征——特征选择

:return: None

"""

data = pd.read_csv("data/factor_returns.csv")

print(data)

# 1、实例化一个转换器类

transfer = VarianceThreshold(threshold=1)

# 2、调用fit_transform

data = transfer.fit_transform(data.iloc[:, 1:10])

print("删除低方差特征的结果:\n", data)

print("形状:\n", data.shape)

if __name__ == '__main__':

# 设置 Pandas 输出选项以展示所有行和列的内容

pd.set_option('display.max_columns', None)

variance_demo()结果如下:

3.3.2、相关系数

皮尔逊相关系数(Pearson Correlation Coefficient):反映变量之间相关关系密切程度的统计指标

皮尔逊相关系数(Pearson Correlation Coefficient),也称为皮尔逊相关系数或皮尔逊相关系数,是一种用于衡量两个连续变量之间线性关系强度和方向的统计量。它衡量了两个变量之间的线性相关程度。

相关系数的值介于–1与+1之间,即–1≤ r ≤+1。其性质如下:

- 当r>0时,表示两变量正相关,r<0时,两变量为负相关

- 当|r|=1时,表示两变量为完全相关,当r=0时,表示两变量间无相关关系

- 当0<|r|<1时,表示两变量存在一定程度的相关。且|r|越接近1,两变量间线性关系越密切;|r|越接近于0,表示两变量的线性相关越弱

- 一般可按三级划分:|r|<0.4为低度相关;0.4≤|r|<0.7为显著性相关;0.7≤|r|<1为高度线性相关

公式:

参数如下:

n:观测值的数量。

∑:求和符号,表示对所有观测值求和。

x 和 y:分别表示两个变量的观测值。

API:

from scipy.stats import pearsonr

x : (N,) array_like

y : (N,) array_like Returns: (Pearson’s correlation coefficient, p-value)

案例:股票的财务指标相关性计算

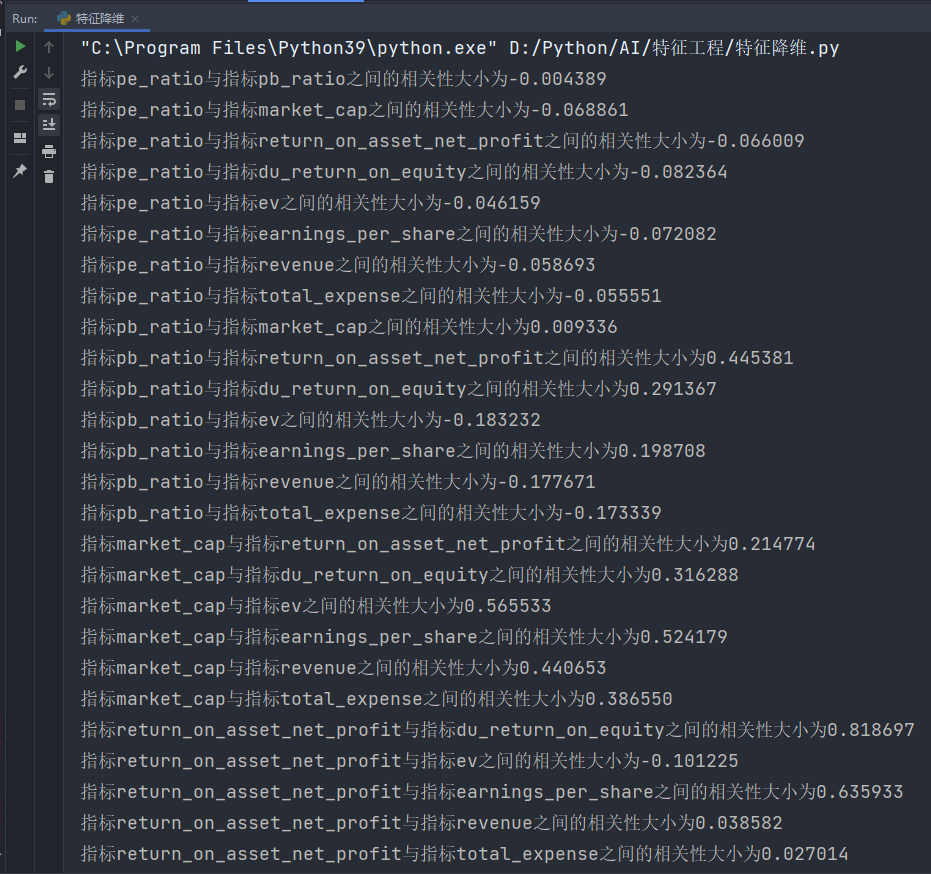

我们刚才的股票的这些指标进行相关性计算, 假设我们以factor = ['pe_ratio','pb_ratio','market_cap','return_on_asset_net_profit','du_return_on_equity','ev','earnings_per_share','revenue','total_expense']这些特征当中的两两进行计算,得出相关性高的一些特征。

分析:两两特征之间进行相关性计算

import pandas as pd

from scipy.stats import pearsonr # 皮尔逊相关系数

'''

from scipy.stats import pearsonr

x : (N,) array_like

y : (N,) array_like Returns: (Pearson’s correlation coefficient, p-value)

'''

def pearsonr_demo():

"""

相关系数计算

"""

data = pd.read_csv("data/factor_returns.csv")

factor = ['pe_ratio', 'pb_ratio', 'market_cap', 'return_on_asset_net_profit', 'du_return_on_equity', 'ev',

'earnings_per_share', 'revenue', 'total_expense']

for i in range(len(factor)):

for j in range(i, len(factor) - 1):

print("指标%s与指标%s之间的相关性大小为%f" % (factor[i], factor[j + 1], pearsonr(data[factor[i]], data[factor[j + 1]])[0]))

if __name__ == '__main__':

# 设置 Pandas 输出选项以展示所有行和列的内容

pd.set_option('display.max_columns', None)

pearsonr_demo()结果:

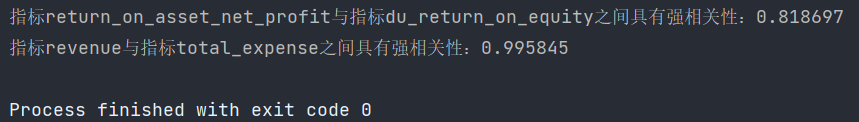

从中可以得出:

指标revenue与指标total_expense之间的相关性大小为0.995845

指标return_on_asset_net_profit与指标du_return_on_equity之间的相关性大小为0.818697

画图:

这两对指标之间的相关性较大,可以做之后的处理,比如合成这两个指标。