使用 ChatGPT 实现通用人工智能,思路打开了。

当前,AI 模型虽然已经涉及非常广泛的应用领域,但大部分 AI 模型是为特定任务而设计的,它们往往需要大量的人力来完成正确的模型架构、优化算法和超参数。ChatGPT、GPT-4 爆火之后,人们看到了大型语言模型(LLM)在文本理解、生成、互动、推理等方面的巨大潜力。一些研究者尝试利用 LLM 探索通往通用人工智能(AGI)的新道路。

近期,来自德克萨斯州大学奥斯汀分校的研究者提出一种新思路 —— 开发任务导向型 prompt,利用 LLM 实现训练 pipeline 的自动化,并基于此思路推出新型系统 AutoML-GPT。

论文地址:

https://papers.labml.ai/paper/35151be0eb2011edb95839eec3084ddd

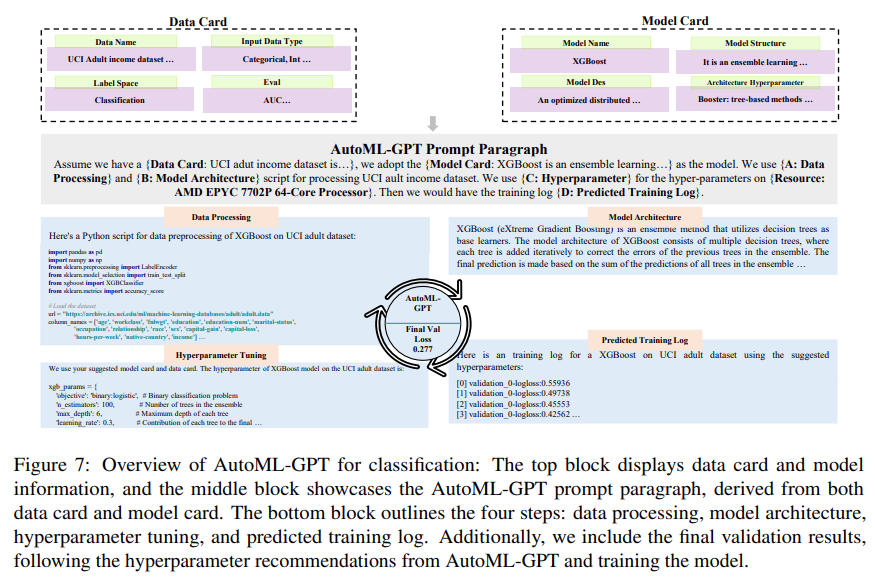

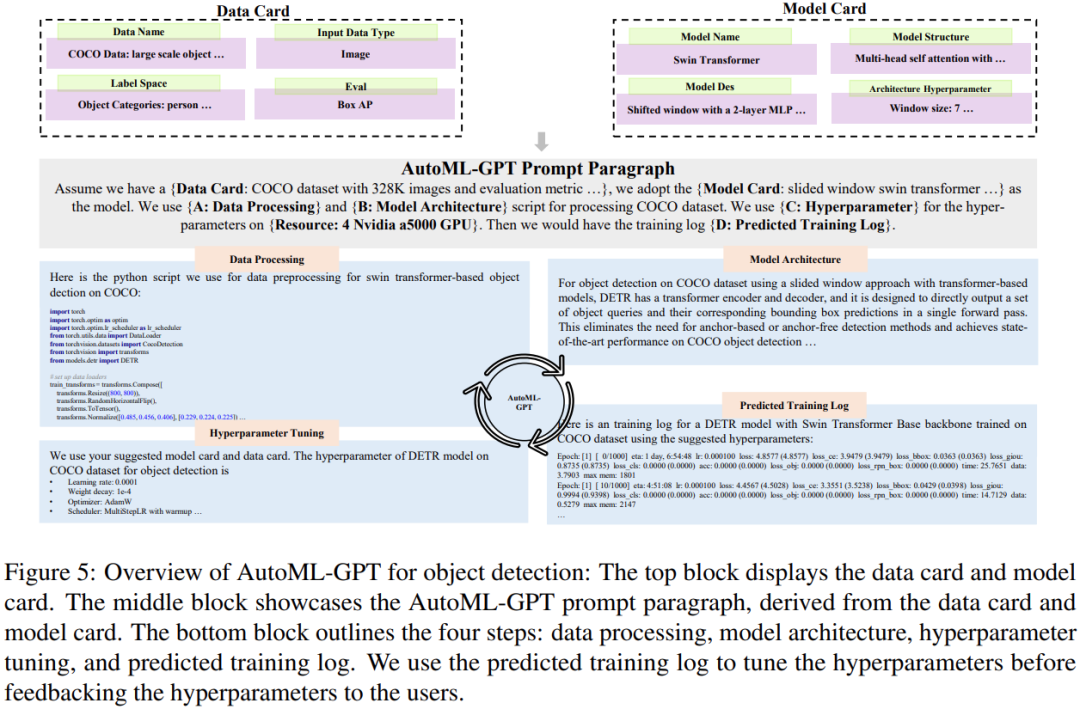

AutoML-GPT 使用 GPT 作为各种 AI 模型之间的桥梁,并用优化过的超参数来动态训练模型。AutoML-GPT 动态地接收来自 Model Card [Mitchell et al., 2019] 和 Data Card [Gebru et al., 2021] 的用户请求,并组成相应的 prompt 段落。最后,AutoML-GPT 借助该 prompt 段落自动进行多项实验,包括处理数据、构建模型架构、调整超参数和预测训练日志。

AutoML-GPT 通过最大限度地利用其强大的 NLP 能力和现有的人工智能模型,解决了各种测试和数据集中复杂的 AI 任务。大量实验和消融研究表明,AutoML-GPT 对许多人工智能任务(包括 CV 任务、NLP 任务)是通用的、有效的。

AutoML-GPT 简介

AutoML-GPT 是一个依赖数据和模型信息来格式化 prompt 输入段落的协作系统。其中,LLM 作为控制器,多个专家模型作为协作的执行者。AutoML-GPT 的工作流程包括四个阶段:数据处理、模型架构设计、超参数调整和训练日志生成。

具体来说,AutoML-GPT 的工作机制如下:

-

通过 Model Card 和 Data Card 生成固定格式的 prompt 段落

-

构建训练 pipeline,在选定的数据集和模型架构上处理用户需求

-

生成性能训练日志并调整超参数

-

根据自动建议的(auto-suggested)超参数调整模型

输入分解

AutoML-GPT 的第一阶段是让 LLM 接受用户输入。为了提高 LLM 的性能并生成有效的 prompt,该研究对输入 prompt 采用特定的指令。这些指令包括三个部分:Data Card、Model Card、评估指标和附加要求。

如下图 2 所示,Data Card 的关键部分由数据集名称、输入数据集类型(如图像数据或文本数据)、标签空间(如类别或分辨率)和默认评估指标组成。

如下图 3 所示,Model Card 由模型名称、模型结构、模型描述和架构超参数组成。通过提供这些信息,Model Card 能告知 LLM 整个机器学习系统使用了哪些模型,以及用户对模型架构的偏好。

除了 Data Card 和 Model Card,用户还可以选择请求更多的评估基准、评估指标或任何约束。AutoML-GPT 将这些任务规范作为高级指令提供给 LLM,用于相应地分析用户需求。

当有一系列需要处理的任务时,AutoML-GPT 需要为每个任务匹配相应的模型。为了达到这一目标,首先系统需要获得 Model Card 和用户输入中的模型描述。

然后,AutoML-GPT 使用 in-context 任务 - 模型分配机制,动态地为任务分配模型。这种方法通过将模型描述和对用户需求的更好理解结合起来,实现了增量模型(incremental model)访问,并提供了更大的开放性和灵活性。

用预测训练日志调整超参数

AutoML-GPT 根据 Data Card 和 Model Card 设置超参数,并通过生成超参数的训练日志来预测性能。该系统自动进行训练并返回训练日志。在数据集上的模型性能训练日志记录了训练过程中收集的各种指标和信息,这有助于了解模型训练进展,找出潜在问题,以及评估所选架构、超参数和优化方法的有效性。

实验

为了评估 AutoML-GPT 的性能,该研究使用 ChatGPT(OpenAI 的 GPT-4 版本)来实现它,并进行多项实验从多个角度展示了 AutoML-GPT 的效果。

下图 4 展示了使用 AutoML-GPT 在未知数据集上训练的结果:

下图 5 展示了 AutoML-GPT 在 COCO 数据集上完成目标检测任务的过程:

下图 6 展示了 AutoML-GPT 在 NQ 开放数据集(Natural Questions Open dataset,[Kwiatkowski et al., 2019])上的实验结果:

该研究还使用 XGBoost 在 UCI Adult 数据集 [Dua and Graff, 2017] 上评估了 AutoML-GPT,以探究其在分类任务上的性能,实验结果如下图 7 所示: